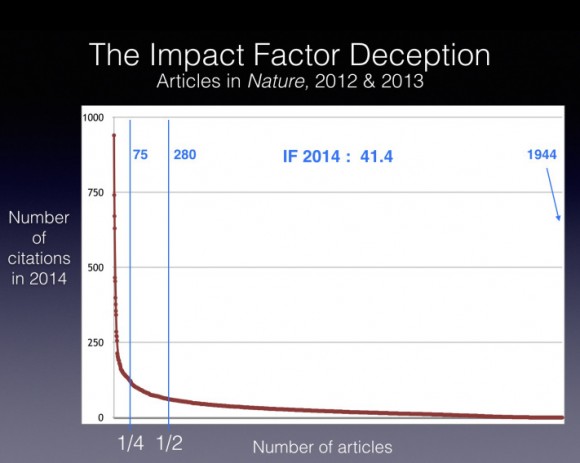

Una leyenda popular afirma que publicar en una revista de alto factor de impacto garantiza un gran impacto (número de citas). El número de citas sigue una ley de potencias: pocos artículos reciben muchas citas y la mayoría reciben muy pocas. La revista Nature tiene un factor de impacto de 41,4 en el JCR 2014. El 25% de sus citas es debido a 75 artículos (el 3,8% de los 1944 publicados entre 2012 y 2013). El 50% de las citas son gracias a 280 artículos (14,4%). Y hay 214 artículos (11%) con una o con ninguna cita.

Puedes creer que esta figura tiene una pequeña trampa, se usa el factor de impacto a 2 años. Tomar el factor de impacto a 5 años hubiera cambiado los porcentajes. Pero todos los estudios bibliométricos rigurosos afirman que estos porcentajes cambian muy poco cuando se toman 5 años en lugar de 2 años. En general, el 15% de los artículos es responsable del 50% de las citas. Todo el mundo debería tener claro que publicar en revistas de alto factor de impacto no garantiza un gran impacto, aunque lo facilita. Por supuesto, también da prestigio y eco mediático, que no es poco.

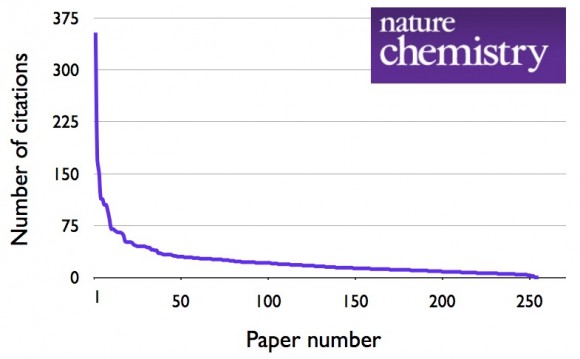

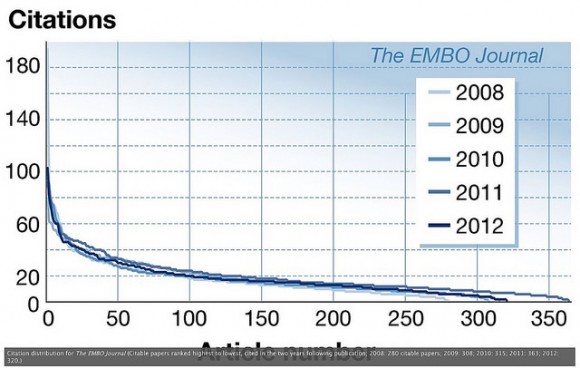

La figura que abre esta entrada ha sido obtenida por Paul Thirion para el blog de Bernard Rentier, «Denouncing the imposter factor,» Ouvertures immédiates, 31 Dec 2015. La segunda figura sobre Nature Chemistry es de Stuart Cantrill, «Nature Chemistry’s 2014 impact factor citation distribution,» The Sceptical Chymist, 05 Dec 2015; recomiendo Stuart Cantrill, @stuartcantrill, «Chemistry journal citation distributions,» Chemical connections, 10 Dec 2015. La tercera figura sobre EMBO Journal es de Stephen Curry, «Data not shown: time to distribute some common sense about impact factors,» Reciprocal Space, 23 Jun 2015; recomiendo Stephen Curry, @Stephen_Curry, «Sick of Impact Factors,» Reciprocal Space, 13 Aug 2012.

Más artículos sobre el factor/índice de impacto en este blog.

Recuerda cómo se calcula el factor de impacto (en español es más correcto índice de impacto pero menos popular) de una revista en el JCR 2014 (Journal Citation Reports de Thomson Reuters). Se consideran todas las citas recibidas en un año (2014) en todas las revistas del Web of Science de Thomson Reuters a todos los artículos de la revista publicados en los dos años anteriores (2012 y 2013). El factor de impacto es el cociente entre el número de citas y el número de artículos publicados.

Tomemos el caso de Nature en el JCR 2014. Publicó 860 artículos en 2013 que recibieron 29753 citas en 2014 y 869 en 2012 citados 41924 veces en 2014. Por tanto, los 1729 artículos de 2012 y 2013 recibieron 71677 citas en 2014, luego su factor de impacto fue 71677/1729 = 41,456.

Recuerda que el factor de impacto a 5 años se calcula con el cociente del número de citas en un año (2014) a los artículos publicados en los últimos cinco años (de 2009 a 2013). En el caso de Nature en el JCR 2014 tenemos 177490 citas a 4298

artículos, luego un valor 177490/4298 = 41,296. No solo es muy similar al factor de impacto a secas, sino que la distribución estadística de las citas también lo es.

En general, el 15% de los artículos es responsable del 50% de las citas que cuentan para el factor de impacto. Además, el 50% de los artículos más citados da cuenta del 90% de las citas. Lo descubrió Per O. Seglen, «The skewness of science,» Journal of the American Society for Information Science 43: 628–638 (1992),doi: 10.1002/(SICI)1097-4571(199210)43:9<628::AID-ASI5>3.0.CO;2-0. Este resultado ha sido confirmado por múltiples estudios posteriores.

Por supuesto, la interpretación de los índices bibliométricos y cienciométricos es delicada y ha de ser realizada caso por caso. Usar el factor de impacto de las revistas en las que se publica para evaluar la excelencia investigadora de un científico, un grupo de investigación o una institución científica no es fiable. Pero siendo fácil de automatizar, todo el mundo lo usa con discreción. Hoy en día hay 12747 instituciones e investigadores de todo el mundo que han firmado la iniciativa DORA, siglas de Declaración de San Francisco sobre la Evaluación de la Investigación (Declaration on Research Assessment). Pero firmar una iniciativa no es lo misma que usarla en la práctica; muy pocos firmantes siguen las directrices DORA.

La iniciativa DORA propone que para evaluar a un investigador hay que leerse sus artículos. Parece obvio, pero es costoso. Se rquiere que un experto o, mejor aún, que un comité de expertos se lea los artículos, los contextualice y evalúe su calidad. Las grandes universidades e instituciones de investigación lo hacen. Pueden permitírselo. Las demás no lo hacen, y quizás por ello no están entre las más excelentes.

El propio Eugene Garfield, inventor del factor de impacto como una herramienta útil para los bibliotecarios, fundador del ISI (Institute for Scientific Information) en 1960, desde 1992 propiedad de Thomson Reuters, advirtió siempre sobre el mal uso de su creación. Un reciente artículo de revisión es Jerome K. Vanclay, «Impact Factor: outdated artefact or stepping-stone to journal certification?» Scientometrics 92: 211-238 (2012), doi: 10.1007/s11192-011-0561-0, arXiv:1201.3076 [cs.DL].

En resumen, no existe lo bueno, bonito y barato. Evaluar la excelencia de forma excelente es caro, pero excelso.

Si me hubieran preguntado a priori, habría aplicado el principio de Pareto y hubiera estimado que el 20% de los artículos generan el 80% de las citas.

Y lo mejor es que a pesar de todo esto… la ciencia avanza. ¿O es que no estuvo 2015 plagado de cosas interesantes, avances en tecnología, conocimiento, descubrimientos?. La respuesta es sí, si hubo mucho progreso en ciencia… a pesar de que parezca que publicar con impacto o sin él tiene o no sentido… a pesar de que se siga especulando con que se publica por publicar pero sin contenidos…

y aunque al final estoy muy de acuerdo con Francis, en que la evaluación de un CV o un proyecto debería ser un proceso mucho más preciso y concienzudo, poniendo contexto a la materia, a la producción etc. la realidad es la que es, y de alguna forma hay que tomar criterios comunes que permitan agilizar los procesos.

Al mismo tiempo el índice de impacto, la posición de autor en el artículo, ser autor de correspondencia, tener co-autoría etc. refleja también el ego del científico, la necesidad de comparación (en vez de buscar las verdades o las respuestas a las preguntas científicas o los descubrimientos). Así, contra una producción salvaje salen los otros índices ( como el h, y similares) que permiten también se utilizan en las evaluaciones…. o no, según criterios.

Y también hay que ser claros, detrás de un índice de impacto alto, suele haber un proceso de revisión algo más duro y riguroso (con todos los peros que se quieran poner, pero claramente no es fácil) que los criterios que proponen las modernas open access (que ahora cada editorial tiene la suya para no perder clientes y mantener la caja a salvo).

Al final, es un trabajo del propio científico escrutar la literatura y determinar si el artículo publicado en open access es de calidad o si lo no lo es el artículo de alto índice de impacto es un fraude, porque claramente también los científicos tenemos tendencias, sesgos y prejuicios.

Saludos