El Comité Nobel del Premio de Física vuelve a sorprendernos combinando dos temas disjuntos cuya única conexión es la física de los sistemas complejos. Por un lado, se premia a los climatólogos Syukuro Manabe (90 años), Univ. Princeton, EE UU, y Klaus Hasselmann (90 años), Instituto Max Planck de Meteorología, Alemania, por sus contribuciones al modelado físico del clima terrestre con el objetivo de cuantificar la variabilidad y predecir de forma robusta el cambio climático. Y por otro lado, se premia a Giorgio Parisi (73 años), Univ. de Roma La Sapienza, Italia, por el descubrimiento de la relación entre desorden y fluctuaciones en sistemas físicos desde la escala atómica a la planetaria, con énfasis en los vidrios de espines (Parisi fue predicho por Clarivate, LCMF, 04 oct 2021).

Complejidad es la palabra de moda en lo que llevamos de siglo XXI. Los sistemas complejos se caracterizan por su aleatoriedad y su desorden, lo que conlleva enormes dificultades a la hora de predecir su comportamiento futuro a largo plazo. Un ejemplo de libro de texto es el cambio climático; predecir su evolución futura tiene una enorme relevancia para la humanidad, pero la complejidad de los procesos involucrados es todo un quebradero de cabeza. En la década de los 1960, Manabe fue pionero en el desarrollo de modelos atmosféricos para predecir el efecto de los aerosoles en el cambio climático; en la década de los 1970, Hasselmann fue pionero en el desarrollo de modelos estocásticos que acoplan el océano y la atmósfera. A principios de los 1980, Parisi estudió el comportamiento de materiales desordenados (en especial vidrios de espines) desarrollando nuevas herramientas matemáticas que han tenido aplicaciones en áreas muy diversas, desde geofísica a biología, neurociencia y aprendizaje automático.

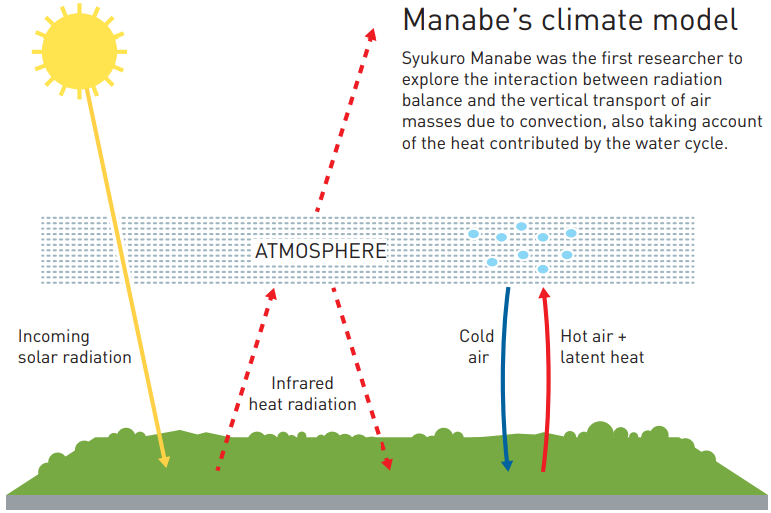

Manabe ha sido galardonado por su modelo climático global publicado en (para mi sorpresa la información Nobel no cita estos dos artículos) Syukuro Manabe, «Climate and ocean circulation. I: the atmospheric circulation and the hydrology of the Earth’s surface,» Mon. Wea. Rev. 97: 739-774 (1969), doi: https://doi.org/10.1175/1520-0493(1969)097<0739:CATOC>2.3.CO;2; «II: the atmosphere circulation and the effect of heat transfer by ocean currents,» Mon. Wea. Rev. 97: 775-805 (1969), https://doi.org/10.1175/1520-0493(1969)097<0775:CATOC>2.3.CO;2. La información Nobel cita estos cuatro artículos: S. Manabe, F. Möller, «On the radiative equilibrium and heat balance of the atmosphere,» Mon. Wea. Rev. 89: 503-532 (1961), doi: https://doi.org/10.1175/1520-0493(1961)089<0503:OTREAH>2.0.CO;2; S. Manabe, R. F. Strickler, «Thermal equilibrium of the atmosphere with a convective adjustment,» J. Atmos. Sci. 21: 361-385 (1964), doi: https://doi.org/10.1175/1520-0469(1964)021<0361:TEOTAW>2.0.CO;2; S. Manabe, R. T. Wetherald, «Thermal equilibrium of the atmosphere with a given distribution of relative humidity,» J. Atmos. Sci. 24: 241-259 (1967), doi: https://dx.doi.org/10.1175/1520-0469(1967)024%3C0241:TEOTAW%3E2.0.CO;2; S. Manabe, R. T. Wetherald, «The Effects of Doubling the CO2 Concentration on the climate of a General Circulation Model,» J. Atmos. Sci. 32: 3-15 (1975), doi: https://doi.org/10.1175/1520-0469(1975)032<0003:TEODTC>2.0.CO;2.

Hasselmann ha recibido el premio por sus modelos climáticos estocásticos, que publicó en K. Hasselmann, «Stochastic climate models. Part I. Theory,» Tellus 28: 473-485 (1976), doi: https://doi.org/10.3402/tellusa.v28i6.11316, y Claude Frankignoul, Klaus Hasselmann, «Stochastic climate models. Part II. Application to sea-surface temperature anomalies and thermocline variability,» Tellus 29: 289-305 (1977), doi: https://doi.org/10.3402/tellusa.v29i4.11362. La información Nobel también cita artículos previos (K. Hasselmann, «Feynman diagrams and interaction rules of wave-wave scattering processes.» Rev. Geophys. 4: 1-32 (1966), doi: https://doi.org/10.1029/RG004i001p00001; K. Hasselmann, «Non-linear interactions treated by the methods of theoretical physics (with application to the generation of waves by wind),» Proc. R. Soc. A 299: 77-100 (1967), doi: https://doi.org/10.1098/rspa.1967.0124) y posteriores (K. Hasselmann, «Optimal Fingerprints for the Detection of Time-Dependent Climate Change,» J. Climate 6: 1957-1971 (1993), doi: https://doi.org/10.1175/1520-0442(1993)006<1957:OFFTDO>2.0.CO;2; K. Hasselmann, «Multi-Pattern Fingerprint Method for Detection and Attribution of Climate Change,» Clim. Dyn. 13: 601-611 (1997), doi: https://doi.org/10.1007/s003820050185; G. Hegerl, K. Hasselmann, et al. «Multifingerprint detection and attribution analysis of greenhouse gas, greenhouse gas-plus-aerosol and solar forced climate change,» Clim. Dyn. 13: 613-634 (1997), doi: https://doi.org/10.1007/s003820050186).

Parisi se ha llevado la mitad del galardón gracias a su método de rotura de la simetría de réplicas para el estudio de vidrios de espines: G. Parisi, «Toward a Mean Field Theory for Spin Glasses,» Phys. Lett. A 73: 203-205 (1979), doi: http://dx.doi.org/10.1016/0375-9601(79)90708-4; «Infinite number of order parameters for spin-glasses ,» Phys. Rev. Lett. 43: 1754-1756 (1979), doi: https://doi.org/10.1103/PhysRevLett.43.1754; «Magnetic properties of spin glasses in a new mean field theory,» J. Phys. A: Math. Gen. 13: 1887-1895 (1980), doi: https://doi.org/10.1088/0305-4470/13/5/047; «Order parameter for spin-glasses,» Phys. Rev. Lett. 50, 1946-1948 (1983), doi: https://doi.org/10.1103/PhysRevLett.50.1946.

El anuncio oficial, la nota de prensa (PDF), la información divulgativa (PDF) y la información avanzada (PDF). Recomiendo leer a Natalie Wolchover, «Work on Earth’s Climate and Other Complex Systems Earns Nobel Prize in Physics,» Quanta Magazine, 05 Oct 2021.

El descubrimiento del caos determinista es uno de los grandes hitos de la matemática del siglo XX. Apoyado en las ideas pioneras de Poincaré sobre el caos hamiltoniano (o estocasticidad), el ejemplo paradigmático es el sistema del matemático y meteorólogo Edward Lorenz, que modela la atmósfera en tres sencillas ecuaciones diferenciales ordinarias: dX/dt = Pr (Y − X), dY/dt = X (Ra − Z) − Y, dZ/dt = X Y − β Z, donde X describe el movimiento convectivo, Y es la diferencia de temperatura entre el aire ascendente y descendente, Z es la desviación no lineal del perfil vertical de temperatura, Pr es el número de Prandtl del fluido (cociente entre las difusiones de momento lineal y calor) y Ra (= Ga Pr) es el número de Rayleigh asociado a la transferencia de calor (Ga es el número de Grashof, el cociente entre las fuerzas de flotación y las fuerzas viscosas). La evolución a largo plazo de un sistema no lineal disipativo tan sencillo es impredecible pues muestra el llamado efecto mariposa (la dependencia fuerte con las condiciones iniciales). Si el sistema meteorológico más sencillo concebible presenta un atractor extraño, qué podemos esperar de un modelo realista de la atmósfera a escala global.

La física de los sistemas estocásticos, caracterizados por un alto grado de desorden, permite combatir la impredecibilidad de los sistemas caóticos deterministas con una enorme número de variables. Con un control adecuado de la variabilidad, la existencia de atractores garantiza que se pueden estimar propiedades globales de las soluciones y su evolución futura. Gracias a ello se ha logrado obtener simulaciones meteorológicas muy precisas a menos de una semana vista (el límite teórico de impredicibilidad ronda los 15 días). Y, también gracias a ello, se han podido obtener simulaciones climáticas a escala global que estiman con gran exactitud la evolución de diferentes parámetros asociados al cambio climático en función de los diferentes escenarios de control de emisiones antropogénicas; obviamente, la política es impredecible —salvo para la psicohistoria de Hari Seldon en la Saga de la Fundación de Isaac Asimov—, aún así algunas de las predicciones para la evolución de la temperatura global publicadas en los 1970 están en buen acuerdo con las observaciones actuales, un éxito que debe mucho al trabajo de Manabe y Hasselmann.

La física de la atmósfera que llevó al descubrimiento del efecto invernadero y el papel de la capa de ozono nació a finales del siglo XIX; destaca el trabajo pionero en 1896 de Svante Arrhenius, Nobel de Química en 1903, quien estableció una relación entre la concentración de dióxido de carbono (CO₂) en la atmósfera y la temperatura global de la superficie terrestre (https://doi.org/ff3hbv). Arrehenius predijo que las emisiones por la quema de combustibles fósiles podrían conducir a un calentamiento global de la Tierra de varios grados Celsius. Thomas Chamberlin en 1899 sugirió que las variaciones en la concentración global de CO₂ podría explicar los procesos de hielo y deshielo (grandes glaciaciones) en la Tierra (https://doi.org/dpp359).

Resumir la historia de las ciencias del cambio climático durante el siglo XX nos llevaría mucho tiempo; el punto clave para este Nobel es que el desarrollo de los ordenadores digitales en la década de los 1940 posbilitó las primeras simulaciones del comportamiento de la atmósfera en los 1950 —con el objetivo de predecir la meteorología durante las campañas militares— realizadas por Jule Charney y John von Neumann (https://doi.org/gzc9). Junto con los avances en los 1950 en la toma de datos atmosféricos de CO₂ a escala global (desde la Antártida a Mauna Loa) se generó el caldo de cultivo ideal para que durante la década de los 1960 muchos climatólogos se planteasen como objetivo el desarrollo de modelos climáticos globales (GCMs).

En los modelos climáticos globales se simulan las ecuaciones de Navier–Stokes (que no son otra cosa que las leyes de Newton aplicadas a la conservación de masa, momento lineal y energía en un fluido) aplicadas a toda la tierra (lo que se suele llamar dinámica de fluidos geofísicos). Manabe llegó en 1959 al Laboratorio de Investigación en la Circulación General (de la atmósfera) de la Oficina Meteorológica de EE UU, liderado por Joseph Smagorinsky; allí desarrollaría sus primeros modelos climáticos. El primer modelo climático global fue desarrollado por Cecil “Chuck” Leith (1923–2016) en 1960 (quizás podría haber recibido el Nobel junto a Manabe). Manabe publicó su primer modelo en 1961 (https://doi.org/dkp7mt), pero no introdujo su famosa técnica de ajuste convectivo hasta 1964 (https://doi.org/c59376). La información Nobel destaca su artículo junto a Richard T. Wetherald en 1967 (https://doi.org/cwrgs3), aunque me parecen más relevantes sus dos artículos como único autor con su modelo que acopla atmósfera y océano de 1969 (https://doi.org/dpjw9d y https://doi.org/dk2j7r), claves para su artículo, de nuevo con Wetherald, en 1975 (https://doi.org/fvscw4).

El modelo climático de Manabe está simplificado hasta el extremo (se simulaba en un ordenador con 0.5 MB de memoria), pero contiene toda la física relevante al problema, que se ha incorporado a modelos mucho más detallados posteriores. No creo que merezca la pena entrar en los detalles del modelo de Manabe (1969). Baste decir que resuelve las ecuaciones primitvas (Navier–Stokes con correcciones geofísicas) en proyección de Mercator usando una formulación en diferencias finitas que conserva la energía; se divide el planeta en un gran océano y un gran continente; y se usa una viscosidad no lineal para simular la mezcla a una escala inferior a la de la malla numérica (~500 km). En este tipo de modelos climáticos es clave la asimilación de datos, es decir, cómo transformar las observaciones meteorológicas en condiciones iniciales para el modelo.

[PS 06 oct 2021] Como nos contó Pedro J. Hdez (@ecosdelfuturo) en Twitteer en junio de 2021: «el artículo de Manabe y Wetherald de 1967 (https://doi.org/cwrgs3) está considerado fundacional para los modelos de circulación general; el modelo de Manabe es el primero que implementa de forma adecuada el efecto de realimentación del vapor de agua, que casi duplica el efecto del CO₂». Gracias a ello pudieron obtener «el primer cálculo moderno de la sensibilidad climática, es decir, del aumento de temperatura que provoca una duplicación de la concentración de CO₂ (de 300 a 600 ppm)». Como muestra la tabla obtuvieron un valor de +2.36 °C (grados Celsius), aunque en 1975 (https://doi.org/fvscw4) lo refinaron a +2.93 °C, gracias al «primer modelo de circulación general que incluía océanos y hielo, confirmando sus resultados y aumentando la confianza en modelos que llevarían a James Hansen 1981 a establecer la relevancia de las emisiones en el calentamiento del s. XX». La predicción teórica de Arrhenius era que duplicar la concentración de CO₂ produciría un incremento de unos 5 °C en la temperatura global, así los modelos de circulación global predecían un resultado compatible que la de este pionero.

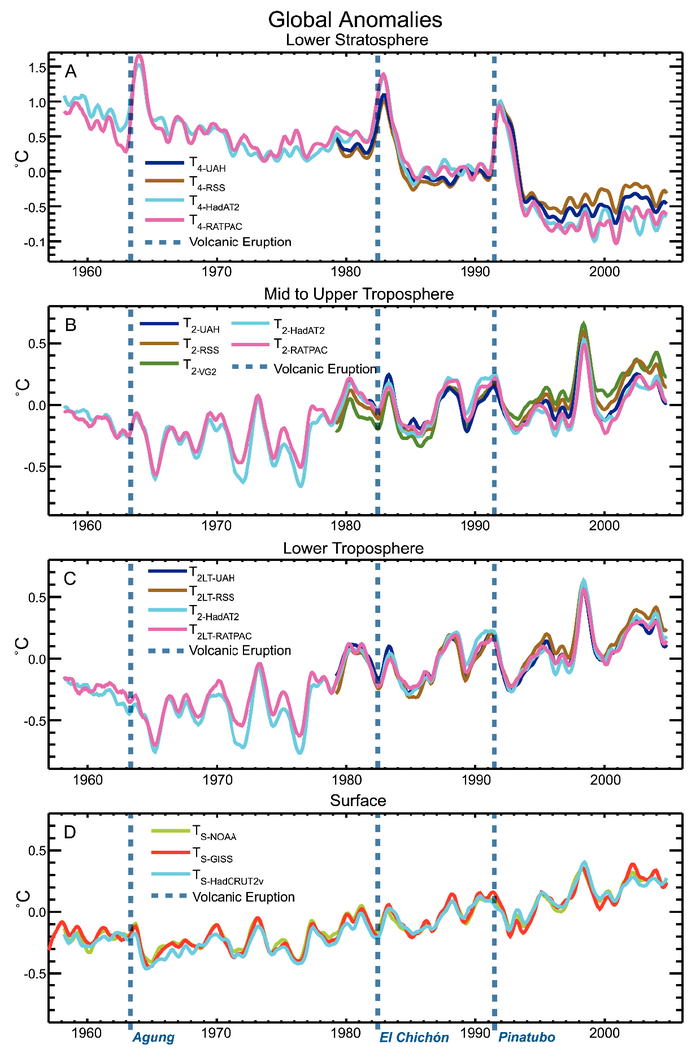

El gran hito del trabajo de Manabe y Wetherland en 1967 fue «predecir el enfriamiento de la estratosfera simultáneo al calentamiento de la troposfera, predicción confirmada por la observaciones. La baja estratosfera se ha enfriado ∼0.3–0.5 K por década desde 1979; la dificultad aquí consiste en separar el efecto de los gases de efecto invernadero del efecto combinado del ozono, aerosoles volcánicos y absorción solar. El artículo de 1975 también confirmaba otra predicción que venía apareciendo en todos los modelos climáticos desde el de Arrhenius de 1896 y capturada en un modelo simple de balance energético por Mikhail Budyko en 1969. La amplificación del calentamiento global a latitudes elevadas, ya predicha en el famoso artículo de Svante Arrhenius de 1896. Si hiciésemos una encuesta entre climatólogos, los grandes merecedores de un Nobel serían probablemente Syukuro Manabe y Richard Wetherald». Y como nos decía Pedro J. Hdez (@ecosdelfuturo) «casi no tiene explicación que ese trabajo pionero e influyente no haya sido todavía objeto de tal galardón». [/PS]

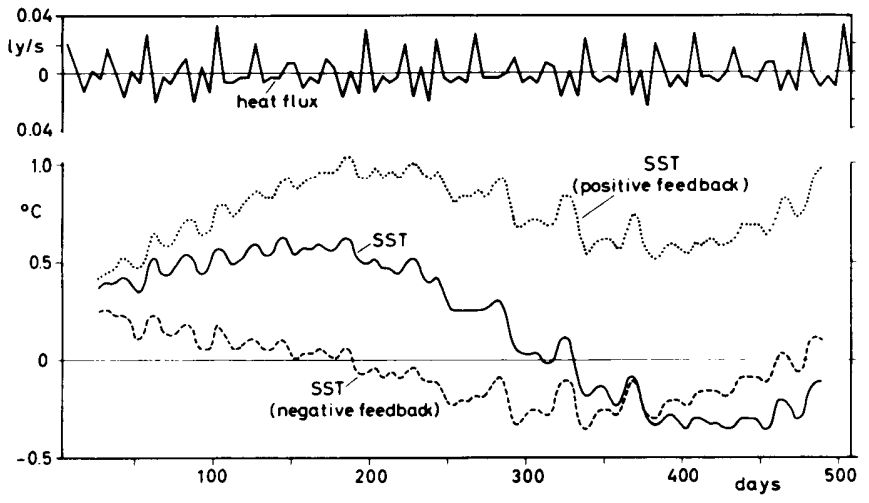

El gran problema de los modelos climáticos es el «ruido asociado a la meteorología» que introduce una estocasticidad en la asimilación de datos con la que hay que lidiar. El trabajo de Klaus Hasselmann, tras unos trabajos curiosos en los que aplicó la técnica de diagramas de Feynman a la interacción de ondas inducidas por el viento en la superficie del océano (https://doi.org/c4p43c y https://doi.org/cm5wkn), se centró en la estocasticidad inducida por la turbulencia y por la dinámica caótica (al hilo de Lorenz). Obtuvo una formulación teórica para la descripción estocástica del clima oceánico (https://doi.org/fx286b y https://doi.org/fx7mrs) que le han llevado hasta el Nobel de Física.

La básica del trabajo de Hasselmann es considerar dos escalas de tiempo, una lenta asociada a la predicción determinista de las ecuaciones de Navier–Stokes simuladas en una malla discreta, y otra rápida asociada al ruido aleatorio introducido por la meteorología y otros fenómenos que ocurren a escalas inferiores a las de la malla. La dinámica rápida se modela como un proceso estocástico de tipo Ornstein–Uhlenbeck, muy usado para describir el movimiento browniano y los caminos aleatorios; la densidad de probabilidad asociada se describe mediante una ecuación de transporte de tipo Fokker–Planck, que permite acotar la variabilidad en las soluciones asociada al ruido. Esta formulación ha permitido entender la memoria climática de los océanos, que actúa en una escala ultralenta de cientos o incluso miles de años.

La validación de los modelos de Hasselmann (https://doi.org/fx7mrs) se logró al comparar el espectro de Fourier de las anomalías de la temperatura superficial del mar con las predicciones teóricas; se observó que la escala lenta se aproxima por 4.5 meses. Durante la década de los 1970 la validación de los modelos climáticos globales con datos se encontró con el sesgo observacional: desde el Año Geofísico Internacional (1957–1958) los programas de observación sistemática a gran escala se centraron en ciertas regiones, como los polos y las grandes corrientes marinas (como la Corriente del Golfo), con lo que eran datos demasiado locales para su ajuste mediante modelos globales. Entre 1979 y 1997, en varios artículos (https://doi.org/b7vx9m, https://doi.org/fxc3zb, https://doi.org/fjjvwx) el grupo de Hasselmann desarrolló la técnica de la huella óptima (optimal fingerprinting), una especie de regresión multivariable adaptada a la atribución del origen de los datos climáticos; gracias a esta técnica se puede estimar de forma separada la variabilidad natural y debida a las emisiones de gases de efecto invernadero de origen antropogénico. Estas técnicas hoy en día son estándares en las investigaciones sobre cambio climático y se usan en la preparación de los informes técnicos de IPCC.

Cambiando completamente de tema, el trabajo más famoso de Giorgio Parisi se centra en el estudio de los vidrios de espines (spin glasses), sistemas magnéticos desordenados; por ejemplo, en un cristal de cobre se pueden sustituir algunos iones de cobre por iones de hierro, que se comportan como un sistema desordenado de pequeños imanes en interacción mutua. En apariencia, en el estado de mínima energía todos los espines (imanes) todos los imanes deberían estar alineados y en cada pareja de imanes uno debería apuntar en un sentido y el otro en sentido contrario, es decir, debería aparecer un estado antiferromagnético; ¿pero qué pasa cuando el número de imanes es impar? Aparece la llamada frustración y el estado de mínima energía deja de ser único y estable, pues el espín frutrado puede moverse por el vidrio de espín entre estados equivalentes entre sí (todos ellos metaestables). La manera más fácil de ver qué es la frustración es tomar una red triangular de espines; dos espines en los vértices tendrán sentidos opuestos, pero el tercero estaría frustrado y podría orientarse de forma aleatoria en cualquiera de dichos sentidos.

Hay un gran número de sistemas físicos con impurezas desordenadas que se comportan como análogos físicos de un vidrio de espín; por ello, en cierto sentido se consideran un sistema modelo de interés en muchas áreas de la física. Los vidrios de espín recabaron la atención de muchos investigadores tras la publicación de un artículo de Edwards y Anderson en febrero de 1975 («Theory of spin glasses,» Journal of Physics F 5: 965-974 (1975), doi: https://doi.org/10.1088/0305-4608/5/5/017); en él se describe un transición de fase de ferromagnético a vidrio de espín en una red de espines con geometría fija. Parte del éxito de este artículo fue que Philip Anderson recibió el Premio Nobel de Física en 1977 por sus trabajos en sistemas magnéticos desordenados. La interacción entre pares de espines en el modelo de Edwards y Anderson era de largo alcance, lo que simplificaba los cálculos usando una teoría de campo medio.

En diciembre de 1975, Sherrington y Kirkpatrick introdujeron un modelo integrable (resoluble) para los vidrios de espín («Solvable Model of a Spin-Glass,» Phys. Rev. Lett. 35: 1792-1976 (1975), doi: https://doi.org/fnjj2b); se trata de un modelo de espines de tipo Ising con interacciones ferro- y antiferromagnéticas frustradas de corto alcance (solo entre espines cercanos). Por desgracia nadie fue capaz de calcular la solución de equilibrio, hasta que llegó nuestro héroe en 1979, Parisi (https://doi.org/fb7bgs, https://doi.org/bqgtkj) introdujo el llamado truco de las réplicas (hoy se prefiere llamarlo rotura de la simetría de réplicas) gracias al cual pudo obtener la tan deseada solución de equilibrio del modelo de Sherrington–Kirkpatrick (para un sistema físico ideal de dimensiones infinitas). Este tipo de soluciones exactas de modelos físicos en materia condensada despertaba mucho interés entre los teóricos en la década de los 1970; así físicos como Miguel A. Virasoro (recientemente fallecido), tras una visita a Roma, reorientaron su carrera hacia estos materiales (el libro de Marc Mezard, Giorgio Parisi y Miguel Ángel Virasoro, «Spin glass theory and beyond,» World Scientific (1987) es de obligada lectura para quienes quieren estudiar vidrios de espines).

El estudio de los vidrios de espines tuvo un gran impacto en la década de los 1980 sobre muchas temas, desde el estudio de las redes de neuronas artificiales (como las redes de Hopfield) hasta la resolución de problemas de optimización usando recocido simulado (simulated annealing). Las técnicas de campo efectivo desarrolladas por Parisi y otros investigadores permitían derivar propiedades generales de estos sistemas. Pero aún quedan muchas por resolver, sobre todo cuando se estudian sistemas realistas con dimensión finita (la aplicación de la rotura de la simetría de réplicas de Parisi a estos sistemas todavía es un problema abierto). Lo más relevante del trabajo teórico es que introdujo una series de parámetros de orden asociados a las réplicas que se pueden estudiar mediante simulaciones numéricas y contrastar con resultados experimentales.

En la última década se ha avanzado mucho en el estudio matemático riguroso de los vidrios de espines; un concepto clave es la ultrametricidad (o los espacios ultramétricos). Estas técnicas permiten entender con todo rigor matemático los avances pioneros de los físicos teóricos como Parisi. También ha habido importantes avances en el campo experimental, sobre todo en la simulación de vidrios de espines usando sistemas de láseres aleatorios. El campo está muy activo en la actualidad, a pesar de que no tiene aplicaciones tecnológicas. Y, por ello, Parisi fue incluido por Clarivate en su lista de candidatos al Nobel en función del número de citas recibidas en los últimos años.

En resumen, espero haberte dado una idea general de las contribuciones de los galardonados con el Nobel. Una discusión más técnica hubiera requerido mucho más espacio. Sin lugar a dudas, a pesar de la sorpresa que ha supuesto el Nobel a los climatólogos Syukuro Manabe y Klaus Hasselmann, junto al físico teórico Giorgio Parisi, se trata de un galardón muy merecido. ¿Qué podría conectar ambos galardones, más allá de la idea de la complejidad? El trabajo con diagramas de Feynman en oceanografía de Hasselmann, en mi opinión, es un lazo de unión muy obvio entre el trabajo de Manabe y el Parisi.

Francis

por que el límite teórico de impredicibilidad ronda los 15 días? cuales son las razones nunca lo podremos superar? que pensas de los trabajos de deep mind en general de machine learning para predicciones?

Mariana, desde los trabajos de Lorenz a finales de los 1960 (p.ej. https://doi.org/csm39f), y habiendo sido confirmado por cientos de estudios en los últimos 50 años (p.ej. https://doi.org/ftv9b2), se sabe que el exponente de Lyapunov asociado a las ecuaciones primitivas de la meteorología es positivo (es decir, los errores crecen exponencialmente); este resultado ya forma parte de todos los libros de texto de meteorología y predicción del tiempo meteorológico. Se estima que el error se duplica en menos de 8 días, se cuadriplica en menos de 10 días, y así sucesivamente, en una cascada de tipo doble periodo, que alrededor de unos 15 días hace imposible predecir nada. El límite de predictibilidad se suele colocar entre 12 y 15 días (yo suelo preferir 15 días, para estar de acuerdo con todas las estimaciones).

Aplicar aprendizaje automático a la resolución de ecuaciones diferenciales está de moda; al fin y al cabo se trata de una simulación de tipo analógico, ajustas los parámetros de un ecuación diferencial (que modela el sistema de aprendizaje) para que siga otra ecuación diferencial (de la que solo usas series de tiempo como observaciones de sus soluciones). Este tipo de técnicas tiene importantes limitaciones en cuanto a predictibilidad, asociadas al número de grados de libertad del sistema que simula y del sistema simulado (todo esto se conoce de los estudios de GPS, general problem solvers, de la década de los 1960); si este último tiene un número exponencial de grados de libertad (como ocurre en la meteorología), se requiere que el primero también los tenga (lo que hace ineficiente el uso de las técnicas de aprendizaje profundo). Así que, en mi opinión, aunque esté de moda, este tipo de técnicas son muy útiles en la predicción rápida a corto plazo (sobre todo cuando se microcablean en hardware), pero son inútiles a medio o largo plazo. Y, por cierto, ninguna técnica de aprendizaje automático puede extender el límite de predictibilidad de un problema, más bien todo lo contrario, siempre lo reduce (por su propia naturaleza de simulación analógica).

Pobre Zeilinger, acabará palamando antes de que se lo den. Me parece increible que ni a el o a Aspect no se lo hayan dado.

Yomismo, todavía es joven, muchos Nobel a trabajos clásicos se reciben alrededor de los 90 años.