He participado en el episodio 348 del podcast Coffee Break: Señal y Ruido [iVoox, iTunes], titulado “Ep348: Especial Señales de los Oyentes», 30 dic 2021. «La tertulia semanal en la que repasamos las últimas noticias de la actualidad científica. En el episodio de hoy: Recopilación de preguntas de los oyentes por varios contertulios habituales. Todos los comentarios vertidos durante la tertulia representan únicamente la opinión de quien los hace… y a veces ni eso. CB:SyR es una colaboración del Museo de la Ciencia y el Cosmos de Tenerife con el Área de Investigación y la UC3 del Instituto de Astrofísica de Canarias».

Por cierto, en relación a mis respuestas, debo confesar que estoy grabando las respuestas en falso directo, sin escuchar después el audio. Selecciono qué preguntas contestar, pienso cómo encararé la respuesta y la grabo de un tirón. Por ello, algunas de mis respuestas en el audio pueden contener algunas erratas; al escucharlos ahora observo que no cito correctamente los títulos de algunos libros y que confundo los nombres de algunos investigadores. Pido perdón por ello.

Ir a descargar el episodio 348.

Aelio Arce por Twitter pregunta: «¿Qué ventajas tiene colocar al James Webb en órbita de halo en torno al punto L2 frente a colocarlo directamente en L2?»

Contesta Héctor Vives-Arias @DarkSapiens: El punto L2 orbita entorno al Sol al mismo ritmo que la Tierra, ya que está situado en la línea recta Sol–Tierra; siendo metaestable, en concreto inestable en la dirección radial Sol–Tierra, pero es estable en la dirección de la órbita. Nos explica por qué no se puede situar el JWST en el punto L2, entre otras razones porque sus motores se se pueden situar a ambos lados y porque sus paneles solares tienen que recibir luz no eclipsada por la Tierra; por ello se coloca en una órbita de tipo halo alrededor del punto L2. El movimiento de esta órbita es sobre todo hacia adelante y hacia atrás en la órbita, en un plano orbital situado un poco desplazado hacia el interior (hacia la Tierra), con objeto de que los motores diurnos puedan estabilizar la órbita de forma periódica. Héctor destaca que se ha comparado con el mito griego de Sísifo, quien empuja una piedra cuesta arriba por una montaña, pero que se le escapa antes de llegar a la cima obligándole a repetir la hazaña eternamente.

Diego por Twitter pregunta: «He oído que [el JWST] puede observar decenas de objetos a la vez, no entiendo muy bien eso. ¿No se supone que el espejo debe apuntar a un objeto en concreto? Si no es así, ¿para qué entonces hacerlo tan grande si con apuntar parte de él es suficiente?»

Contesta Héctor Vives-Arias @DarkSapiens: El objetivo de un espejo más grande es recopilar más luz y observar detalles más pequeños, pero el campo de visión depende de la distancia focal. Uno de los instrumentos obtendrá espectros de galaxias muy lejanas (de las que nos llega como un fotón por segundo), un proceso muy lento si no se usa algún tipo de procesado paralelo. Héctor nos explica cómo funciona el instrumento NIRSPEC (Near InfraRed SPECtrograph) que mide espectros simultáneamente, con una sola observación, más de 100 galaxias a la vez. Para ello se usa una matriz de unos 250 000 microobturadores (microshutters), que se pueden controlar de forma individual, que permiten controlar la luz de entrada a unas rendijas que actúan como prismas para descomponer la luz y obtener el espectro; esto emula lo que se suele hacer en telescopios terrestres usando fibras ópticas. Primero se determina la posición de las galaxias a estudiar y luego se abren los microobturadores correspondientes a sus posiciones, que están asociados a rendijas que actúan como prismas que permiten determinar el espectro. Cuando una galaxia ocupe en el campo visual más de un microobturador se pueden abrir varios en línea. Héctor nos cuenta que hay otra forma de obtener espectros, útil para estrellas (que son objetos puntuales), que no usa rendijas.

Ricky Piki pregunta (o sugiere): Quiero que tratéis el tema de los fractales en la naturaleza.

Contesta Francis Villatoro @emulenews: Lo primero, pido perdón por citar de forma incorrecta el libro de Benoit B. Mandelbrot, «The Fractal Geometry of Nature», y mezclar su título con el del precioso libro de H.-O. Peitgen y P.H. Richter, «The Beauty of Fractals». Al grano, menciono el trabajo de finales del siglo XIX sobre «funciones monstruo» (nombre que Poincaré le dio a las funciones de Weierstrass); estas funciones son continuas en un intervalo, pero no son diferenciables en ningún punto de dicho intervalo. Matemáticos como Cantor, Koch, Sierpiński y Julia introdujeron una serie de conjuntos de puntos y curvas en el plano inspiradas en dichas funciones; estos objetos no tienen dimensión entera (cero para un punto, uno para un segmento, dos para un área, etc.). A principios del siglo XX se introdujeron diferentes definiciones del concepto de dimensión fractal (menciono el contaje de cajas o box counting, y la dimensión de Hausdorff, pero hay muchas más). En la wikipedia tienes una lista de fractales ordenados por dimensión de Hausdorff creciente (List of fractals by Hausdorff dimension).

Mandelbrot, que trabajaba en IBM, redescubrió este tipo de objetos matemáticos y les dio el nombre de fractales. Su libro sobre la geometría fractal de la Naturaleza tuvo mucha repercusión y generó un campo de investigación matemáticas aplicadas que fue muy fructífero en la década de los 1980. Mandelbrot empieza su libro discutiendo la longitud de la costa de Gran Bretaña (en el podcast menciono la frontera entre España y Portugal); su valor depende de la escala de medida, que en el límite de longitud cero lleva a una longitud infinita; si se estima su dimensión fractal se obtiene un valor del orden de D = 1.14. Mandelbrot observó que muchas características de las plantas, animales y otros objetos naturales parecen fractales. La tesis de su libro es que saber que lo son determinando su dimensión fractal puede ser relevante desde un punto de vista aplicado.

Obviamente, los fractales no existen en la Naturaleza (que no permite que haya cosas infinitas, ni infinitesimales). Solo existen los llamados prefractales, que son objetos de apariencia fractal, pero que solo lo son en cierto número de escalas; estos objetos solo tienen dimensión fractal aparente. Durante la década de los 1980 se pensaba que saber esto podría tener utilidad práctica; pero en la actualidad esta idea está de capa caída (los fractales nunca han sido útiles, salvo para los matemáticos, por su belleza intrínseca). En este blog te recomiendo leer mi reseña del libro ««Una nueva manera de ver el mundo. La geometría fractal» por María Isabel Binimelis», LCMF, 15 ago 2015; «Los genes responsables de la estructura tipo fractal de la coliflor y del romanesco», LCMF, 21 0ct 2021; «La naturaleza prefractal de la Naturaleza», LCMF, 10 mar 2010; «Felix Klein, el programa Erlangen, fractales, Mandelbrot y los métodos numéricos en el plano complejo», LCMF, 07 jul 2008; entre otras.

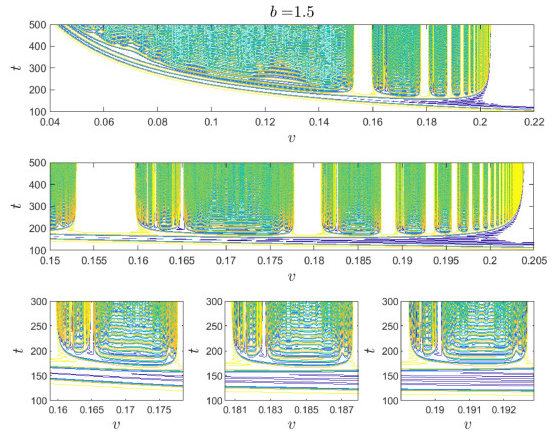

Yo he publicado algunos artículos sobre fractales: Juan A Monsoriu, Francisco R. Villatoro, …, Pedro Fernández de Córdoba, «A transfer matrix method for the analysis of fractal quantum potentials,» European Journal of Physics 26: 603-610 (2005), doi: https://doi.org/10.1088/0143-0807/26/4/005; Juan A. Monsoriu, Francisco R. Villatoro, …, Llúcia Monreal, «Quantum fractal superlattices,» American Journal of Physics 74: 831-836 (2006), doi: https://doi.org/10.1119/1.2209242; Juan C. Castro-Palacio, Francisco R. Villatoro, …, Juan A. Monsoriu, «Self-similar behavior in semiconductor superlattices,» Fractals 20: 89-95 (2012), doi: https://doi.org/10.1142/S0218348X12500089; Francisca Martin-Vergara, Francisco Rus, Francisco R. Villatoro, «Fractal structure of the soliton scattering for the graphene superlattice equation,» Chaos, Solitons & Fractals 151: 111281 (2021), doi: https://doi.org/10.1016/j.chaos.2021.111281; entre otros.

Carlos Ros pregunta: «Una cuestión sobre los elementos químicos que hay o puede haber en el universo. Que yo sepa conocemos los que hay en la Tierra y que forman la tabla periódica (tanto naturales como de laboratorio). ¿Puede haber zonas del universo o incluso de nuestra galaxia que por haber tenido una mayor evolución, tengan elementos químicos que aquí no conocemos? ¿Se ha detectado algo de esto? ¿Es posible detectarlo? ¿Qué propiedades podrían tener estos elementos? ¿Podría haber algún elemento químico natural sin descubrir todavía en la Tierra?»

Contesta Héctor Socas Navarro @hsocasnavarro: Nos recuerda qué es la tabla periódica de los elementos químicos; los elementos que son estables son los únicos que podemos observar en la Naturaleza; en laboratorios nucleares se pueden sintetizar elementos que no son estables, que no se observan en la Naturaleza. Nos cuenta Héctor que en las estrellas encontramos los mismos elementos que en la Tierra, pero quizás con una proporción diferente (que en el caso de las estrellas se llama metalicidad). Todo esto lo sabemos gracias a la huella de los elementos en el espectro de su luz. El origen de todos los elementos son los procesos de nucleosíntesis; los más ligeros se originaron en la nucleosíntesis primordial; los menos ligeros se formaron en las estrellas, explosiones de supernovas y fusiones de estrellas.

No hay regiones astrofísicas (que sepamos) que contengan elementos inestables de vida muy corta, que solo podemos sintetizar en laboratorios nucleares. Héctor destaca que en el universo además de átomos también se observan iones (átomos ionizados), así como moléculas; y que hay objetos, como las estrellas de neutrones, que no están hechos de átomos (es decir, no contienen elementos, salvo en su superficie más externa). Resumiendo, las leyes físicas son las mismas en todo el Universo; puede haber cambios en la concentración de los elementos; pero los elementos químicos son los que son y por ello son los que observamos en todo el universo.

Miquel PC pregunta: Tengo algunas preguntas: (1) habitabilidad de las enanas naranjas, y si un planeta en su zona habitable ofrecería siempre la misma cara a su estrella; (2) ¿el James Webb sería capaz de detectar tecnomarcadores y tecnofirmas?; y (3) ¿sería viable utilizar el Sol como honda gravitatoria?»

Contesta Héctor Socas Navarro @hsocasnavarro: (1) Las enanas naranjas (tipo K) son las que tienen un tipo espectral entre las enanas amarillas (tipo G) como el Sol y las enanas rojas (tipo M) que son las más abundantes en nuestra galaxia. Las enanas naranjas son las estrellas ideales para buscar vida en nuestra galaxia porque son un compromiso intermedio entre las enanas amarillas (menos abundantes que las naranjas y mucho menos que las rojas) y las enanas rojas (que son más violentas que las naranjas y mucho más que las amarillas). Todo planeta tienden a un acoplamiento de marea con su estrella conforme pasa el tiempo (incluso la Tierra está en ello, aunque tardará miles de millones de años); la cuestión clave es la escala temporal que depende de la distancia a la estrella. Para las enanas rojas los planetas están tan cerca que ya deberían presentar acoplamiento de marea. En las enanas naranjas la distancia es mayor y hay planetas en la zona de habitabilidad que aún no muestran la misma cara a su estrella.

(2) La respuesta de Héctor es que sí, cualquier telescopio puede hacerlo. Se ha introducido una escala para los tecnomarcadores, que asigna a las señales emitidas por la Tierra un valor de uno. Muchos telescopios solo pueden observar valores mucho más grandes que uno (por ejemplo, los asociados a esferas de Dyson, que requieren civilizaciones mucho más avanzadas que la humana). El telescopio espacial James Webb es el primero que se espera que pueda observar tecnomarcadores con un valor de la unidad. Por ejemplo, la contaminación industrial podría ser detectada por el JWST en las atmósferas de exoplanetas cercanos.

(3) Héctor interpreta «honda» como «lente», es decir, el uso del Sol como lente gravitacional. No solo la respuesta es que sí, otra cosa es que sea viable. Ya hay propuestas para misiones que usen esta idea, pero son poco viables a corto plazo. No hay un punto focal, sino una línea focal; el punto focal más cercano está a más de 500 UA (unidades astronómicas), más de doce veces la distancia a Plutón (unas 40 UA); pero lo más interesante sería usar un punto focal intermedio, lo que requiere llegar a distancias enormes. Una misión de este tipo es muy tentadora, pero inviable en la actualidad. Más información en Daniel Marín, «Usando el Sol como lente gravitatoria para ver la superficie de planetas extrasolares,» Eureka, 10 abr 2020.

Manuel Valverde Romero pregunta: «Leyendo sobre la interpretación de la curva de las oscilaciones acústicas de bariones, leí que la altura del segundo pico está relacionada con la densidad de materia ordinaria en el momento de la recombinación; para ello se dice que la presión de la radiación no afecta a la materia oscura. Pero sea lo que sea es materia (o energía), pienso que estará sometida a la dualidad onda-corpúsculo y, por ello, debería intercambiar momento lineal con los fotones y así verse afectada por la presión de la radiación. ¿Por qué no es el caso?»

Contesta José Alberto Rubiño, @JARubinoM: Las oscilaciones acústicas de bariones (BAO) se da en el plasma del universo antes de la recombinación (cuando se forman los átomos). Resulta de la interacción de tres fluidos: la materia bariónica (núcleos de hidrógeno y de helio en un plasma con electrones), radiación (fotones) y materia oscura. La gravedad tiende a comprimir la materia, pero la presión de radiación (el efecto de los fotones sobre los electrones y gracias a ello con el plasma) tiende a expandir la materia. El equilibrio entre ambos fenómenos da lugar a las oscilaciones acústicas del plasma, que acaban resultando en las BAO que observamos impresas en el fondo cósmico de microondas y en la distribución de materia actual en el universo. No sabemos lo que es la materia oscura, pero sabemos que no interacciona con la luz; por ello, la partícula de materia oscura es neutra, no tiene carga y no interacciona con los fotones. Por ello, la materia oscura no siente la presión de radiación y no se observan oscilaciones acústicas en la materia oscura.

Las oscilaciones acústicas imprimen en el fondo cósmico de microondas una serie de modos de oscilación. El más grande es el horizonte acústico, es decir, la oscilación más grande que cabe en la caja de resonancia del universo observable, que era unas 1100 veces más pequeño al final de la recombinación. Para calcular su valor se necesita conocer la velocidad del sonido en el plasma que rellenaba el universo, que se estima en un 58 % de la velocidad de la luz en el vacío; la escala BAO que determina el primer pico viene determinada por la distancia que puede viajar el sonido a dicha velocidad desde el big bang hasta unos 380 000 años. El segundo pico (y en general todos los picos pares) están dominados por la presencia de materia bariónica; las oscilaciones se comportan como osciladores armónicos, como un muelle del que cuelga una masa, dada por la cantidad de materia bariónica. Así, fijada la materia oscura, las amplitudes de los picos pares vienen dados por la cantidad de materia bariónica.

Javier Navidad pregunta: «Suponiendo que todo lo que entra en el horizonte de sucesos, está condenado a caer en el agujero negro; el espacio-tiempo se puede entender como un fluido en el que se encuentra la materia; la materia deforma el espacio-tiempo; el espacio-tiempo se está expandiendo, generándose a escalas cosmológicas de tal manera que si tomas objetos suficientemente lejanos, estos pueden estar alejándose entre sí a una velocidad mayor que la de la luz; en las proximidades de un agujero negro, esta expansión no es tan apreciable, por lo que entiendo que debería estar entrando espacio-tiempo dentro del horizonte de sucesos de manera constante; los agujeros negros grandes viven muchísimo tiempo, mucho más de lo que lleva existiendo el universo. Por todo esto, ¿no sería lógico pensar que una vez que se forma un agujero negro de los grandes, si dejas pasar el suficiente tiempo, todo el universo terminará cayendo dentro de él? Y lo que no ha caído es porque se está alejando a más velocidad que la de la luz del mismo, por lo que está causalmente desconectado del mismo y no forma parte de ese universo».

Contesta Francis Villatoro @emulenews: No sé si contesto bien a la pregunta en el audio. Lo que digo es que un agujero negro es espaciotiempo curvado y que no tiene sentido sugerir que el espaciotiempo puede caer en un agujero negro; no hay espaciotiempo entrando en el horizonte. El espaciotiempo es el continente; la materia y la radiación son el contenido. Un agujero negro no es contenido, como un objeto similar a una estrella que está en el espaciotiempo; un agujero negro es continente, un tipo de región curvada del propio espaciotiempo. El contenido puede «caer» en el continente; pero no tiene sentido la «caída» del continente en el continente. No sé si me he explicado bien.

Los agujeros negros son objetos muy compactos (pequeños) y tienen una región de influencia muy pequeña. No le cito en el audio, pero Bondi estimó que el radio de esta región es R ~ M/T ~ 2GM/cₛ² ~ (M/10⁶ M☉)(100 km/s /cₛ)² pc , donde M es la masa del agujero negro, T es la temperatura del entorno, G es la constante de Newton, cₛ es la velocidad acústica de la materia en el entorno y M☉ son masas solares. La velocidad del Sol alrededor de la galaxia es de unos 200 km/s, tomando ese valor como cₛ, el agujero negro Sgr A* de cuatro millones de masas solares influye en una región de 1 pc (el Sol está a 8 kpc); como el centro galáctico es más denso, el resultado es un poco mayor, unos 3 pc. Por ello, Sgr A* es irrelevante a la distancia a la que está el Sol, incluso a distancias mil veces más pequeñas. Por ello es una leyenda urbana que todo lo que hay en las galaxias acaba cayendo en los agujeros negros supermasivos que se encuentran en su centro.

Silvina Settecase pregunta: «Ya sé que la luz es blanca pero ¿tiene diferentes proporciones de los colores que la componen? Me da la impresión que en la Naturaleza hay una enorme variedad de verdes (más que de rojos o azules). ¿Puede tener que ver con las longitudes de onda del visible del Sol?»

Contesta Héctor Socas Navarro @hsocasnavarro: Los colores del arcoiris corresponden a frecuencias de vibración de la luz; por ejemplo, un láser verde emite una luz de color verde casi pura. Pero los demás colores que observamos son ficticios, son colores que se construyen en nuestro cerebro a partir de los sensores (conos) de nuestros ojos a partir de su respuesta al espectro de la luz; dichos colores no corresponden a frecuencias de la luz. Así que un tono de color verde concreto corresponde a infinitos espectros, muchos muy diferentes entre sí; incluso la luz blanca corresponde a muchos espectros muy diferentes. En la luz que incide sobre la superficie de la Tierra influye el espectro solar pero también la atmósfera (como los rojizos de los atardeceres).

Creo que Héctor no contesta la pregunta de Silvina, ¿por qué ella observa más tonos de verdes que de rojos o de azules? La razón es que somos más sensibles al verde. En la retina tenemos conos sensibles a bandas de frecuencias cortas (rojos), medias (verdes) y largas (azules); resulta que la banda de frecuencias intermedia es más ancha, por lo que el ojo humano tiene mayor precisión a la hora de discernir tonos verdes. ¿Por qué? Sin lugar a dudas es producto de la evolución de las especies. Hay que recordar que primates evolucionamos en bosques donde el color verde era predominante. Además, puede influir que el pico de irradiación solar en la superficie de la Tierra se encuentra en dicha región.

Silvina Settecase pregunta: «[Héctor] en algún episodio dijiste que cuando el Sol se convierta en una gigante roja será en cuestión de horas, ¿cómo puede ser tan rápido?»

Contesta Héctor Socas Navarro @hsocasnavarro: Héctor pide disculpas si lo dijo en algún episodio, no recuerda haberlo dicho, pero no es cierto, no ocurre en cuestión de horas. Cuando el Sol se transforme en una gigante roja ocupará un volumen similar a la órbita de la Tierra; la transformación es rápida, pero ocurre en millones de años (no sabemos la cifra exacta); esto es rápido comparada con la vida de una estrella de tipo solar (una decena de miles de millones de años).

Silvina Settecase pregunta: «En el episodio 274, Carlos González dijo que la mayoría de las estrellas son binarias; entonces, ¿el Sol es atípico o raro?»

Contesta Héctor Socas Navarro @hsocasnavarro: La proporción de estrellas que son binarias o están en sistemas múltiples depende de la masa. Las enanas rojas son individuales en un 80 % de los casos; las enanas amarillas como el Sol lo son en un 50 % de los casos; pero para estrellas más masivas son más abundantes los sistemas binarios y múltiples. Para determinar la fracción de todas las estrellas de la galaxia que son binarias tenemos que tener en cuenta que la proporción de las estrellas cambia con el tipo; las más abundantes son las enanas rojas, por ello en total se estima que solo un 30 % de las estrellas son binarias. Así que el Sol no es atípico ni raro en este sentido. Se puede recurrir a la principio antrópìco, quizás en una estrella solar individual sea más fácil la aparición de la vida; pero no lo sabemos con seguridad y esto sería otra cuestión.

Silvina Settecase pregunta: «Sobre Sagitario A*, siempre que se habla de él se dice su equivalente en masas solares y a qué distancia nos encontramos pero, ¿cuánto mide su diámetro o radio?»

Contesta Héctor Socas Navarro @hsocasnavarro: El radio de un agujero negro es el radio de su horizonte, el punto a partir del cual ni la luz puede salir de su interior. Para Sagitario A* el radio es de solo 22 millones de kilómetros, unas 0.14 veces la distancia Tierra-Sol; un tamaño similar a una décima parte de la órbita de Mercurio.

Silvina Settecase pregunta: «En el episodio 280 se habló sobre que el Universo no gira. Pero hay muchas estructuras que giran, entonces mi pregunta es hasta qué estructura deja de girar. Por ejemplo, ¿los cúmulos de galaxias giran? ¿y los supercúmulos?»

Contesta Héctor Socas Navarro @hsocasnavarro: Héctor primero dice que el universo gira a todas las escalas, pero dicho giro es local [luego Héctor se refiere a «todas» las escalas hasta cierta escala pequeña comparada con el tamaño del universo observable ]; así que cuando se promedia sobre grandes escalas el universo no parece estar girando. En los cúmulos galácticos las galaxias más externas giran en casi cualquier dirección y con cualquier orientación respecto al centro de masas del cúmulo; por ello el cúmulo a nivel global no tiene un giro neto (un momento angular medible). Sin embargo, por su formación por colapso, las galaxias siempre están girando. Así que Héctor afirma que todo gira hasta una escala comparable a la de los cúmulos galácticos.

Guillermo García Guerrero pregunta o pide: «Me gustaría que dedicaseis unos millones de instantes al asunto del espacio-tiempo cuantizado. A mí me parece sensato. ¿Qué se sabe de este asunto?»

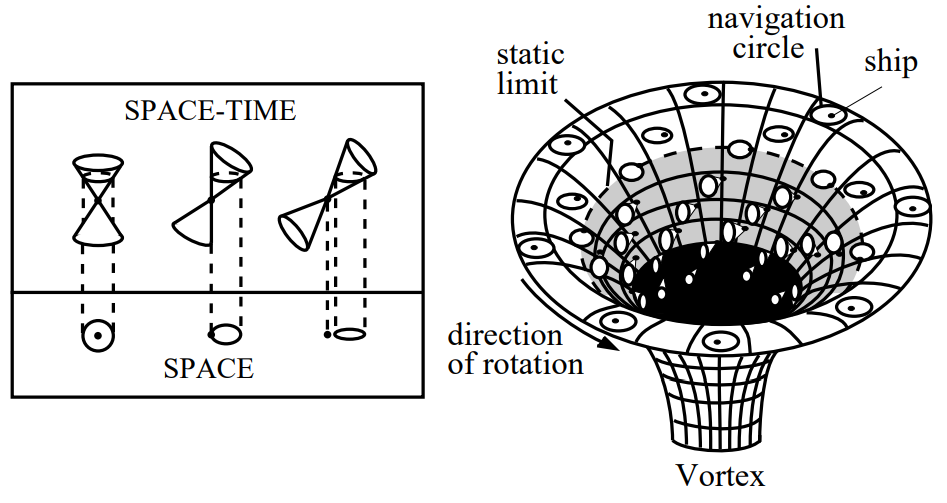

Contesta Francis Villatoro @emulenews: No conocemos la naturaleza cuántica del espaciotiempo. Tenemos varias especulaciones (que sea una sustancia hecha de gravitones, que emerja de supercuerdas en interacción, que emerja de lazos de energía que describen unidades de área, etc.) Recomiendo mi charla «La naturaleza cuántica del espaciotiempo» en el canal de YouTube de Foro de Análisis (fue impartida en la Facultad de Filosofía de la Universidad de Sevilla). También recomiendo mi intervención en el programa 250 del podcast La Fábrica de la Ciencia sobre este tema (LCMF, 30 nov 2016).

Víctor Vilela pregunta: «Una pregunta tonta… si se pudiera viajar a grandes velocidades (la de la luz o superior). ¿Cómo se evitaría chocar contra un cinturón de asteroides, un planeta o cualquier objeto que estuviera en nuestro camino?»

Contesta Héctor Socas Navarro @hsocasnavarro: El espacio está extremadamente vacío, mucho más el espacio interestelar que el interplanetario. Por ejemplo, el cinturón de asteroides no tiene nada que ver con lo que se ve en las películas; Héctor realiza una cuenta de servilleta, los asteroides de más de 10 metros estarían separados por una distancia media de más de cien mil kilómetros en el cinturón de asteroides. Otra cuestión son las llamadas tormentas de polvo interplanetario (la sonda de Galileo se encontró con una); están asociadas al sistema joviano y son muy extensas en el espacio (Galileo tardó más de un mes en atravesar una). Todo esto es independiente de la velocidad de la nave.

En cuanto a lo que pasaría con una nave superlumínica por un motor de curvatura tipo Alcubierre, nos cuenta Héctor que el interior de la burbuja warp está causalmente desconectado de la parte frontal externa de la burbuja; así, todo lo que la nave se encuentre entre el origen de su viaje y su destino se acumularía en una onda de choque en la parte frontal («te lo vas a llevar puesto»). Héctor afirma que sería una «desgracia la llegada de una nave a su destino». Pero, al grano, este tipo de solución matemática no permite construir una nave; así que no hay que preocuparse por este problema.

Darwin Alvarado pregunta: «¿Será posible que se comente sobre energía de punto cero?»

Contesta Francis Villatoro @emulenews: Todo sistema físico realizable en la Naturaleza tiene que tener un mínimo de energía y un estado fundamental asociado a dicha energía mínima; a dicho mínimo de energía se le puede asignar una energía cero y la energía de dicho estado fundamental se denomina energía de punto cero. Si un sistema no tuviera esta energía mínima sería inestable y por tanto es irrealizable en la Naturaleza. Comento que en física cuántica la energía de punto cero suele ser una suma de infinitas contribuciones, lo que conduce a una divergencia (un valor infinito); hay que usar una técnica de renormalización (o de regularización) para evitar este infinito y obtener un valor finito para la energía de punto cero, que se asigna al valor cero.

En física cuántica, la energía de los estados de un sistema es siempre relativa, sus valores son relativos a la energía del punto cero (del estado fundamental). La única teoría en la que la energía de los estados no es relativa, donde los valores absolutos de la energía son relevantes es la gravitación de Einstein (la teoría general de la relatividad). Pero no sabemos cómo cuantizar la gravitación; en esta teoría clásica la energía mínima es cero y está asociada a un espaciotiempo plano.

Alberto Cifrian pregunta: «Creo que entiendo la dualidad onda-corpúsculo. Entiendo que un telescopio capta fotones (corpúsculos) que vienen de muy lejos, y con larga exposición puede integrar todos los que recibe para formar una imagen de objetos débiles. Creo entender que un interferómetro óptico capta la misma imagen en varios equipos y crea patrones de interferencia (onda) igualando los caminos de los distintos haces. Pero los fotones vienen de una estrella enorme, no de un láser casi puntual, así que no son coherentes y hay mezcladas muchas frecuencias, no entiendo cómo consiguen sacar algo en claro. Y cuando pasamos a radiotelescopios que graban sus señales y se hace interferencia calculada, ya no sé si es onda, corpúsculo o magia».

Contesta Héctor Socas Navarro @hsocasnavarro: La interferencia de dos ondas puede ser constructiva, cuando las ondas están en fase y se suman, o destructiva, cuanto están en contrafase y se cancelan. La luz muestra una naturaleza dual, de onda y de partícula, como ilustra el experimento de la doble rendija. Héctor comenta que le gusta entender la naturaleza de la luz como una onda aa todos los efectos, salvo para su detección fotón a fotón. Nos cuenta el experimento de la doble rendija y comenta que se puede usar luz láser, que es luz coherente, pero también se puede usar un luz incoherente, como la luz solar; la luz incoherente cuando atraviesa ambas rendijas da resultado a dos haces que son coherentes entre sí (aunque cada uno sea incoherente en su origen), con lo que se puede observar en la pantalla una patrón de interferencia.

Este es el principio de la interferometría óptica, que se basa en la interferencia entre la fase de los frentes de onda. La luz que proviene de una estrella y llega a dos telescopios es coherente entre sí, aunque hay una diferencia de fase que da lugar a un fenómeno de interferencia. Según el camino óptico recorrido por el frente de onda recogido en cada telescopio (o cada antena en un radiotelescopio) se observarán fenómenos de interferencia; el patrón de interferencia permitirá reconstruir la fase y con ella la imagen.

Miguel Ángel pregunta: «Sugiero dar pautas para ser físico autodidacta… Libros básicos para entender la física fundamental, la mecánica cuántica y la cosmología».

Contesta Alberto Aparici @cienciabrujula: El camino del autodidacta es el camino del autoengaño. Para un físico autodidacta es muy fácil caer en conclusiones erróneas. Nuestra mente tiende al mínimo esfuerzo y por eso tiende a que nos autoengañemos. Siempre es necesario contrastar las ideas con otros que saben mucho más, porque en muchas ocasiones nos aclaran las cosas y nos descubren que estábamos equivocados. El camino del físico autodidacta es un camino demasiado duro y con demasiadas trampas. La recomendación número uno de Aparici es no ser autodidacta; apúntate a un grado de Física a distancia para aprender Física de forma reglada.

¿Libros recomendados? Alberto recomienda las Lecciones de Fisica de Feynman; afirma que cada vez que las lee aprende algo nuevo y le parecen magníficas. Me permito apostillar que no me parece una buena recomendación (lo siento, Alberto); están dirigidas a profesores de física, a licenciados en física, pero no están dirigidas a estudiantes de física, ni mucho menos a físicos autodidactas. Alberto dice que Héctor le ha aconsejado recomendar la serie de libros «The Theoretical Minimum» de Susskind, libros de texto que acompañan a sus cursos en YouTube. Están pensadas para reciclar a lincenciados en Física y como los libros de Feynman tienen el problema de que gustan más a los físicos que a los estudiantes o a los físicos autodidactas.

Jose Luis Kuik pregunta: «A ver, en términos físicos la temperatura es la cantidad de movimiento, o la «velocidad» con la que se mueven las partículas en un cuerpo. A mayor velocidad… mayor temperatura… Mi duda es… ¿el límite de esa temperatura es la velocidad de la luz? Quiero decir, el límite de velocidad al que las partículas se pueden mover es la velocidad de la luz, luego ¿esa velocidad lleva asociada una temperatura? ¿Existe un valor de temperatura máximo el cual no se puede superar en ningún caso?»

Contesta Héctor Socas Navarro @hsocasnavarro: La temperatura está asociada a un estado de equilibrio termodinámico; para un gas de moléculas se requieren que haya muchas partículas para que choquen entre sí y puedan alcanzar un equilibrio termodinámico; la temperatura caracteriza la distribución de Maxwell–Boltzmann para las velocidades de las partículas (o para la energía cinética de las partículas). Si las partículas se mueven a velocidades relativistas (inferiores a la de la luz) la distribución que se usa es la de Maxwell–Jüttner, que está cortada a la velocidad de luz y que se concentra cerca de este límite conforme suben las velocidades de las partículas.

¿Se puede asignar una temperatura a una partícula? Comenta Héctor que se suele abusar del lenguaje y se asigna una temperatura «equivalente» a una partícula para describir su energía cinética (esto es un abuso porque una partícula no es un sistema termodinámico en equilibrio). Si hay una energía cinética máxima para una partícula, entonces habrá una temperatura «equivalente» máxima. Se considera que la energía de Planck es la energía cinética máxima para una partícula; así se define la llamada temperatura de Planck, 1.4 × 10³² K (Kelvin). Explica Héctor que a esta temperatura, la radiación de un cuerpo tendría una longitud de onda que correspondería a la longitud de Planck (que se considera el tamaño mínimo de las cosas en el espacio).

Lucciano Hector pregunta: «Hola, una duda que tengo es ¿cómo es que las ondas gravitacionales pueden alterar permanentemente el espacio-tiempo?»

Contesta Francis Villatoro @emulenews: La verdad, yo no entendía la pregunta. Las ondas gravitacionales no pueden alterar permanentemente el espaciotiempo. Así que grabé una respuesta en esta línea. Pero Héctor tras escucharla me dijo que pensaba que Lucciano se refería a una pieza de Katie McCormick, «Gravitational Waves Should Permanently Distort Space-Time,» Quanta Magazine, 08 Dec 2021. Así que volví a grabar la respuesta para comentar a qué se refiere esta respuesta (aunque Gastón Giribet sería la persona más adecuada para contestar a esta pregunta). La pieza se hace eco de los tres artículos de Éanna É. Flanagan, Alexander M. Grant, …, David A. Nichols, «Persistent gravitational wave observables: general framework,» Phys. Rev. D 99: 084044 (2019), doi: https://doi.org/10.1103/PhysRevD.99.084044,

arXiv:1901.00021 [gr-qc] (31 Dec 2018); Éanna É. Flanagan, Alexander M. Grant, …, David A. Nichols, «Persistent gravitational wave observables: Nonlinear plane wave spacetimes,» Phys. Rev. D 101: 104033 (2020), doi: https://doi.org/10.1103/PhysRevD.101.104033, arXiv:1912.13449 [gr-qc] (31 Dec 2019); Alexander M. Grant, David A. Nichols, «Persistent gravitational wave observables: Curve deviation in asymptotically flat spacetimes,» arXiv:2109.03832 [gr-qc] (08 Sep 2021).

Yo había leído el artículo de McCormick, que me llevó a los artículos de Nichols y sus coautores; así me quedé con la palabra «persistent» en mi memoria, con lo que no fui capaz de entender la palabra «permanente» usada en la pregunta y en la pieza. Explicar el fenómeno de memoria gravitacional asociado a las cargas BMS en métricas asintóticamente planas no es fácil, ni en el podcast, ni aquí, porque yo no soy experto. Gastón Giribet es experto en cargas BMS asociadas al horizonte de agujeros negros y contestaría mucho mejor que yo a esta pregunta (le animo desde aquí a hacerlo). Recomiendo su reciente charla (junio de 2021) sobre cargas BMS en agujeros negros con horizonte magnetizado; la primera parte discute los agujeros negros convencionales, aunque no habla de la memoria gravitacional de forma explícita.

Muy brevemente, como explica Gastón en su vídeo, se pueden estudiar las simetrías en infinito de una métrica espaciotemporal asintóticamente plana (que describe el campo gravitacional en infinito, es decir, muy lejos, para una distribución arbitraria de energía y masa localizada en el origen de coordenadas). Las simetrías en el infinito son mayores que las de una métrica cualquiera y se describen por el llamado grupo BMS (Bondi–Metzner–Sachs, 1962); son similares a las simetrías que muestra en este vídeo Gastón para el entorno del horizonte de sucesos de un agujero negro. Las simetrías BMS representan las llamadas supertraslaciones, traslaciones desde el origen hasta infinito que dependen de una función arbitraria del ángulo, y las llamadas superrotaciones, rotaciones (y boosts relativistas) que también dependen de una función arbitraria de los ángulos. Por el teorema de Noether, estas nuevas simetrías tienen cargas asociadas, llamadas cargas BMS, que se encontrarían en el infinito (o en la zona exterior de un agujero negro, como propusieron Hawking–Perry–Strominger, 2018).

Las cargas BMS se usan en el contexto de la llamada holografía celeste; resumiendo mucho, el espaciotiempo tridimensional estaría determinado por las infinitas cargas BMS en la esfera celeste bidimensional. Así cualquier fenómeno gravitacional puede dejar una memoria en el espaciotiempo; por ejemplo, el paso de una onda gravitacional a través de los brazos de un interferómetro de ondas gravitacionales como LIGO dejaría una modificación persistente en las posiciones de reposo de los brazos que sería observable (si no se recalibra el interferómetro, la siguiente onda gravitacional quedaría marcada por dicha modificación). Los artículos de Nichols y sus colegas proponen una serie de observables para esta memoria gravitacional, tanto sus efectos de traslación en el espacio y el tiempo, como sus efectos de rotación en el espacio y boost en el espaciotiempo. Sus cálculos estiman que a la sensibilidad máxima teórica de LIGO serán observables dichos efectos.

Yo no soy experto, y no sé qué opinará Gastón al respecto, pero yo tengo serias dudas de que este fenómeno sea observable. Por supuesto, si no es observado, se volverán a realizar los cálculos y se descubrirá que el fenómeno está por debajo de la sensibilidad de LIGO. Así, se seguirá buscando durante décadas este efecto hasta que se intente observar con LISA y no se logre. Soy pesimista, lo siento. Me encantaría que el fenómeno fuera observado, sería un gran refuerzo a estas ideas y a todos los cuerdistas que investigan en ellas.

José Luis Blanc pregunta: «Las oscilaciones de neutrinos, algo de elementos orbitales (por qué la precesión de los equinoccios, qué demonios es un nodo ascendente y todo eso) y por qué Bernabé no va siempre. Le pago las galletas yo, lo prometo. Ah, y ¿qué es renormalización?».

Contesta Alberto Aparici @cienciabrujula: Alberto explica qué son las oscilaciones de neutrinos. Nos explica que todas las partículas son ondas (concentradas) en un campo cuántico (que aparentan estar localizadas en forma de partícula). Los neutrinos también son ondas. Hay tres tipos de neutrinos por su forma de interaccionar (el llamado sabor): electrónico, que interacciona bien con el electrón, muónico, con el muón y tauónico, con el leptón tau. Ahora bien, para estudiar la masa de los neutrinos estos estados de sabor no son los más adecuados, pues no tienen masa bien definida; para estudiar la masa se prefiere usar los llamados estados masivos, que se denominan uno, dos y tres, que son combinaciones lineales de los estados de sabor de los neutrinos. Así cuando un neutrino se produce o se detecta, siempre tendrá un sabor bien definido, pero mientras se propaga por el espacio con masa bien definida el neutrino será una combinación lineal de los tres sabores que se propagan con una velocidad de fase diferente. Como estos estados son ondas, se produce un desfase entre las ondas de los sabores y se observa una oscilación del sabor de los neutrinos durante su propagación. Alberto lo cuenta muy bien en el audio.

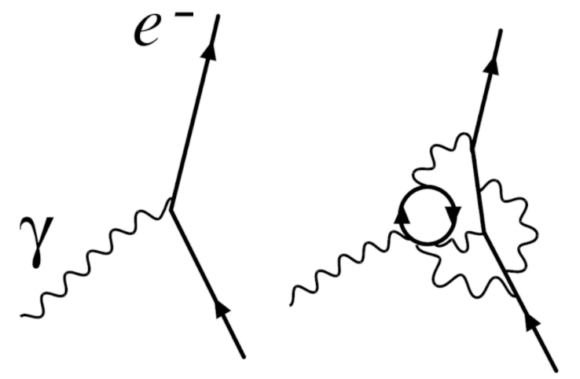

Luego Alberto explica qué es la renormalización. Nos cuenta que todo proceso físico depende de la energía involucrada. Pone el ejemplo de la interacción entre un electrón (carga negativa) y un positrón (carga positiva) que lleva a su aniquilación y producción de un par de fotones. Alberto nos cuenta que la probabilidad de este proceso depende la energía que tengan el electrón y el positrón. Hay muchas contribuciones en esta interacción; según Alberto la renormalización es una manera de tener en cuenta todos los posibles estados internos de la interacción, determinar cómo se combinan entre sí y cuáles son los más relevantes para calcular la probabilidad del proceso; a este proceso matemático se le llama renormalización. Así las constantes de interacción cambian con la energía, un resultado de la renormalización. Dice Alberto que todas las propiedades de las partículas cambian con la energía y dicho cambio se calcula gracias a la renormalización.

Dice Alberto que la renormalización no tiene nada que ver con los infinitos. Que está más relacionada con nuestra ignorancia sobre los estados internos que explican las interacciones; nos cuenta que esos estados internos no son observables [se refiere a las partículas virtuales] y que por tanto no son físicos [no se deben interpretar las partículas virtuales como partículas]. El proceso de renormalización es la técnica matemática que se usa para calcular las contribuciones [debidas a los fenómenos virtuales] de estos estados internos. Pero no hay que pensar que describen la física de lo que realmente ocurre, pues no podemos observar lo que realmente ocurre.

Alberto explica que la asociación de la renormalización con la eliminación de infinitos es debida que las interacciones son puntuales; algo ficticio, asociado a la formulación matemática, pues nada en el universo puede ser puntual. Cuando se hacen cálculos teniendo en cuenta los efectos puntuales aparecen infinitos [como cuando calculas la energía potencial de un electrón puntual con campo V(r) ~ 1/r]. Durante mucho tiempo estos infinitos impidieron usar la teoría cuántica de campos con éxito. Pero se descubrió la solución, la renormalización, que permite acotar la energía máxima de la interacción y con ella la distancia mínima en las interacciones. La renormalización permite esquivar las interacciones puntuales y con ellas los infinitos [así se calcula que la energía potencial de un electrón es finita por el apantallamiento del vacío a pesar de ser puntual]. La renormalización permite identificar el origen de los infinitos, como asociado a procesos con energía infinita, y gracias a ellos eliminarlos, introduciendo un corte de energía que se puede eliminar del resultado final en cierto tipo de teorías, las llamadas teorías renormalizables. El modelo estándar usa teorías renormalizables para poder obtener respuestas finitas a partir de cálculos (que Alberto llama tramposos) que involucran infinitos.

Te recomiendo oír el audio porque Alberto se explica mucho mejor que yo este tema.

Juan Barcelo pregunta: «Me gustaría conocer vuestra opinión sobre las posiciones de Lee Smolin, y también sobre la gravedad cuántica de lazos».

Contesta Francis Villatoro @emulenews: Lee Smolin ha trabajado en gravedad cuántica de lazos, en teoría de cuerdas y en fundamentos de la física cuántica. Sobre su trabajo científico no tengo nada que opinar. Quizás Juan pide nuestra opinión sobre las opiniones sociológicas en contra de la teoría de cuerdas que expresa en sus libros. Smolin critica que hace 20 años todos los físicos jóvenes querían investigar en teoría de cuerdas, sin acercarse a sus alternativas, como la gravedad cuántica de lazos; en su opinión este sesgo de la física teórica ha sido pernicioso pues podría ocurrir que el camino correcto hacia la futura gravitación cuántica no pasara por la teoría de cuerdas; como no lo sabemos, habría que trabajar en posibilidades alternativas. Obviamente se trata de un opinión (que comparten Peter Woit, Sabine Hossenfelder y otros físicos). Sin embargo, en mi opinión hay una serie de ventajas que ofrece la teoría de cuerdas para los físicos jóvenes que no ofrecen las alternativas. Y además hay ciertas obstrucciones o limitaciones de las alternativas que apuntan a que no son la respuesta adecuada (al menos en el estado actual de su formulación).

Sobre gravedad cuántica de lazos recomiendo los libros de Rodolfo Gambini y Jorge Pullin, uno dirigido a público general (sin fórmulas) «Gravedad cuántica de lazos para todos» (2021), y otro dirigido a estudiantes de física (con fórmulas), «Un primer curso en gravedad cuántica de lazos» (2012). Te recomiendo mi reseña ««Un primer curso en gravedad cuántica de lazos» por Gambini y Pullin», LCMF, 22 sep 2015. Tengo pendiente una reseña del nuevo libro (que leí antes de su publicación porque Pullin me envió el manuscrito); por desgracia tengo un abandonadas las reseñas… uno de mis propósitos para el año 2022 es recuperar las reseñas.

La gravedad cuántica de lazos (LQG) en su estado actual es una teoría incompleta. Sin experimentos que nos guíen, todas las ideas sobre gravedad cuántica están en una fase muy primitiva; no sabemos resolver sus ecuaciones y no tenemos observaciones con las que comparar lo poco que podemos calcular. Ninguna explica las singularidades en los agujeros negros y en el big bang. Ni la teoría de cuerdas ni la gravedad cuántica de lazos ni ninguna otra alternativa. Los lazos de la LQG son la interpretación física de las llamadas variables de Ashtekar, que permiten interpretar la gravedad de Einstein usando una conexión afín con álgebra su(2), que permite usar ciertas técnicas matemáticas que se usan en las teorías gauge tipo Yang–Mills. No se sabe describir el gravitón usando estas variables (se trata de una gravitación cuántica porque es una teoría cuántica que parte de las ecuaciones clásicas de Einstein).

Hay varias formulaciones de la gravedad cuántica de lazos, siendo la más popular las redes de espines. En esta versión el espaciotiempo se descompone en «cuantos de área» (número de líneas en la red de espines) y «cuantos de volumen» (número de intersecciones entre líneas); así se construye lo que podríamos llamar geometría cuántica del espaciotiempo. Sin entrar en muchos detalles, el problema es que no sabemos resolver las ecuaciones de la geometría cuántica, ni obtener su límite clásico para verificar que coincide con la gravitación de Einstein. Tampoco sabemos deducir qué solución ofrecen al problema de las singularidades. Podrían ser las ecuaciones correctas, o podrían estar completamente equivocadas, pero por ahora no lo sabemos. En aplicaciones, como la cosmología cuántica de lazos, se recurre a la inspiración lacista para inferir modelos que en rigor no se derivan de sus ecuaciones. Así que estas ideas desagradan a algunos físicos y llevan a otros a afirmar que no merece la pena aprender estas ideas en su estado actual. De ahí la preferencia de muchos jóvenes hacia la teoría de cuerdas, que en apariencia está mucho más madura, aunque tiene problemas muy similares.

Borch en Twitter pregunta: «Me gustaría saber cómo se preparan los podcasts semanalmente: quiénes participarán, cómo se deciden los temas a tratar…»

Contesta Héctor Socas Navarro @hsocasnavarro: Nos lo cuenta Héctor tan bien, que os recomiendo escucharle en el audio.

¡Qué disfrutes del podcast!

Hola, en la parte de las BAO podrías explicar la parte que dice «El segundo pico (y en general todos los picos pares) están dominados por la presencia de materia bariónica» no entiendo como es eso y el primer pico esta dominado por la velocidad del sonido en el plasma primordial que pasa con el resto de los picos impares y los valles? Aparte de lo que significa el nombre no entiendo nada y más me confunde el asunto de unirlo con el mapa de multipolos del CMB que poco entiendo también. Gracias y saludos

Dabed, resumiendo muchísimo, los picos acústicos están asociadas a las oscilaciones del plasma (materia) en los pozos de potencial gravitacional (inducidos por dicha materia); las oscilaciones se pueden interpretar como una «caída» en el pozo de potencial (con una comprensión del plasma) y como un «rebote» en el pozo de potencial (con una rarificación del plasma). Los picos acústicos impares (primero, tercero, quinto, …) están asociados con la «caída» y los picos pares (segundo, cuarto, sexto, …) con el «rebote». Obviamente, ambos dependen de la cantidad de materia bariónica, pero el aumento de los bariones realza los picos impares respecto a los pares; así, por ejemplo, a más densidad de bariones, más se suprime el segundo pico respecto al tercero.

Un análisis con más detalles, con figuras ilustrativas, en la famosa página web de Wayne Wu, Univ. Chicago (2001), http://background.uchicago.edu/~whu/intermediate/intermediate.html; si te quedas con dudas, te recomiendo su curso W. Hu, «Lecture Notes on CMB Theory: From Nucleosynthesis to Recombination», arXiv:0802.3688 [astro-ph] (25 Feb 2008). Si prefieres un libro de texto, te recomiendo el excelente libro de Ruth Durrer, «The Cosmic Microwave Background,» (2008) [la segunda edición es de 2020].

Creo que lo tome muy literal en vez de tomar la explicación mas simple pero obviamente me parece simple luego de leer tu explicación, el sitio web lo había visto pues google un poco antes de preguntar pero aún así estaba confundido, del paper leí hasta la sección 3.2 que termina como en la mitad de este obviamente entendí poco pero aún así creo algo me aclaro en que quede con cierto sentido de como se ven los cálculos pero creo necesitaré hacerme del libro que recomiendas para me guíe me explique más el porque de las cosas. Disculpa por insitir tanto con la pregunta y muchas gracias por tu ayda.