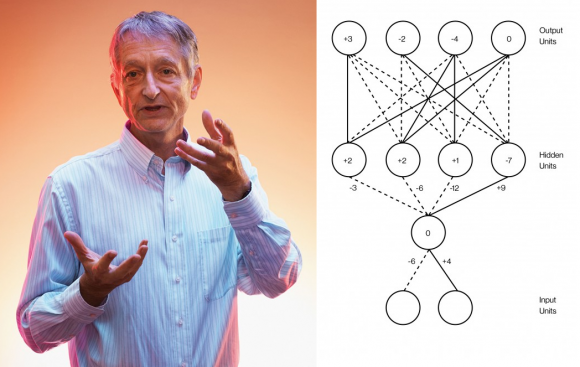

La Inteligencia Artificial está de moda gracias al aprendizaje profundo (deep learning), las redes de neuronas artificiales multicapa entrenadas con un algoritmo de retropropagación (backprop). Mucha gente cree ver una revolución emergente en esta tecnología; sin embargo, casi nada ha cambiado desde que el padre del aprendizaje profundo, Geoffrey Hinton, junto a dos colegas, introdujera el algoritmo de retropropagación en 1986. No solo lo digo yo en mis charlas, también lo dice él mismo, quien ahora es el científico más citado en aprendizaje profundo con gran diferencia respecto al siguiente.

La Inteligencia Artificial está de moda gracias al aprendizaje profundo (deep learning), las redes de neuronas artificiales multicapa entrenadas con un algoritmo de retropropagación (backprop). Mucha gente cree ver una revolución emergente en esta tecnología; sin embargo, casi nada ha cambiado desde que el padre del aprendizaje profundo, Geoffrey Hinton, junto a dos colegas, introdujera el algoritmo de retropropagación en 1986. No solo lo digo yo en mis charlas, también lo dice él mismo, quien ahora es el científico más citado en aprendizaje profundo con gran diferencia respecto al siguiente.

Por cierto, en mi charla sobre Ex Machina en Zaragoza me preguntaron por un libro sobre aprendizaje. Recomendé un clásico, cuando quizás tendría que haber recomendado un libro de fácil acceso, como Ian Goodfellow, Yoshua Bengio, Aaron Courville, «Deep Learning,» MIT Press (2016), que está disponible gratis en versión web http://www.deeplearningbook.org.

Por otro lado, te recomiendo leer la entrevista a Hinton (profesor emérito de la Univ. Toronto, ahora en el Vector Institute, Toronto, Canadá) que le realiza James Somers, «Is AI Riding a One-Trick Pony?» MIT Technology Review, 29 Sep 2017. El famoso artículo es David E. Rumelhart, Geoffrey E. Hinton, Ronald J. Williams, «Learning representations by back-propagating errors,» Nature 323: 533-536 (1986), doi: 10.1038/323533a0; también recomiendo Alex Krizhevsky, Ilya Sutskever, Geoffrey E. Hinton, «ImageNet Classification with Deep Convolutional Neural Networks,» Advances in Neural Information Processing Systems 25 (NIPS 2012), web, y Yann LeCun, Yoshua Bengio, Geoffrey Hinton, «Deep learning,» Nature 521: 436-444 (2015), doi: 10.1038/nature14539.

Te recomiendo ver el vídeo de la charla de Ramón López de Mántaras, «Inteligencia Artificial: progresos, desafíos y riesgos», Fundación Ramón Areces.

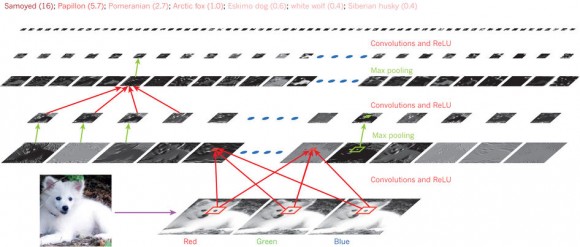

En 2012, Hinton y dos estudiantes demostraron que las redes de neuronas artificiales convolucionales podían reconocer imágenes con mayor precisión que cualquier otra técnica basada en inteligencia artificial. El secreto de estas redes era su número de neuronas por capa (la red tenía nueve capas): la primera capa tenía 150 528 neuronas (para recibir como entrada una imagen en color de 224 × 224 × 3 píxeles); tras aplicar 96 filtros de 11 × 11 × 3 se pasaba a la segunda capa con 253 440 neuronas; tras aplicar 256 filtros de 5 × 5 × 48 se pasaba a la tercera capa de 86 624 neuronas; tras 384 filtros de 3 × 3 × 256 se pasaba a la cuarta capa de 64 896 neuronas; tras aplicar 384 filtros de 3 × 3 × 192 se pasaba a la quinta capa de 64 896 neuronas; tras otros 256 filtros de 3 × 3 × 192 se pasaba a la sexta capa de 43 264 neuronas; finalmente, sin filtros, se encuentran tres capas de 4096, 4096, y 1000 neuronas. Esta última capa clasifica las imágenes de entrada en hasta 1000 clases diferentes.

Puede parecer que cambiar cientos o miles de neuronas por millones de neuronas es un cambio pequeño. Sin embargo, la potencia lograda con el cambio sorprendió a muchos, lo que llevó a Hinton a volver a publicar en Nature (no lo hacía desde 1986) y a que muchas empresas (Google, Apple, Facebook, etc.) se apuntasen al carro del aprendizaje profundo. Sin embargo, los grandes problemas de las redes de neuronas artificiales entrenadas con retropropagación no han sido resueltos aún. Entre ellos el problema del cuello de botella de la información (information bottleneck), descubierto en 1999.

El propio Hinton dice que «la mayoría de las conferencias sobre aprendizaje profundo solo presentan pequeñas variaciones de los algoritmos, sin plantearse problemas profundos sobre estos algoritmos». En la inteligencia artificial hay más ingeniería que ciencia básica. Los avances futuros requieren una comprensión básica de cómo funcionan los sistemas de aprendizaje profundo y qué relación tienen con el funcionamiento de la mente humana.

gracias Francis por acercarnos estos temas

saludos desde argentina

Interesantes ideas

Aún no hemos avanzado lo suficientemente para crear el algoritmo qué replique exactamente la mente humana