Usando 6 lentes gravitacionales H0LiCOW estimó un valor para la constante de Hubble de 73.3 ± 1.8 km/s/Mpc a 3.1 sigmas del valor cosmológico 67.4 ± 0.5 km/s/Mpc; la combinación H0LiCOW + SH0ES elevan la diferencia a 5.3 sigmas (LCMF, 20 jul 2019). El objetivo del proyecto TDCOSMO es estudiar los posibles errores sistemáticos en la medida de H0LiCOW debidos al perfil de densidad de masa de las galaxias elípticas. Repitiendo el análisis con 7 lentes gravitacionales obtiene 74.5 ± 5.8 km/s/Mpc; pero si se asume que estas lentes gravitacionales pertenecen a la misma población que las del catálogo SLACS (Sloan Lens ACS) de las que se tienen datos cinemáticos, se puede repetir el análisis obteniendo un valor de 67.4 ± 3.6 km/s/Mpc. Así el valor de TDCOSMO+SLACS libre de sistemáticos es coherente con el valor cosmológico (aunque su error sea 7 veces mayor).

Si eres asiduo lector de este blog sabrás que, en mi opinión, el problema de la constante de Hubble tiene su origen en errores sistemáticos en las medidas locales; yo confío mucho más en la medida cosmológica (lograda tras treinta años de estudio de la radiación cósmica de fondo) que en todas las demás medidas (obtenidas mediante análisis complicados usando métodos recientes que pueden ocultar gran número de fuentes de errores sistemáticos). Como comenta Ramiro Hum-Sah el estudio de posibles sistemáticos es «un buen ejemplo del beneficio indirecto que reciben la cosmología y la astrofísica observacionales con la polémica de la constante de Hubble; un mejor entendimiento de la dinámica galáctica y de nuestro entorno cercano. Parece que, después de todo, la física de muchos de los objectos involucrados en las medidas directas (Supernovas Ia, galaxias elípticas, etc.) no era tan trivial como creíamos». No habría sabido decirlo mejor.

Por supuesto, dirás que soy víctima del sesgo de confirmación cuando destaco este tipo de artículos en mi blog y tendrás razón, así es, lo siento. El nuevo artículo es S. Birrer, A. J. Shajib, …, L. Van de Vyvere, «TDCOSMO IV: Hierarchical time-delay cosmography —joint inference of the Hubble constant and galaxy density profiles,» A&A (submitted), arXiv:2007.02941 [astro-ph.CO] (06 Jul 2020); recomiendo también Daniel Gilman, Simon Birrer, Tommaso Treu, «TDCOSMO III: Dark matter substructure meets dark energy —the effects of (sub)halos on strong-lensing measurements of H0,» A&A (submitted), arXiv:2007.01308 [astro-ph.CO] (02 Jul 2020); M. Millon, F. Courbin, …, M. Rabus, «TDCOSMO II: 6 new time delays in lensed quasars from high-cadence monitoring at the MPIA 2.2m telescope,» A&A (submitted), arXiv:2006.10066 [astro-ph.CO] (17 Jun 2020); y M. Millon, A. Galan, …, L.Van de Vyvere, «TDCOSMO. I. An exploration of systematic uncertainties in the inference of H0 from time-delay cosmography,» Astronomy & Astrophysics (2020), doi: https://doi.org/10.1051/0004-6361/201937351, arXiv:1912.08027 [astro-ph.CO] (17 Dec 2019).

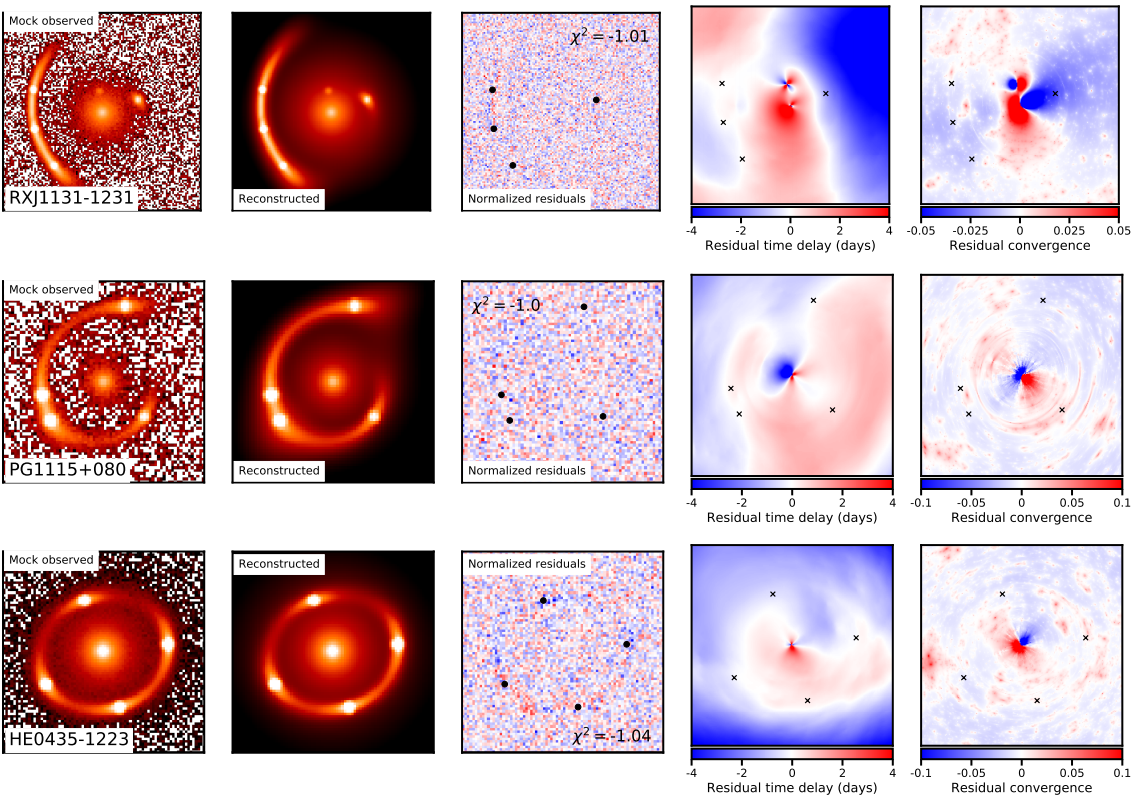

El astrofísico noruego Sjur Refsdal propuso en 1964 que se podía estimar el parámetro de Hubble y la masa de una galaxia usando el retraso temporal entre sus múltiples imágenes en una lente gravitacional; todo un pionero, pues la primera observación de múltiples imágenes se obtuvo en 1976. Hasta el último lustro no se ha podido realizar la estimación del parámetro de Hubble con este método (COSMOGRAIL, H0LiCOW, SHARP y STRIDES). Su gran problema es que el análisis de cada lente gravitacional requiere usar un modelo del perfil de densidad de masa de la galaxia elíptica que actúa como lente; dicho perfil es desconocido (solo observamos la materia visible y el perfil también depende de la materia oscura); por ello, se debe inferir a partir de la imagen lensada. Esta figura muestra seis simulaciones por ordenador de una lente gravitacional descrita por sendos perfiles de densidad de masa. Este problema inverso está mal condicionado (pasa lo mismo que con la reconstrucción tridimensional de un órgano a partir de una radiografía en dos dimensione); así el resultado depende del perfil inicial usado para arrancar el análisis, lo que introduce un error sistemático en la estimación de la constante de Hubble.

La idea del proyecto TDCOSMO, en el que participan investigadores de COSMOGRAIL, H0LiCOW, SHARP y STRIDES, es estudiar un gran número de lentes gravitacionales (muchas más de las que permiten la aplicación del método de Refsdal) para decidir cuál es el perfil inicial más adecuado para la densidad de masa de la galaxia elíptica que actúa como lente; bajo lo hipótesis de que las lentes gravitacionales usadas en el método de Refsdal están descritas por el mismo perfil inicial, se puede obtener una estimación de la constante de Hubble libre de este error sistemático. Para ello se han usado las 33 lentes gravitacionales del catálogo SLACS en 9 de las cuales se ha podido resolver el perfil de anisotropía estelar. Asumiendo que las 7 lentes gravitacionales estudiadas por TDCOSMO (entre las que se incluyen las 6 de H0LiCOW) pertenecen a la misma familia que las 9 lentes de las que se ha resuelto el perfil cinemático de entre 33 lentes gravitacionales del catálogo SLACS (que contiene casi 100), se obtiene un valor de H0 = 67.4+4.1−3.2 km/s/Mpc, en buen acuerdo con la estimación H0 = 67.4 ± 0.5 km/s/Mpc del telescopio espacial Planck (ESA) a partir del fondo cósmico de microondas.

Por supuesto, podría ocurrir que el estudio de TDCOSMO esté sesgado, pues las 9 lentes del catálogo SLACS de las que se tienen datos de suficiente calidad para realizar una buena reconstrucción de su perfil de densidad de masa podrían pertenecer a una población muy diferente de las 7 lentes usadas en la estimación de la constante de Hubble. Sin embargo, incluso en dicho caso, el nuevo trabajo nos recuerda que no debemos tener demasiada confianza en el análisis estándar de dichas 7 lentes (que estiman H0 = 74.5 +5.6−6.1 km/s/Mpc); dichos análisis ocultan un sistemático relevante asociado al perfil de densidad de la masa de la lente.

Este año la pandemia de la COVID-19 nos está demostrando en primer plano que la ciencia en directo no es fácil; el conocimiento se construye sobre un pajar de incertidumbre en el que cuesta mucho encontrar las agujas escondidas; pero mientras tanto se aprende mucho de muchísimas cosas. Lo mismo pasa con la polémica asociada a la constante de Hubble; tenemos muchos métodos disponibles y todos ofrecen respuestas diferentes, algunas compatibles entre sí y otras claramente discrepantes. La solución al problema acabará siendo encontrada, pero costará cierto tiempo. Mientras tanto aprenderemos muchísimas cosas sobre la astrofísica de los objetos que usamos como candelas para estimar el ritmo actual de expansión del cosmos.

En este asunto se comprueba cómo la ciencia va aproximándose gradualmente a la verdad. Hace casi un siglo, el propio Hubble atribuyó a su parámetro homónimo un valor numérico tan enorme que implicaba algo imposible, a saber: que nuestro universo era mucho más joven que la Tierra. Desde entonces los científicos han mejorado sus cálculos, pues ahora polemizan por valores bastante cercanos: entre unos 67 y unos 74. Yo tengo el mismo sesgo que Francis: pienso el valor correcto caerá en los 67 y pico.

Probablemente solo fruto de mi ignorancia:

¿Podrán dos lentes gravitacionales próximas estar creando una lente gravitacional divergente?

¿Si pudiera existir una lente gravitacional divergente, podría está dar lugar a un «agujero blanco» o zona excluida al tránsito de cualquier tipo de radiacion?

Pocosé:

No es posible, la razón es el teorema de «enfoque» en relatividad general https://en.wikipedia.org/wiki/Raychaudhuri_equation#Focusing_theorem. Todo objeto físico que satisfaga la condición fuerte de positividad de la energía (ver página 100 en https://arxiv.org/abs/gr-qc/9707012) actuará como una «lente gravitacional convergente»; más precisamente, al dispersar un haz de rayos de luz con sección transversal circular «A» por un objeto que satisfaga la condición de la positividad de la energía nunca podrás observar una evolución A->A*, con A*>A, donde A* es la sección transversal del haz de rayos de luz tras la dispersión.

Violar el requirimiento de la positividad de la energía no es físicamente plausible. De hecho este teorema es el alma de muchos resultados célebres de la relatividad general.

Por ejemplo: En la página 51 de https://arxiv.org/abs/gr-qc/9707012 podéis encontrar una aplicación del mencionado teorema para probar la unicidad de la solución de agujero negro estacionario y los teoremas de singularidad de Penrose. También podéis leer su aplicación a la termodinámica de agujeros negros en 109.

Para aprender más recomiendo el capítulo 7 del documento que adjunté, en particular después de la página 106.

Saludos.

Gracias

Creo que no entendieron bien el paper. Eso no invalida el valor de H0 de H0LiCOW. Solo introduce un nuevo contexto y nueva metodologia pero esa necesitara mas datos para ser utile. Ahora si galaxias son power laws or NFW el valor correcto de H0 medida con lentes. So no lo son, entonces necesitamos la analysis des este nuevo articulo pero con mucho mas datos como SLACS.

Me inclino también a pensar algo similar, que la constante de Hubble será más o menos la que se obtiene con el fondo cósmico de microondas.

Por cierto, si alguien tiene curiosidad aquel artículo que sugería que los datos de Planck apuntaban a un Universo cerrado ha recibido respuesta. Sigue siendo plano: https://arxiv.org/abs/2002.06892

😉 Aquel dudoso artículo…

https://francis.naukas.com/2019/11/05/dudosos-indicios-apuntan-a-que-el-universo-es-cerrado/

U-95:

Gracias por el artículo, lo he leído y me ha gustado mucho. Es tan claro su tesis (y corto) que bien podría funcionar como un texto divulgativo sobre el análisis, hipótesis de trabajo y contraste básico que realizan distintos experimentos actuales sobre el parámetro de densidad de curvatura.

Por cierto, el artículo hace precisamente lo que Francis había predicho que las réplicas harían en el artículo que adjunta Pelau, y esto me ha resultado muy instructivo. Un análisis detallado, dividido por «capas» incorporando los datos de BAO, Pantheon y medidas de amplitud de lensado a los datos cosmológicos de Planck, usando a Ω(k) como parámetro libre extra en el modelo ΛCDM. Todas esas fuentes son razonablemente independientes, y como ha apuntado el artículo y Francis en otras ocasiones: debería haber nueva física en todas las fuentes independientes o errores sistemáticos simultáneos y en las mismas ventanas de toma de datos para todos los experimentos independientes que indicaran falso positivo para Ω(k)=0. Muy improbable.

Las novedades parecen ser que las conclusiones del artículo (favoreciendo Ω(k)=0) son debatiblemente independientes de las discrepancias en los parámetros de ΛCDM para multipolos altos, y que, las combinaciones de datos apuntan cierta insensibilidad ante el uso de las distribuciones Plink o CamSpec.

Respecto a esto último. Un análisis mucho más detallado de los mapas a altas frecuencias de Planck se puede consultar en https://arxiv.org/abs/1910.00483 . También se puede leer en este documento que sólo usando la verosimilitud CamSpec combinada TTTEEE en las simulaciones MonteCarlo de la colaboración Planck para determinar los parámetros cosmológicos a multipolos bajos (2<l<800) son muy parecidos a los obtenidos en las mismas circunstancias para multipolos altos (2<l<2500). Así que tal vez lo novedoso del artículo es la sistemática del análisis y el orden coherente de sus argumentos.

Por supuesto, tal vez los lectores de Francis también caímos en una actitud de sesgo de confirmación 😉

Un saludo U-95.

Extraordinario análisis del artículo. Deslumbrante objetividad.

Es un grandísimo honor ser citado por un comentario cualquiera por el mejor divulgador del mundo. Muchas gracias Francis, significa más de lo que puedo expresar con palabras.