He participado en el episodio 445 del podcast Coffee Break: Señal y Ruido [Acast A, Acast B; iVoox A, iVoox B; iTunes A y iTunes B], titulado “Ep445: Especial Señales de los Oyentes», 04 ene 2024. «La tertulia semanal en la que repasamos las últimas noticias de la actualidad científica. En el episodio de hoy: Cara A: Varias preguntas de oyentes. Cara B: Muchas más preguntas de oyentes. Imagen de portada realizada por Héctor Socas. Todos los comentarios vertidos durante la tertulia representan únicamente la opinión de quien los hace… y a veces ni eso».

¿Quieres patrocinar nuestro podcast como mecenas? «Coffee Break: Señal y Ruido es la tertulia semanal en la que nos leemos los papers para que usted no tenga que hacerlo. Sírvete un café y acompáñanos en nuestra tertulia». Si quieres ser mecenas de nuestro podcast, puedes invitarnos a un café al mes, un desayuno con café y tostada al mes, o a un almuerzo completo, con su primer plato, segundo plato, café y postre… todo sano, eso sí. Si quieres ser mecenas de nuestro podcast visita nuestro Patreon (https://www.patreon.com/user?u=93496937); ya sois 129, muchas gracias a todas las personas que nos apoyan. Recuerda, el mecenazgo nos permitirá hacer locuras cientófilas. Si disfrutas de nuestro podcast y te apetece contribuir… ¡Muchísimas gracias!

Descargar el episodio 445 cara A en Acast.

Descargar el episodio 445 cara B en Acast.

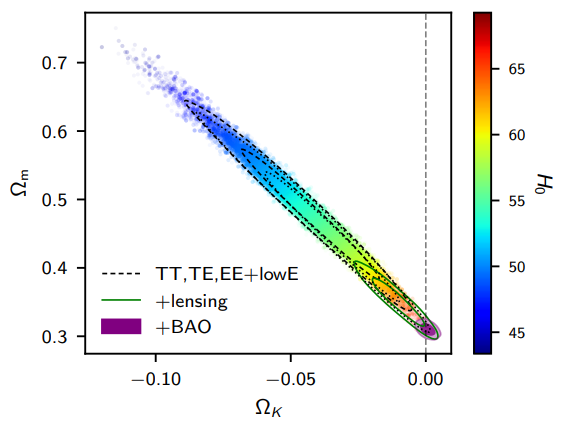

Álvaro (Collado Villalba, Madrid) pregunta: «¿Cómo es posible que no se sepa si el Universo es infinito o finito? ¿Cuál es el problema que impide que sepamos de manera definitiva esto? Y si fuera finito… ¿qué hay más allá?» Contesta Alberto Aparici que solo podemos estudiar el universo observable, que parece ser plano (su curvatura espacial es compatible con cero), que podría ser un pequeño trozo del Universo. Así el Universo podría ser finito, con curvatura (positiva o negativa), pero parecer localmente plano en el universo observable. Por ello, no sabemos si el universo es finito o infinito, porque solo vemos un pequeño trozo. Si hubiéramos visto repeticiones en el fondo cósmico de microondas sabríamos que el Universo es más pequeño que el universo observable y, por tanto, es finito; pero no hemos observado estas repeticiones, así que asumimos que no existen. ¿Qué hay más allá de un Universo finito? Pues no hay nada; esta pregunta no tiene sentido, por definición, de Universo. Alberto pone el ejemplo del polo norte de la Tierra; cuando «subes» hacia el polo norte, te puedes preguntar qué hay más allá, entre tú y el polo norte; pero una vez llegas al polo norte no tiene sentido la pregunta qué hay más allá del polo norte. Lo mismo pasa con un Universo finito.

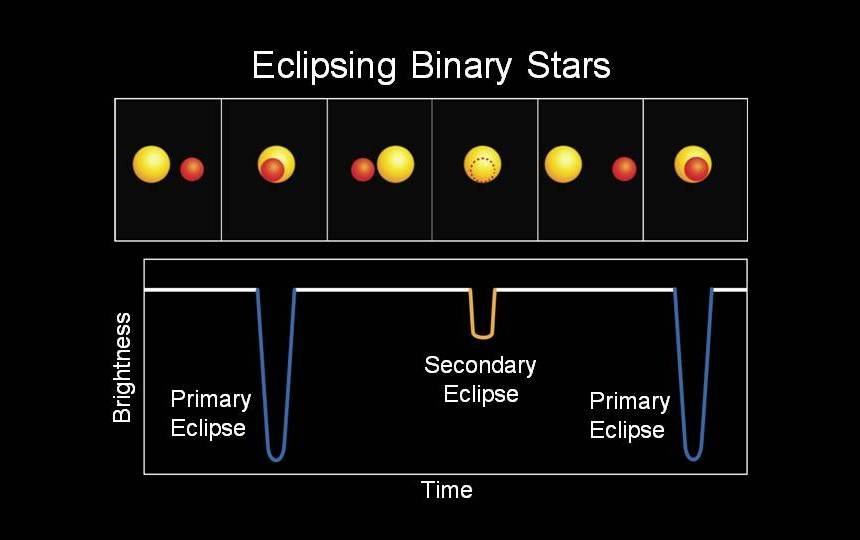

Israel (Sevilla) pregunta: «¿Cómo se sabe el tamaño de una estrella? Si el espacio es plano, ¿cómo se casa que el Universo sea infinito o que tenga un tamaño?» Contesta Héctor Vives que usando ocultaciones lunares se puede medir el diámetro de estrellas cercanas (sobre todo de estrellas gigantes); pero esta medición tiene mucha incertidumbre. Hay sistemas estelares binarios en los que observamos el tránsito entre estas estrellas; si se estima la velocidad por efecto Doppler, se puede medir el diámetro conociendo el tiempo del tránsito (método que se calibra cuando una de las estrellas es de tipo solar, pues para el Sol es fácil medir su tamaño). Otros métodos son el uso de la interferometría óptica, uso de óptica adaptativa o, incluso, interferometría en radio de muy larga base. De hecho, con radiotelescopios como ALMA se puede observar el disco de estrellas como Betelgeuse, que permite determinar su diámetro. Hay otros métodos indirectos, como la astrosismología, que permiten estimar la gravedad superficial de una estrella, que depende de su diámetro. En cuanto al tamaño del universo observable, Héctor Vives complementa la respuesta de Alberto.

Marisa (Coruña) recopila cinco preguntas de sus estudiantes de la ESO: «Aroa pregunta qué pasaría si Andrómeda (M31) se acerca a la Vía Láctea, ¿podrían fusionarse?» Contesta Héctor Socas que este proceso ocurre a escalas cosmológicas; a día de hoy Andrómeda está a unos 2.5 millones de años luz de la Vía Láctea, es decir, unas 20 veces el diámetro de nuestra galaxia. Se espera que los halos de materia oscura de ambas galaxias ya estén en contacto. Dentro de unos 3500 millones de años se iniciará la fusión de ambas galaxias, que finalizará dentro de unos 5000 millones de años. Para entonces la Tierra ya no será habitable, casi seguro que no existirá. Tras la fusión se formará una galaxia elíptica.

«Adriana pregunta cómo se formaron los primeros agujeros negros y qué papel jugaron en la historia del universo». Contesta Héctor Socas que no lo sabemos bien. Los agujeros negros primordiales (aún no observados) se pudieron formar en el plasma primordial, mucho antes de la formación de las primera estrellas. Por otro lado, algunas de las primeras estrellas eran muy masivas y explotaron en pocos millones de años dejando agujeros negros de masa estelar. Tampoco se sabe qué papel jugaron en la historia del universo; si los agujeros negros primordiales son responsables de la materia oscura su papel fue fundamental; pero en otro caso, su papel fue irrelevante a gran escala.

«Alex pregunta por qué la radiación del fondo cósmico de microondas nos llega en todas direcciones si llegan del big bang que ocurrió en un punto concreto». Contesta Héctor Socas que el big bang ocurrió en todas partes (a pesar de que cueste imaginarlo). El bang del universo partió cuando el universo tenía una tamaño de metros (como una habitación), que ya estaba en expansión; antes había ocurrido la inflación cósmica cuyos detalles no conocemos. Cuando surge el fondo cósmico de microondas el universo observable tenía un diámetro de unos 84 millones de años luz (93 mil millones dividido entre z = 1100); en aquel momento los fotones estaban por todas partes y esos fotones ahora (cuando el universo es 1100 veces más grande) siguen estando por todas partes; por ello nos llegan desde todas las direcciones.

«Roman pregunta si puede obtenerse un plasma de quark-gluón y si puede tener alguna utilidad cotidiana». Contesta Héctor Socas que en la Naturaleza no existen quarks y gluones por separado, solo se observa su combinación en forma de hadrones (protones, neutrones, piones, etc.). En el plasma quark-gluón estas partículas están a muy alta temperatura y no están confinadas, están en forma libre. Ese estado de plasma existía en el universo primigenio. El plasma quark-gluón también podría existir en el interior de las estrellas de neutrones, pero no se sabe con seguridad. No tienen ninguna aplicación práctica; por ahora solo es ciencia básica para entender mejor la interacción fuerte. Nadie sabe si en el futuro pudieran tener alguna aplicación; pero a día de hoy ninguna es concebible.

«Leda pregunta si la temperatura es la agitación de las partículas, ¿cuál es la temperatura del vacío?» Contesta Héctor Socas que en rigor, el vacío no tiene temperatura. Pero destaca que el vacío cuántico presenta fluctuaciones cuánticas de punto cero, aunque no permiten asociarle una temperatura (en rigor T = 0). Se suele hablar de temperatura T del espaciotiempo vacío aludiendo a la constante cosmológica Λ (energía oscura); en dicho caso se puede usar la fórmula T² = Λ/3 para asignar una temperatura al espaciotiempo vacío.

Alfredo pregunta: «Si un agujero negro pasa delante de otro frente a un observador externo, vería este observador una especie de lente gravitacional que curvara la atracción gravitacional del primero». Contesta Isabel Cordero que depende de los detalles de la configuración, pero la atracción gravitacional no será observable. Se necesita que ambos tengan un disco de acreción de materia, o que se encuentran sobre un fondo denso de materia (como un núcleo galáctico), para que se pueda ver el efecto. Pero habrá un efecto de lente gravitacional estándar, que dará lugar a muchas copias de la imagen del agujero negro de fondo, como bien sugiere Alfredo.

También contesta Gastón Giribet que no se puede interpretar que la atracción gravitacional como algún tipo de radiación; no hay que confundir la radiación gravitacional (las ondas gravitacionales) con la atracción gravitacional que es la curvatura del espaciotiempo. La gravitación es la curvatura del espacio; como tal no es radiación gravitacional. Se requiere que hay «movimiento» de los cuerpos que generan el campo gravitacional para que se produzca radiación gravitacional.

Ángel Martín pregunta: «Me gustaría que nos detallárais la fase de «flash de helio» que estrellas como el Sol llegarán a experimentar. E incluso si lo queréis adornar con los previos a dicha fase y las consecuencias para la estrella y su entorno, pues estaré mucho más contento todavía». Contesta Héctor Vives que el Sol fusiona hidrógeno para dar lugar a helio, que se acumula de forma inerte en el centro del Sol; el hidrógeno se sigue fusionando a su alrededor cada vez deprisa, por ello el Sol brilla ahora más que en el pasado. Pero la presión en el núcleo de helio aumenta con lo que podría llegar a colapsar, pero lo evita el principio exclusión de Pauli; el núcleo de helio se convierte en materia degenerada, que no se expande al aumentar la temperatura; el aumento de temperatura en el núcleo de helio logra aumentar el ritmo de fusión del hidrógeno a su alrededor, un proceso que hace que el Sol se expanda hasta transformarse en una estrella gigante roja.

El «flash de helio» ocurre cuando la estrella es una gigante roja que alcanza su máximo de brillo. La razón es que el núcleo de helio se calienta sin expandirse, hasta que alcanza una temperatura suficiente para la fusión del helio por el proceso triple alfa (tres núcleos de helio dan lugar a un núcleo de carbono). Este proceso es muy dependiente de la temperatura; una vez empieza la fusión de helio, aumenta la temperatura, aumenta el ritmo de fusión, aumenta la temperatura y este proceso realimentado consume de forma muy rápida el núcleo del helio. En unos minutos el 6 % del núcleo de helio se consume, cuando todo el núcleo ronda el 20 % de la masa del Sol. Este proceso es como una «explosión» del núcleo de helio, que permite que a partir de este momento el helio se comporte como un gas normal que se expande con la temperatura. Toda la energía liberada se consume en la expansión del núcleo durante este «flash de helio» por lo que desde fuera de la estrella no se observa ningún cambio de brillo. Pero para la gigante roja es como si le hubieran dado el golpe de muerte.

La expansión del núcleo de helio implica una bajada de temperatura; lo que reduce la temperatura del hidrógeno, que reduce su ritmo de fusión, y la gigante roja se hace más pequeña. Y a partir de ese momento el helio se fusiona a un timo normal. Y la gigante roja pasa a ser una subgigante roja (con color rojo-amarillo). A partir de ese momento en el núcleo se acumulará el carbono; rodeado de helio fusionando en carbono; y con hidrógeno fusionando en helio a su alrededor. Así el «flash de helio» no es nada espectacular desde fuera de la estrella, pero es una fase de la evolución de las estrellas gigantes rojas. El proceso se repite con cierta ciclicidad, y así las capas superiores de la estrella se van expulsando dando lugar a una nebulosa planetaria, que acabará con una enana blanca en su centro.

Fénix Romero pregunta: «¿Es lo mismo bosón que partícula bosónica? ¿Se aplica igual el teorema espín-estadística a partículas elementales que a compuestas? En caso afirmativo, motivo real de mi dolor de cabeza, si los mesones tienen espín entero deberían poder «existir» infinitos en un mismo lugar, pero al estar formados por fermiones esto implicaría infinitos fermiones con los mismos números cuánticos en el mismo sitio». Contesta Gastón Giribet que no es solo una cuestión terminológica. No hay una distinción esencial entre un bosón y una partícula bosónica; se pueden usar de forma indistinta. Si se quiere forzar una diferencia, una cuasipartícula puede ser un bosón, pero no sería una partícula bosónica (aunque sería una cuasipartícula bosónica). No se puede decir que una partícula bosónica sea siempre una partícula fundamental (como el bosón de Higgs), pues puede ser un mesón (que tiene estructura interna).

También contesta Alberto Aparici a la segunda parte de la pregunta sobre si un sistema compuesto puede comportarse como un bosón capaz de condensarse en un condensado de Bose–Einstein BEC (que parece contradictorio porque estos bosones se acumulan en la misma región del espacio, pero al estar formados por fermiones no podrían hacerlo). Un átomo puede ser un bosón (si la suma de los espines de sus electrones de la última capa es un número entero); de hecho, en laboratorio, los BEC a baja temperatura están formados por átomos (bosónicos). Alberto recurre a la diferencia entre bosones y fermiones con el cambio de signo de la función de onda ante un cambio de orden; para un bosón Ψ(A,B) = Ψ(B,A), pero para un fermión Ψ(A,B) = −Ψ(B,A). En el BEC todos los átomos bosónicos son indistinguibles y están regidos por una única función de onda para todo el BEC; en dicho estado todos los átomos están en un estado de superposición común y puedo intercambiar dos átomos Ψ(A,B) = Ψ(B,A) sin cambiarlo. Pero no puedo intercambiar dos electrones de átomos diferentes, porque no son indistinguibles al estar en átomos diferentes en el BEC, y porque las distancias entre los átomos (y por tanto entre dichos electrones) son enormes en el BEC.

Hay un punto que ni Gastón ni Alberto han comentado. ¿Ocupan todos los átomos del BEC y sus electrones la misma región del espacio? La respuesta es que sí, pero no. La función de onda de BEC ocupa una única región del espacio, pero su tamaño es enorme (entre decenas de micrómetros y milímetros) comparado con el tamaño de los átomos individuales (décimas de nanométro). Pero a escala atómica, no es cierto que todos los átomos ocupen la misma región del espacio. Y a los electrones ligados a dichos átomos les pasa lo mismo, ocupan un tamaño de ángstroms, cuando el BEC puede ser millones de veces más grande. Por ello, los electrones siguen comportándose como fermiones alrededor de sus átomos, aunque los átomos se comporten como bosones en el enorme BEC. En relación a esta pregunta, el tamaño importa.

Antonio pregunta «¿Cómo almacenan los fotones la información del cuerpo del que salieron? En un distante planeta a un millón de años luz había una jirafa; cuando nos llegue la imagen de la ya inexistente jirafa a nuestro supertelescopio, ¿veríamos todos los detalles de la misma?» Contesta Héctor Vives que sería necesario un telescopio más grande que la órbita entera de Saturno para poder captar un solo fotón de dicha jirafa. Cada fotón tiene información del color (longitud de onda, o frecuencia, o energía), tiene una polarización y tiene una dirección de la que proviene. Para ver la forma de un objeto necesitamos muchos fotones que provienen de puntos diferentes del objeto, es decir, de direcciones diferentes, que se acumulen para formar una imagen. De objetos muy distantes vemos una imagen cuando son muy grandes para que observemos muchos fotones de diferentes direcciones. Con el supertelescopio sería imposible ver la jirafa, salvo que pudiéramos acumular, como mínimo, decenas de miles de fotones de diferentes partes de la jirafa.

Carlos (Navarra) pregunta: «Un electrón es una excitación de un campo cuántico; al entrar en un agujero negro, Francis explicó que el electrón se desexcita al estado de vacío y su energía se transforma en curvatura. Estas excitaciones están cuantizadas, se pueden crear una, dos, o tres, pero no podemos crear 1.2 o 2.3 excitaciones. Por otro lado, en agujeros negros, las partículas que entran se «espaguetizan» y su energía se transforma en energía de curvatura del agujero negro. ¿Perderá el electrón energía poco a poco, incumpliendo la cuantización, siendo medio electrón, un cuarto electrón, etc.?» Contesta Alberto Aparici que la excitación tipo electrón siempre estará cuantizada; el electrón puede perder energía cinética, sin perder masa, de forma continua. Alberto dice que no tenemos una teoría de gravitación cuántica que explique el proceso de desexcitación del electrón y transformación de su energía en curvatura. En sus propias palabras, «algo desconocido ocurre» y la partícula se transforma en gravedad.

Me gustaría apostillar que como bien dice Alberto el electrón siempre está cuantizado dentro del agujero negro. Para mucha gente no hay problema en la absorción de un fotón; sin embargo, parece problemático la absorción de un electrón. Pero desde un punto de vista conceptual es exactamente lo mismo; el agujero negro absorbe la excitación del campo electrónico que llamamos electrón, como se absorbe la excitación del campo electromagnético que llamamos fotón. No hay ninguna diferencia conceptual. El electrón puede perder energía cinética (como dice Alberto) sin perder su identidad, pero también puede desexcitarse por completo, pasando el campo electrónico a un estado de vacío y transfiriendo toda su energía al agujero negro (que incrementa su parámetro de masa, es decir, su energía de curvatura).

Thomas pregunta sobre «la diferencia entre la Cosmología Cíclica Conforme (CCC) de Penrose y el modelo de decaimiento del vacío de Coleman–de Luccia (CdL), asumiendo que podría dar lugar a una cosmología cíclica. ¿El colapso de tipo Coleman–de Luccia es equivalente a lo que ocurre en la Cosmología Cíclica Conforme de Penrose?». Contesta Héctor Socas cuenta que ambas cosmologías son muy diferentes entre sí. Nos recomienda el Ep. 173 de Coffee Break, un especial sobre Cosmología. En la CCC de Penrose se conecta la inflación cósmica primordial y la expansión acelerada del universo debido a la energía oscura; ambos son conectados por una transformación conforme (un reescalado); la clave es que la materia en la muerte térmica acaba en el interior de agujeros negros supermasivos que se evaporan; una vez que ya solo se tiene espaciotiempo y radiación, se acaba en un universo sin escalas, que se puede conectar mediante un reescalado con el siguiente eón. A Héctor le idea le parece plausible, pero muy especulativa. Héctor relaciona la idea de CdL con la inflación eterna (en lugar de con un universo cíclico como sugiere Thomas); el potencial inflatón tendría dos mínimos, un vacío metaestable y un vacío de menor energía, entre los que se produce un salto por efecto túnel. Nuestro sería un estado metaestable que en el futuro decaerá en un nuevo vacío mediante la nucleación de burbujas que se expanden a la velocidad de luz. Dentro de estas burbujas

Jorge (Mar del Plata, Argentina) pregunta: «Mi consulta es respecto a la nube primordial que dio originen al Sistema Solar. ¿Cómo es que hubo semejante cantidad de elementos pesados, si, se dice, que la nube era principalmente de hidrógeno y helio?» Contesta Héctor Vives que la cantidad de elementos pesados en la nube primordial era una fracción ínfima. La mayor parte de esta nube primordial era de hidrógeno y helio, pero tenía trazas de elementos pesados (generados en explosiones de supernovas o en fusiones de estrellas de neutrones). En el centro de la nube, donde se formó el Sol, se acumularon los elementos más ligeros, hidrógeno y helio, pero en los planetesimales alejados del centro se acumularon los elementos pesados junto a los ligeros; pero estos elementos ligeros sufrieron el efecto del viento solar que los expulsó. Así, los planetas gigantes como Júpiter y Saturno están dominados por hidrógeno y helio, pero en los planetas rocosos los elementos ligeros fueron expulsados por el viento solar.

Pedro pregunta: «No termino de entender la convivencia entre la gravedad como una curvatura del espacio-tiempo producida por la materia-energía y la supuesta necesidad de un bosón, el gravitón, ya que me parecen hipótesis divergentes. ¿Alguna luz sobre qué medios se usan para teorizar las características de este bosón?» Contesta Gastón Giribet que no es una cuestión de conveniencia, más allá de lo estético y formal. La idea de Einstein es la correcta, la gravitación no es una fuerza, es la curvatura del espaciotiempo, y las ideas previas, relacionadas con fuerzas newtonianas, son equivocadas. Otro tema es si esta idea es aplicable a otras fuerzas fundamentales, que también podrían tener un origen geométrico (lo que sugiere la teoría de cuerdas); no lo sabemos. Pero respecto a la gravitación no es una cuestión de conveniencia, según Gastón, es que es así y punto.

Apostillo que Gastón ha olvidado el papel del gravitón. No sabemos si el gravitón existe. Además, una teoría cuántica de la gravitación basada en gravitones no es renormalizable, luego no se puede usar para determinar la física cuántica de las regiones singulares en al teoría de Einstein. Sin embargo, se puede determinar el límite clásico de dicha teoría y resulta estar descrito por las ecuaciones de Einstein para la curvatura del espaciotiempo clásico. Así, aunque le parezca paradójico a Pedro, a partir del gravitón se puede derivar la gravitación de Einstein (de hecho, en teoría de cuerdas se predice el gravitón y por ello se dice que también se predice la gravitación). Recomiendo a los interesados en los detalles el libro de Richard Feynman, «Feynman lectures on gravitation,» para los detalles de la derivación.

Manolo Jiménez, pregunta: «¿Me gustaría saber cómo organizáis vuestro tiempo laboral los científicos en nuestro país?» Contesta Isabel Cordero que depende del centro de trabajo (organismo público de investigación, universidad, etc.), del puesto académico (doctorando, postdoctorando, profesor, investigador, etc.) y de la fuente de financiación (los proyectos de investigación exigen cierto número de horas de dedicación semanales). La presión por publicar depende mucho de la edad y del puesto académico; por ejemplo, para el personal senior hay mucha carga de trabajo en gestión (burocracia) y en el caso de profesores también de docencia. Cuadrar todos los horarios es siempre muy difícil (clases, gestión de las clases, cargos de gestión, gestión de la investigación, reuniones, conferencias científicas y, por supuesto, investigación); el personal seniorrequiere del personal joven (dedicado a tiempo completo a la investigación) para garantizar una buena producción investigadora. La investigación es una labor pasional, y así muchos investigadores trabajan incluso durante su tiempo libre, fines de semana, vacaciones, etc.

Contesta Héctor Socas que los investigadores postdoctorales son claves en la investigación en la actualidad. Muchos proyectos de investigación soportan su investigación gracias a los postdocs, sobre todo en centros de investigación. Héctor es investigador con plaza fija (funcionario) en un Organismo Público de Investigación (OPI), mientras Isabel y yo somos profesores de sendas universidades; así que su labor se limita a la investigación sin docencia reglada (como nos ocurre a Isabel y a mí). En cualquier caso, como investigador tiene que soportar una gran carga burocrática. Héctor destaca la libertad de cátedra en la investigación, que garantiza que él puede investigar en lo que quiera, en cosas que le diviertan o le apasionen (tecnomarcadores o lo que sea, de forma independiente a su línea principal de investigación en física solar). Lo que motiva a los investigadores es lograr prestigio, lo que requiere ser un líder mundial en un tema (por ello son temas muy concretos y muy particulares). Por otro lado, destaca que la divulgación no se valora en el currículum de los investigadores.

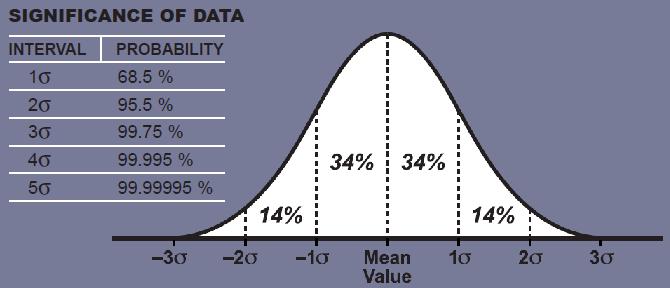

Silvina Settecase pregunta: «Todo lo que usted siempre quiso saber sobre las sigmas». Contesta Héctor Socas (y yo apostillo al final por ser parte y causa de la pregunta) explicando lo que es un contraste de hipótesis en inferencia estadística. Pone un ejemplo sobre la medida del tamaño de una mesa de 50 ± 1 cm; en dicho contexto, se llama sigma a la desviación típica (él usa el anglicismo desviación estándar). Si en otra mesa se miden 53 cm, se dice que está a 3 sigmas (desviaciones típicas) de la medida de la otra mesa. En el ejemplo de Héctor, cuando se mide otra mesa hay que plantear una hipótesis (que ambas mesas son del mismo modelo o han sido fabricadas por el mismo procedimiento) para poder hablar del número de sigmas de dicha medida respecto a la distribución de probabilidad de las medidas de la primera mesa. Por ejemplo, para la media de las longitudes de ambas mesas, podemos cuantificar la diferencia entre las medias dividida por el la desviación típica de la primera mesa, eso nos ofrece un número de sigmas (desviaciones típicas) de diferencia entre ambas medias. Si dicho número es grande (mayor de tres, o de cinco, según el contexto) diremos que ambas mesas tienen longitud diferente.

En inferencia estadística se usan sigmas de significación (o confianza) estadística, que no tienen nada que ver con la desviación estándar. El número de sigmas de significación es equivalente al llamado valor-p (de probabilidad, pues se calcula como una probabilidad). Nunca se debe interpretar el número de sigmas o el valor-p como una probabilidad de la hipótesis nula (pues para hablar de probabilidad tenemos que recurrir a un espacio muestral, que en este caso sería el de todas las hipótesis, lo que no tiene sentido en este contexto). Siempre se debe usar como una indicación de la significancia o confianza en la hipótesis nula; la interpretación probabilística del valor-p (o el número de sigmas) como la probabilidad de la hipótesis no tiene sentido en estadística frecuentista. Más aún, para la interpretación del resultado es muy importante usar un umbral, tanto para el valor-p (un umbral típico en biomedicina es p < 0.05) como para el número de sigmas (un umbral típico en astrofísica son 3 sigmas o en física de partículas son 5 sigmas). El umbral es fundamental en la interpretación del resultado y nunca se debería hablar de probabilidad de una hipótesis.

Héctor menciona la inferencia bayesiana para dar sentido a la idea de asignar una probabilidad a una hipótesis. Por cierto, afirma que se originó en el siglo XIX, pues piensa en el teorema de Bayes, pero que es de 1774, siglo XVIII; sin embargo, la inferencia nació en el siglo XX, y también la inferencia bayesiana (como es obvio). En inferencia bayesiana se trata de asignar una «probabilidad» a priori a la hipótesis, que se reevalúa con el teorema de Bayes y los datos obtenidos, para dar lugar a una «probabilidad» a posteriori de la hipótesis. La interpretación de este resultado es quisquilloso, porque a veces se abusa del lenguaje (como hace Héctor en el audio) y se habla de probabilidades porque se han calculado como si fueran probabilidades. Pero en inferencia bayesiana se recomienda usar un término diferente, grado de creencia o grado de confianza en la hipótesis. Este grado de creencia se estima a priori con una «probabilidad» para la hipótesis (que no es una probabilidad, pues no se puede calcular una probabilidad de una hipótesis). Se opera con probabilidades y se obtiene una «probabilidad» a posteriori para la hipótesis (pero que no nos engañen los cálculos, el resultado tampoco es una probabilidad, porque no lo era la «probabilidad» a priori). Lo riguroso es decir que se asignó un grado de creencia a priori y que tras el cálculo se ha obtenido un grado de creencia a posteriori (medido por una «probabilidad» tipo valor-p, o por un número de sigmas). Se calcula con probabilidades, pues es un cálculo estadístico, pero se debe interpreta sin recurrir a asignar probabilidades a lo que no puede tener probabilidades.

La gran dificultad en Estadística es la interpretación de los resultados; por eso a veces se habla del Arte de la Estadística. El lenguaje para relatar (o discutir) los resultados debe ser elegido con mucho cuidado. Abusar del concepto de probabilidad, aplicándolo a conceptos a los que no se les puede asociar una probabilidad, es un abuso del lenguaje (muy habitual entre físicos, ingenieros y científicos en general). Mi recomendación es que en divulgación seamos muy cuidadosos con el uso del lenguaje. Cambiar probabilidad por creencia, o por confianza, o por significación, me parece un lenguaje mucho más apropiado. Y siempre dejar claro el umbral que dota de significado a los números que se calculan. En el campo de la inferencia estadística hay muchos artículos que discuten este asunto y la importancia de un uso correcto del lenguaje (en especial, sobre el maluso del valor-p en biomedicina).

¡Que disfrutes del podcast!

Muchas gracias Francis, por tu labor divulgadora con tanto rigor. Que tengas un feliz año.

Hola Francis, magnífica tu labor divulgativa.

La pregunta es, que hay mal en esta afirmación: Si el universo empezo en una singularidad de tamaño finito hace 13 mil y pico millones de años, debe ser finito, pues su tamaño en ese tiempo no puede haber aumentado hasta infinito

Saludos

Salva

Hola Salva, no sabemos si en el nacimiento el universo era finito o infinito. El modelo ΛCDM que es el que se deduce de la Relatividad General más las condiciones de homogeneidad e isotropía a gran escala (Principio Cosmológico), admite ambos tipos de soluciones. Esas soluciones indican que si nació finito continuará siendo finito siempre y si nació infinito continuará siendo infinito siempre.

La manera más sencilla por la que estamos intentando resolver el dilema, es mediante medidas de la densidad media del universo, grosso modo: si la densidad es mayor que la “densidad crítica” el universo es finito. Si la densidad es menor o igual que la densidad crítica, el universo (si es de topología simple) es infinito.

Las mejores medidas de que disponemos actualmente son las que realizó la Misión Planck. Esas medidas dan un valor para el ratio de densidad (densidad del universo dividida entre la densidad crítica) de Ω=0.9993 ± 0.0019

Como ves, la mejor medida de la que disponemos en la actualidad no permite excluir que el universo sea finito, Ω>1 o infinito Ω≤1

Puedes ampliar información, por ejemplo, en La web de Física:

https://forum.lawebdefisica.com/forum/el-aula/relatividad-y-cosmología/41283-tamaño-del-universo-observable-y-del-universo-en-su-totalidad?p=286240#post286240

Saludos.

Saludos Albert buen aporte, una duda, ¿inflación podría tener algo que decir al respecto?, quiero decir, inflación es el mecanismo propuesto por los físicos para explicar como el universo pasa de un estado inicial singularmente denso y caliente a estados no singulares. La renormalización hecha proceso físico.

¿Si existe inflación y se demuestra de alguna manera que ocurrió también sería posible que empezase siendo infinito pero terminase siendo finito?

Albert muchas gracias por la aclaración

Hola Francis, muchas gracias y como siempre increíble trabajo. Te escribo para preguntarte alguna recomendación de un buen libro de estadística (en inglés o castellano, me es indiferente). Soy matemático y físico pero considero que sé muy poco de estadística, y me apetece profundizar con un buen libro, ya que el que estudié en la carrera no me entró demasiado bien. Un saludo y de nuevo muchas gracias por todo este trabajo divulgativo tan exquisito que haces.

Borja, si lo que quieres es disfrutar, te recomiendo Richard W. Hamming, «The Art Of Probability,» (1994), que seguro que te sorprenderá siendo matemático. Para el uso de la estadística que requiere un físico, recomiendo Louis Lyons, «Statistics for nuclear and particle physicists» (1986); siendo un libro antiguo, que no incluye las técnicas de análisis estadístico basados en inteligencia artificial y aprendizaje automático, incluye una buena presentación del contraste de hipótesis (inferencia estadística) y de los métodos de Montecarlo (esto último justifica el título). Si no te interesa aprender estadística como tal, sino profundizar en la «filosofía» detrás de la estadística te recomiendo I. J. Good, «Good Thinking. The foundations of probability and its applications» (1983); usa el hilo de la historia para justificar las ideas más relevantes de la estadística actual (así comprenderás por qué la estadística es tan difícil como es y no puede ser más fácil.

Francis

Que piensas de este paper

https://www.pnas.org/doi/10.1073/pnas.2304934120

sobre que en la evolucion no es puro azar?

aca discuten tambien sobre si es puro azar

https://theconversation.com/cuanto-de-azar-tiene-la-evolucion-187178

https://www.science.org/doi/10.1126/science.aap9125

Matias, la deriva aleatoria y la selección evolutiva están tan interconectadas que no es posible hablar de azar, como si todo en la evolución fuera puro azar (recuerda que la selección es una «fuerza evolutiva» sistémica). En cuanto al artículo en PNAS, estudia en un procariota un fenómeno habitual en eucariotas, el ligamiento genético, la tendencia de ciertos genes a ser heredados juntos debido a su proximidad física en el mismo cromosoma; la proximidad conlleva un sesgo en las mutaciones, que en última instancia es debido a la selección, lo que permite cierto grado de predictibilidad. En eucariotas, este fenómeno está relacionada con la epistasis genética, que genes con funciones relacionadas suelen estar próximos en un mismo cromosoma. En mi opinión, no se debe interpretar el artículo de PNAS como un indicio de que la evolución no sea puro azar en el contexto de la selección evolutiva.

Hola Francis, espero que estés bien. Tengo una consulta que creo que con tu conocimiento podrías aclarar. Mi pregunta se refiere a la inercia (no la masa). ¿Es la inercia un fenómeno emergente debido al efecto Doppler, específicamente el efecto Doppler relativista entre los bosones virtuales? En principio, no percibo la inercia como algo directamente vinculado a la masa en reposo, ya que la masa en reposo representa la energía necesaria para «crear» una partícula en reposo, como se evidencia claramente en la ecuación de Einstein. Sin embargo, esta relación no parece estar directamente conectada con la inercia, entendida como la resistencia al cambio en el momento.

Paso a explicar:

Dado un experimento mental, donde en una caja de masa despreciable con espejos perfectos en su perímetro interior, existe un fotón de energía hf. El fotón al «impactar» con uno de extremos de la caja, transfiere un momento igual a 2 hf/c, pero al ser simétrica la caja y al impactar en ambos extremos el fotón, la caja se mantendrá en reposo («en promedio») en el sist. de referencia.

Cuando aplicamos una fuerza externa a la caja, la caja experimenta una aceleración Fext= ma y genera una fuerza opuesta sobre el sist. externo que aplica la fuerza Fext = Fcaja (Fext se aplica sobre la caja y Fcaja se aplica sobre el sist. externo). La causa de la Fext es el propio fotón dentro de la caja. Ya que cuando el fotón se desplaza en la dirección opuesta a la aceleración, por efecto doppler relativsta el fotón «adquiere» un corrimiento al azul, por lo que el momento que el fotón transfiere en la pared donde se aplica la fuerza externa es mayor al momento que el fotón transfiere en la pared opuesta, ya que en esa dirección experimenta un corrimiento al rojo.

En el contexto de este ejercicio mental, ¿podría ser esta la raíz de la «inercia» observada en la materia? Tomemos como ejemplo la masa en reposo de partículas como el protón o el neutrón, donde el 98% de dicha masa se atribuye a la energía contenida en los gluones. ¿Es plausible que al aplicar una fuerza externa, como un campo eléctrico, los gluones virtuales experimenten un desplazamiento hacia el extremo azul en dirección opuesta al campo eléctrico, seguido de un desplazamiento hacia el extremo rojo en la misma dirección? Este proceso podría explicar cómo el protón, al realizar este «ajuste», genera una fuerza contraria que actúa sobre el sistema que aplica el campo eléctrico.

Quizás podríamos aplicar un razonamiento similar a los quarks y electrones. En el caso del electrón, por ejemplo, se observa un cambio entre el campo electrónico derecho y el campo electrónico izquierdo, mediado por el campo de Higgs y los bosones de Higgs virtuales que inducen esta alteración en la quiralidad. Al enfrentarnos a una fuerza externa, surge la pregunta: ¿Existe un efecto Doppler relativista entre los bosones de Higgs virtuales que dan el efecto de inercia?

Julián, no te confundas, el concepto de inercia no existe en física de partículas, ni en teoría cuántica de campos; de hecho tampoco existe en la teoría de la relatividad. No tiene ningún sentido buscar el posible origen de la inercia en teoría cuánticas de campos.

El concepto de inercia nace del concepto de reposo en contraste con el concepto de movimiento (con antecedentes muy antiguos, fue popularizado por Galileo y aceptado por Newton, pero descartado por Einstein). En relatividad no existe el reposo; todo se mueve a una velocidad constante en el espaciotiempo; lo que Newton llamaba reposo corresponde al movimiento en el tiempo. Por tanto, si todo se mueve (en el espaciotiempo), si el reposo no existe, no tiene ningún sentido físico su contraste con el movimiento vía el concepto de inercia.

La inercia es un concepto obsoleto, como puede ser el concepto de flogisto, que debe ser obviado en los cursos modernos de física. Solo tiene sentido en los libros de historia de la física. Así que, Julián, “que la noche de los tiempos no te confunda”.

Entonces lo que entendemos por inercia no es más que la conservación del momento, para el caso relativista, la conservación del cuadrimomento.

Julián, ¿tú entiendes por inercia la conservación del momento lineal y de la energía? No entiendo tu comentario. Lo que yo he dicho es que el término «inercia» debe ser desterrado de la física por obsoleto (y por no significar nada en la física moderna, igual que el término flogisto).

La inercia es la propiedad que tienen los cuerpos de permanecer en su estado de reposo o movimiento. Por lo que veo que es la conservación del cuadrimomento.

Nosotros ahora, apoyados en el suelo, estamos acelerando a 9,8 m/s^2, en cambio en caída libre estaríamos siguiendo a la geodésica del espacio-tiempo.

Si en un experimento mental, tenemos una caja de masa despreciable en cuyo interior hay espejos perfectos y un fotón, que impacta en la parte superior e inferior de la caja. La masa de la caja es igual a m = h f / c^2. La caja apoyada en el suelo no sigue la geodésica por la aceleración del suelo; esto es porque el suelo ejerce una fuerza sobre la caja de F_suelo = m g = (h f / c^2) * 9.8 m/s^2. Pero sobre el suelo se ejerce una fuerza opuesta F_suelo – F_caja = 0 ¿Por qué la caja ejerce una fuerza opuesta sobre el suelo? debido al efecto Doppler experimentado por el fotón al incidir en los espejos en la parte superior e inferior de la caja.

Un experimento no tan mental. Un protón se desplaza en dirección x, posee un momento p_x y energía total E = m + p_x. Si cruza una región con un campo magnético constante cuya dirección de campo es By, las partículas virtuales del campo EM interaccionarán con los quarks del protón, intercambiando momento (consideremos solo el primer término de la interacción). Si tomamos la ecuación clásica, la dispersión del protón es θ = (q⋅B⋅t) / m donde θ representa el ángulo que ha recorrido el protón en el campo magnético después de un tiempo t. Pero ahí vemos que m no es la masa de los quarks, sino que esta es 2% de la masa total que indicaría la dispersión θ que observamos. Entonces son los gluones los responsables. Pero ¿por qué? Entiendo que la energía del campo gluónico en un protón es: E = √(3/4) * 0.118 GeV^-2 * (2 * m_u + m_d) * (2/3)^2 + (-1/3)^2 donde m_u es la masa del quark up, 0.31 GeV/c^2 y m_d es la masa del quark down, 0.42 GeV/c^2 pero ¿por qué esa energía también afecta al cambio de momento que sufriría el protón?

Quizás me esté liando demasiado y entiendo que la perturbación del campo gluónico y de quarks en un protón es un caos (interacción gluon gluon, hasta pares electrón – positrón podríamos encontrar en el protón, etc) y estoy haciendo una simplificación enorme.

Guau muchisimas gracias por contestarme! 🙂 Tengo que confesar que envie esa pregunta cuando acababa de descubrir el podcast (suelo seguir la divulgacion en ingles y en italiano) y no tenia ni idea de que cada programa se comenta en este blog, que trabajo enorme! A raiz de vuestras excelentes respuestas he ido ahondando el tema de la hipotesis de curvatura del tensor de Weyl y el campo de Tolman. Sin embargo, no he logrado entender muy bien la propuesta de Tolman, y no he encontrado los articulos originales de los años 30 y 40 donde se aborda el tema. Por lo que tengo entendido, es un poco el padre de la cosmologia ciclica, y me resultaria de sumo interes poder recuperar sus articulos para ir recapitulando estas hipotesis desde los comienzos…muchas gracias otra vez por las respuestas y la disponibilidad! 🙂 Un saludo!

Thomas, te recomiendo el libro de Tolman, “Relativity, Thermodynamics, and Cosmology” (1934), reeditado por Dover en 2003. Su famoso artículo es “On the Problem of the Entropy of the Universe as a Whole,” Phys. Rev. 37: 1639 (1931), https://authors.library.caltech.edu/3678/1/TOLpr31b.pdf; “On Thermodynamic Equilibrium in a Static Einstein Universe,” PNAS 17: 153-160 (1931), https://www.pnas.org/doi/pdf/10.1073/pnas.17.3.153; “On the Theoretical Requirements for a Periodic Behaviour of the Universe,” Phys. Rev. 38: 1758 (1931), https://sci-hub.st/https://doi.org/10.1103/PhysRev.38.1758; etc. Busca más en Google Scholar.

Maravilloso, muchisimas gracias! 🙂 Intentare hacerme con el libro de Tolman, ya que hay conceptos en termodinamica y relatividad que se me resisten bastante…

Perdona pero acabo de flipar, osea que Tolman ya en 1931 hablaba de «Heath death», muerte termica…en segundo lugar, hipotiza un universo simplemente poblado por radiacion (osea, Penrose no es que haya inventado nada…) y demuestra que la entropia relativistica de un universo poblado solo de radiacion es…cero, osea puede crecer localmente pero al cabo de trascurrir un tiempo inimaginablemente largo puede fluctuar de regreso a su valor inicial, que es cero. Para el principio antropico, entonces, estariamos viviendo una rara epoca de vitalidad del universo, la unica compatible con la vida. Esto se me parece un monton a los magnificos teoremas de recurrencia de Poincaré. Que maravilla, gracias!