He participado en el episodio 440 del podcast Coffee Break: Señal y Ruido [Acast A, Acast B; iVoox A, iVoox B; iTunes A y iTunes B], titulado “Ep440: Betelgeuse; Rayo Cósmico; Homeostasis; Planeta 9; Genoma», 30 nov 2023. «La tertulia semanal en la que repasamos las últimas noticias de la actualidad científica. En el episodio de hoy: Cara A: Rectificación sobre astroturismo en Málaga: AstroLab (5:00). Proyecto de ciencia ciudadana para observar la ocultación de Betelgeuse (15:00). Telescope Array observa un protón con unos 250 exaelectrónvoltios (31:00). Cara B: Proteínas intrínsecamente desordenadas y la cantidad de agua “libre” dentro de una célula (14:00). Planeta 9, ¿existe o no? (46:00). El genoma visualizable (1:34:00). Señales de los oyentes (1:44:00). Imagen de portada realizada por Héctor con Midjourney. Todos los comentarios vertidos durante la tertulia representan únicamente la opinión de quien los hace… y a veces ni eso».

¿Quieres patrocinar nuestro podcast como mecenas? «Coffee Break: Señal y Ruido es la tertulia semanal en la que nos leemos los papers para que usted no tenga que hacerlo. Sírvete un café y acompáñanos en nuestra tertulia». Si quieres ser mecenas de nuestro podcast, puedes invitarnos a un café al mes, un desayuno con café y tostada al mes, o a un almuerzo completo, con su primer plato, segundo plato, café y postre… todo sano, eso sí. Si quieres ser mecenas de nuestro podcast visita nuestro Patreon (https://www.patreon.com/user?u=93496937); ya sois 120, muchas gracias a todas las personas que nos apoyan. Recuerda, el mecenazgo nos permitirá hacer locuras cientófilas. Si disfrutas de nuestro podcast y te apetece contribuir… ¡Muchísimas gracias!

Descargar el episodio 440 cara A en Acast.

Descargar el episodio 440 cara B en Acast.

Como muestra el vídeo participamos por videoconferencia Héctor Socas Navarro @HSocasNavarro (@pCoffeeBreak), Alberto Aparici @cienciabrujula, Gastón Giribet @GastonGiribet (solo cara B), y Francis Villatoro @eMuleNews.

Tras su presentación, Héctor se congratula de que hayamos recibido el Premio del Público ASESPOD 2023 (LCMF, 28 nov 2023), y agradece a todas las cientófilas que nos habéis votado. Ningún podcast había logrado ganar dos veces consecutivas, ni siquiera ganar dos veces (el premio del público de ASESPOD nació en 2013). Las reglas de este premio prohíben ganar más de dos veces consecutivas, aunque se puede volver a ser finalista, por ello no nos presentaremos el próximo año, ¡así de soberbios científicos somos!

Héctor también destaca el proyecto StarBlink de Ciencia Ciudadana para observar la ocultación de Betelgeuse (α Orionis) por el asteroide (319) Leona. Esta ocultación permitirá determinar algunas características de Betelgeuse, como su diámetro o su posición exacta en el cielo, difíciles de estimar de otra forma debido a su gran brillo. La hora prevista para la ocultación será el 12 de diciembre de 2023 a las 02:15 AM (hora peninsular), es decir, en la noche entre el lunes 11 de diciembre y el martes 12 de diciembre; durará unos 12 segundos en las zonas de la centralidad.

Podrá observarse en una franja en la Península Ibérica que discurre desde el Algarve portugués, pasando por Huelva, Sevilla, Córdoba, Jaén, Murcia y Alicante, hasta Ibiza (mapa interactivo). Si eres aficionado a la Astronomía, apúntate a esta observación (yo te recomiendo contactar con la asociación astronómica más cercana a tu vivienda para que todos los datos que obtengas sean aprovechables). Más información en «Un proyecto sobre ocultaciones astronómicas y ciencia ciudadana», StarBlink.

Me toca realizar una rectificación. La semana pasada dije que no había astroturismo en Málaga (tenía en mente a Málaga capital). Por supuesto, me han dado una merecida colleja José Antonio Jiménez y María H. Jurado, de AstroLab (Yunquera, Málaga). Llevan desde el año 2012 realizando actividades de AstroTurismo en Málaga y otras provincias andaluzas, aunque con la denominación comercial AstroLab desde 2016; son la primera empresa de ecoturismo del registro de Turismo Andaluz de Málaga. Esta empresa se dedica al turismo científico tanto en su Observatorio Astronómico Público de Yunquera, como al aire libre en el Parque Nacional Sierra de las Nieves. Por sus actividades han pasado miles de personas de todo el territorio nacional, y de otros países. También realizan actividades de formación en Astronomía en centros educativos de la provincia de Málaga. Debido a la pandemia se convirtieron en la primera escuela online de Astronomía de España. De hecho, Héctor ha participado en algunas de nuestras clases online como «AstroProfe por un día».

Debo pedir disculpas públicas a María y José Antonio por mi mala memoria. Máxime cuando colaboré con ellos en la dirección del Trabajo Fin de Máster de Antonio Javier Guerrero Angulo, «Búsqueda de asteroides en imágenes astronómicas», Máster en Ingeniería Industrial, Escuela Técnica Superior de Ingeniería Industrial, Universidad de Málaga, 05 sep 2017. En dicho trabajo se buscaron NEOs en imágenes astronómicas del Observatorio de AstroLab.

Me toca comentar que el observatorio de rayos cósmicos Telescope Array (Utah, EEUU) ha observado un protón con unos 250 exaelectrónvoltios (EeV). Los rayos cósmicos ultraenergéticos pueden alcanzar energías en la escala de los exaelectrónvoltios, 1 EeV = 10¹⁸ eV, es decir, en la escala de los julios (J); pero estos rayos cósmicos son muy poco frecuentes pues su fuente tiene que estar muy cerca (menos de 50 Mpc) para evitar el corte GZK (Greisen–Zatsepin–Kuzmin en 1966). Un rayo cósmico bariónico (protón o núcleo atómico) puede interaccionar con los fotones del fondo cósmico de microondas (CMB); hay unos diez mil millones de fotones por cada barión (Alberto recalca que unos 400 por centímetro cúbico de todo el universo), luego si el protón recorre una gran distancia acabará colisionando con algunos de estos fotones; en dicha interacción el protón se excita en una estado metaestable que se desintegra en un protón y un pión neutro (o en un neutrón y un pión cargado), con lo que pierde energía; en el caso de un núcleo ocurre una fotodesintegración con similar resultado.

El récord actual se observó en 1991 con 320 ± 90 EeV (∼ 51 J) en el detector Fly’s Eye en Utah (EEUU), que fue llamado Oh-My-God; en 2001 se observó otro con ∼ 280 EeV (sin nombre). Ahora se publica en Science un tercero con 244 ± 76 EeV (∼ 40 J), observado el 27 de mayo de 2021 por detector Telescope Array (Utah), que ha sido llamado Amaterasu (una diosa sintoísta cuyo nombre significa «la gran divinidad que ilumina el cielo»); casi seguro que es un protón (se descarta que sea un fotón, pero podría ser un núcleo atómico pesado). Si es un protón, su colisión contra un núcleo atómico en la atmósfera equivale a una energía de ∼ 700 TeV en el centro de masas (c.m.), es decir, unas 50 veces los 13.5 TeV c.m. de las colisiones protón-protón en el LHC del CERN. La incertidumbre en la estimación en la energía es tan grande que no sabemos si Amaterasu es el más energético, el segundo o el tercero. En realidad es irrelevante qué puesto ocupe.

Lo más relevante es que el observatorio Telescope Array ha detectado 28 rayos cósmicos con energías mayores de 100 EeV entre mayo de 2008 y noviembre de 2021. Para muchos de estos rayos cósmicos se ha podido localizar la fuente más probable (M87, Centaurus A, M82 y otras fuentes bien conocidas). Por desgracia, no se ha podido localizar la fuente de Amaterasu, que debería estar a unos 27 ± 4 Mpc (si es un protón) en la dirección del cielo donde está el Vacío Local adyacente al Grupo Local. Aunque algunos medios han afirmado que es un misterio cuál puede ser la fuente, lo cierto es que sabemos que es un núcleo galáctico activo en alguna de las muchas galaxias que hay en el Vacío Local, pero no sabemos en cuál. Los autores del artículo han metido cizaña entre los periodistas al afirmar que la fuente podría estar fuera del Vacío Local si hubiera nueva física capaz de desviar este rayo cósmico más de lo que lo hacen los campos magnéticos; como es obvio, se trata de un boutade de los investigadores, que debe ser descartada.

El artículo es Telescope Array Collaboration, «An extremely energetic cosmic ray observed by a surface detector array,» Science 382: 903-907 (24 Nov 2023), doi: https://doi.org/10.1126/science.abo5095; el récord en D. J. Bird, S. C. Corbato, …, M. A. Huang, «Detection of a cosmic ray with measured energy well beyond the expected spectral cutoff due to cosmic microwave radiation,» Astrophysical Journal 441: 144-150 (1995), 1995ApJ…441..144B; y el segundo en N. Hayashida, K. Honda, …, H. Yoshii, «Observation of a Very Energetic Cosmic Ray Well Beyond the Predicted 2.7 K Cutoff in the Primary Energy Spectrum,» Phys. Rev. Lett. 73: 3491 (1994), doi: https://doi.org/10.1103/PhysRevLett.73.3491. Recomiendo leer mi pieza en este blog «Telescope Array (Utah) observa un rayo cósmico con una energía de 244 ± 76 EeV (∼ 40 J)», LCMF, 24 nov 2023. Héctor recomienda leer a Ethan Siegel, «The simplest explanation for ultra-high-energy cosmic rays,» Starts with a Bang, 28 Nov 2023.

Nos cuenta Alberto que se ha publicado en Nature una nueva función de la condensación de proteínas, regular la disponibilidad de agua en las células. El agua es esencial para los procesos biológicos celulares, luego debe ser regulada ante cambios de presión osmótica (cuando el exterior de la célula es hipoosmótico, con una concentración de solutos menor que la del citoplasma, ingresará agua en la célula, y lo contrario en el caso hiperosmótico) o de temperatura (un aumento de temperatura es similar a la hipoósmosis y una disminución a la hiperósmosis). Tanto el control celular de la ósmosis celular es lento (con escalas de tiempo entre minutos y horas). Para lograr una respuesta más rápida, tanto a cambios osmóticos como térmicos, las células usan la condensación de proteínas.

Las proteínas (como otras macromoléculas) están hidratadas (rodeados de una capa hídrica de moléculas de agua con una movilidad reducida respecto a las del agua «libre» en el citoplasma). De hecho, la mayoría de las proteínas presentan regiones intrínsecamente desordenadas (IDR) que tienen una gran capacidad para retener agua. Pero cuando estas proteínas forman un condensado proteico (que suele llamar orgánulo sin membrana) se expulsa gran parte del agua de la capa hídrica de sus IDR. Lo que se ha descubierto es que, en un ambiente hiperosmótico, o a una temperatura baja, debe aumentar el agua libre, por lo que se activa la formación de condensados de proteínas, en los que se ocultan los IDR, que se deshidratan, incrementando el agua libre en el citoplasma. Por contra, en un ambiente hipoosmótico, o bajo una temperatura alta, debe disminuir el agua libre de forma rápida, para ello se activa la separación de los condensados de proteínas, que acaban exponiendo sus IDR, que se hidratan almacenando una gran cantidad de agua. En el lenguaje de la termodinámica, los condensados biomoleculares ajustan el potencial osmótico (Ψ) y el potencial químico (μ) del agua para mantener un equilibrio hídrico (homeostasis).

El artículo apoya esta nueva hipótesis con una metodología experimental muy completa. Pero Alberto no tiene tiempo para explayarse mucho en ella. El artículo es Joseph L. Watson, Estere Seinkmane, …, Emmanuel Derivery, «Macromolecular condensation buffers intracellular water potential,» Nature 623: 842-852 (18 Oct 2023), doi: https://doi.org/10.1038/s41586-023-06626-z; más información divulgativa en J. Pedro de Souza, Howard A. Stone, «Protein condensation regulates water availability in cells,» Nature 623: 698-699 (18 Oct 2023), doi: https://doi.org/10.1038/d41586-023-03098-z.

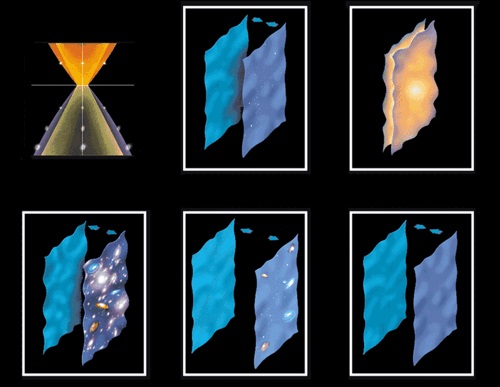

Héctor nos comenta dos nuevos artículos sobre el supuesto Planeta 9, uno a favor y otro en contra. Pero primero recuerda que la existencia de este planeta ha sido sugerido por un agrupamiento orbital entre varios cuerpos transneptunianos (TNOs) llamados sednoides, que tendría su origen en dicho planeta. En contra tenemos el primer artículo, que estudia los tres sednoides más alejados: Sedna, 2012 VP113 y Leleakuhonua (2015 TG387). Al integrar su órbita hacia el pasado (curvas azul, roja y gris en esta figura) se observa que sus líneas de ápsides (líneas entre perihelio y afelio) se agruparon hace 4500 millones de años. Esta «alineación primordial» podría explicar el agrupamiento observado hoy de los sednoides, sin necesidad de recurrir al planeta 9 (que no existiría). No se sabe por qué se agruparon en aquella época, pero los autores proponen dos escenarios plausibles: un planeta masivo que existió en aquella época, o un paso estelar temprano. Héctor (a favor del planeta 9) nos recuerda que el problema con esta hipótesis de la «alineación primordial» es que también debería observarse con el resto de los sednoides conocidos (pero los autores afirman que la incertidumbre en su órbita es tan grande que es difícil reconstruirla hasta los orígenes del Sistema Solar).

Para Héctor es poco plausible que esta explicación sea correcta. Entre sus argumentos está que parece poco plausible que estos sednoides no hayan sido perturbados por otros cuerpos (encuentros con estrellas cercanas u otros cuerpos) durante los últimos 4500 millones de años. Además, las órbitas actuales de estos sednoides son hoy más diferentes de lo que se esperaría a partir de una hipótesis de alineación primordial. Y, finalmente, en el nuevo artículo no se ofrecen simulaciones que comparen entre sí el efecto de un planeta 9 y el efecto de un alineamiento primordial; quizás deberían ser exigidas en la revisión por pares del artículo. En cualquier caso, el artículo es Yukun Huang, Brett Gladman, «Primordial Orbital Alignment of Sednoids,» arXiv:2310.20614 [astro-ph.EP] (31 Oct 2023), doi: https://doi.org/10.48550/arXiv.2310.20614.

El segundo artículo está a favor de la hipótesis del planeta 9 (por ello Héctor lo rescata ahora en noviembre de 2023, aunque se publicó en mayo de 2022). Dos investigadores de la Univ. Complutense de Madrid, Carlos y Raúl de la Fuente Marcos realizan un estudio estadístico de la distribución de los nodos ascendentes de las órbitas de todos los objetos transneptunianos extremos (ETNOs) conocidos (que son 51); este estudio actualiza un estudio previo de 2021 (cuando se conocían 39 ETNOs). El punto de la órbita que cruza la eclíptica de norte a sur es el nodo descendente, y de sur a norte es el nodo ascendente. Observando la distancia entre los nodos ascendentes y los nodos descendientes de las 1275 parejas de estos 51 cuerpos se puede estimar la correlación entre sus órbitas. Para estimar la significación de la hipótesis de que hay una correlación se han comparado los 51 ETNOs, con varios modelos aleatorios de un disco no sesgado (o no correlacionado), según los autores; en el contraste de hipótesis se obtiene una asimetría estadísticamente significativa de 62 σ (sigmas), cuando en el artículo de 2021 se habían obtenido 63 sigmas. Más aún, a favor de la hipótesis de que los nodos descendentes están distribuidos de forma aleatoria, pero los nodos ascendentes están correlaciones es de, nada más y nada menos, 171.5σ (respecto a la hipótesis nula de que ambos sean aleatorios).

Lo siento, pero una significación de más de 170 sigmas, o incluso de más de 60 sigmas, me parece sospechosa. Lo habitual es que para más de 20 sigmas sea tan obvia la hipótesis, que baste una figura (adecuada) para ilustrarla fuera de toda duda (por ello hay tan pocos artículos con hipótesis con más de 20 sigmas de significación). Más aún, que pasar de 39 a 51 ETNOs, con una mejora del análisis estadístico, implique una modificación ridícula de la significación estadística (de 63 a 62 sigmas), me sugiere que el origen de esta significación estratosférica es la metodología experimental (lo que Héctor llama errores sistemáticos). Los sesgos de confirmación en el análisis estadístico realizado son responsables más de 60 sigmas de significación; de ahí que la inclusión de nuevos datos no modifique casi nada dicha significación metodológica. Por supuesto, espero estar equivocado, y acepto las collejas que me quieran dar los autores (a los que seguro no les gustará mi crítica).

Héctor ve con muy buenos ojos este tipo de artículos que apoyan la hipótesis del Planeta 9 con muchas sigmas de significación. Siendo comprensible, ya que él ha emprendido una búsqueda activa de dicho planeta transplutoniano, en mi modesta opinión, «se le ve el plumero». En cualquier caso, recomiendo consultar el artículo a los interesados en los detalles del análisis estadístico (que Héctor ha tratado de explicar en detalle en el podcast): Carlos de la Fuente Marcos, Raúl de la Fuente Marcos, «Twisted extreme trans-Neptunian orbital parameter space: statistically significant asymmetries confirmed,» Monthly Notices of the Royal Astronomical Society (MNRAS) Letters 512: L6-L10 (01 May 2022), doi: https://doi.org/10.1093/mnrasl/slac012, arXiv:2202.01693 [astro-ph.EP] (03 Feb 2022).

Me toca comentar un artículo en Nature Communications sobre el llamado genoma observable con imagen molecular (imageable genome), que se espera que tenga gran impacto futuro en la medicina molecular. El primer autor es Pablo Jané (Univ. Ginebra, Suiza) y el autor principal es Martin A. Walter (Hospital St. Anna, Univ. Lucerna, Suiza). El objetivo de la medicina molecular es comprender las causas de las enfermedades humanas a nivel molecular para diseñar nuevas terapias. Con el Proyecto Genoma Humano (PGH) se pretendía desvelar la relación entre el genoma y las enfermedades; por desgracia, aún queda mucho para lograrlo (salvo en las enfermedades monogénicas), pues es muy difícil observar la expresión de genes.

Se llama imagen molecular a una técnica de diagnóstico in vivo que permite observar los niveles de ciertas moléculas diana de forma cuantitativa y no invasiva. En el caso de las proteínas, permite cuantificar la expresión de los genes que las codifican. La técnica más popular se basa en la tomografía por emisión de positrones (PET) usando radiotrazadores (como ¹⁸F-FDG, fluorodesoxiglucosa con flúor-18) que emiten positrones por radiación beta; se inyectan por vía sanguínea, llegan al órgano a explorar y permiten observar la actividad de ciertas proteínas. Se usan mucho en oncología para estudiar la progresión de los tumores y estudiar el impacto de los fármacos y tratamientos; pero también se pueden usar en otras enfermedades, para visualizar su patobiología a nivel espaciotemporal. La base de datos MICAD (Molecular Imaging and Contrast Agent Database, o base de datos de agentes de contraste y de imagen molecular) del NIH contiene 5360 de estas sustancias.

En la práctica clínica se están usando menos del 1 % de estos radiotrazadores. En el contexto de la medicina basada en la evidencia, la gran dificultad es la ausencia de metaanálisis de la literatura científica que sintentizan toda la evidencia sobre su utilidad en muchas enfermedades. El nuevo artículo propone usar inteligencia artificial (IA) y aprendizaje profundo (DL) para producir de forma automática una conexión entre los radiotrazadores y el genoma con el objetivo de desvelar el papel que pueden tener en el estudio de muchas enfermedades y en el descubrimiento de futuros tratamientos. En cierto sentido lo que se pretende es automatizar la producción de evidencia a partir de metaanálisis virtuales. El genoma visualizable o, mejor, el genoma observable con imágenes (imageable genome) constituye casi el 6 % del genoma que codifica proteínas humanas y el 1.8 % de todo el genoma humano. En el nuevo estudio se han identificado nuevas relaciones entre genes (observables con imágenes) y enfermedades; el 2 % de los genes identificados son marcadores de enfermedades oncológicas, neurológicas y cardiológicas. Además, este genoma observable está correlacionado con el empeoramiento del pronóstico, como la transformación de tejidos sanos en enfermos y los signos de resistencia al tratamiento con medicamentos.

Usando aprendizaje automático y aprendizaje profundo, con un enfoque híbrido humano-IA (habitual en aplicaciones biomédicas), se han correlacionado múltiples bases de datos de artículos biomédicos (PubMed), radiotrazadores (MICAD), expresión de genes en tejidos (GEO) y asociaciones entre genes y enfermedades (DisGeNET), con datos clínicos de pacientes obtenidos con imagen molecular (perfiles de expresión génica de 16 327 pacientes y 50 403 sujetos sanos). Se ha desarrollado un secuencia de procesado (pipeline) de estos macrodatos; que según los autores, como no, es simple, robusto, fácil de aplicar y capaz de lidiar con grandes bases de datos en crecimiento continuo. Se han usado diferentes software escritos en lenguajes muy populares, como Python y SQL. En PubMed hay 33.4 millones de artículos, con 22.5 millones de resúmenes (abstracts). MICAD contiene 5360 moléculas relacionadas con 4531 artículos de PubMed. Usando el nuevo software se analiza el contenido textual de estos artículos con los resultados clínicos de expresión y las bases de datos de moléculas.

El resultado obtenido ha sido la identificación de 6387 publicaciones sobre 9285 asociaciones entre genes y radiotrazadores. Estos radiotrazadores permiten estudiar la expresión de 1173 genes observables con imágenes en todos los cromosomas (salvo el Y) y 7 genes codificantes de proteínas mitocondriales. En el artículos resumen la información recabada en diferencias áreas de la medicina (neurología, cardiología, oncología, etc.). Lo interesante no son los resultados obtenidos ahora, sino las implicaciones en la práctica clínica que tendrán los resultados presentes y futuros que se obtengan con este nueva metodología semiautomática de generación de evidencia biomédica. En mi opinión, este campo emergente tiene un futuro muy prometedor. El artículo es Pablo Jané, Xiaoying Xu, …, Martin A. Walter, «The Imageable Genome,» Nature Communications 14: 7329 (13 Nov 2023), doi: https://doi.org/10.1038/s41467-023-43123-3; más información divulgativa en Swasti Tyagi, «Unlocking the Secrets of Disease: The Imageable Genome and the Future of Molecular Medicine,» CBIRT, 18 Nov 2023; y en la nota de prensa «New method unveils the «imageable genome» for medical diagnostics,» University of Lucerne, 17 Nov 2023.

Y pasamos a Señales de los Oyentes. Cristina Hernández García pregunta: «Conociendo los acercamientos de otras estrellas y si se descubre el planeta 9 y se determina su composición, ¿se podría saber si ha sido robado a alguna estrella y a cuál de ellas?» Héctor contesta que no se podría saber por la composición del planeta, que solo contiene trazas de la composición de su estrella, alrededor de qué estrella pudo formarse.

falciforme en la que una mutación de un único nucleótido (GAG por GTG) cambia un glutamato (E), un aminoácido hidrófugo (+8.3) por una valina (V), que es hidrófila (−2.6). Por supuesto, hay casos en los que se mantiene la hidrofobicidad, como en la mutación de los codones GGN de la glicina (−1.0) en los GCN de la alanina (−1.6). Pero no hay ninguna regla general al respecto que subyaga al código genético; aunque, como 13 aminoácidos son hidrófugos y solo 7 son hidrófilos, por simple estadística, hay más ejemplos a favor de que no cambie, que de que cambie.

Cristina Hernandez García pregunta: «¿La existencia de axiones por simetría CP en QCD afectaría al modelo de universo ecpirótico de Turok?» Gastón contesta que los axiones QCD son partículas pseudoescalares predichas por Roberto Peccei y Helen para resolver un problema de la QCD (que debería violar la simetría CP como la interacción débil, pero a nivel experimental no se observa dicha violación). Como dichos axiones no han sido observados, Gastón afirma que cree que la QCD podría violar dicha simetría. Yo contesto que no conozco ninguna relación entre el modelo ecpirótico de Turok et al. (2001), en el que dos 3-branas colisionan dando origen al big bang, con la violación de la simetría CP o con los axiones QCD; comento que las 3-branas tienen asociados campos gauge (QCD) que pueden violar la simetría CP, pero no me consta que esto influya en el modelo ecpirótico. Gastón comenta que quizás Cristina se refiere al modelo CPT invariante de Turok et al. (2018) que explica la asimetría entre materia y antimatería con el surgimiento de dos universos (nuestro universo de materia y un antiuniverso de antimateria) en el big bang; pero en este modelo la simetría CP o los axiones QCD tampoco juegan ningún papel. Así que la respuesta a la pregunta de Cristina es que no afecta de ninguna forma que conozcamos.

pregunta a Gastón: n campo escalar (adecuado) a la relatividad general usando una cambio de escala en la métrica (que se multiplica por dicho campo escalar). Este cambio de escala suele ser llamada transformación conforme por los matemáticos, aunque los físicos prefieren llamarla transformación conforme de Weyl. Contestanto a Ligeria, dicha transformación no tiene nada que ver con las transformaciones conformes de las teorías CFT (teorías cuánticas de campos con invarianza conforme, en las que se añade la invariancia conforme a la invarianza bajo difeomorfismos).

Gastón no hace referencia explícita en su respuesta a los campos escalares de tipo camaleón. Estos campos tienen una partícula de masa efectiva variable que depende de la densidad de energía del vacío; es decir, son campos con una autointeracción que depende de propiedades del vacío. Estos campos se propusieron en 2004 para explicar la energía oscura, que es un fenómeno reciente y no se observa para z > 2 (esto último se puede explicar con el cambio de masa). Complemento la respuesta de Gastón con lo siguiente: se propuso en 2008 que el campo escalar asociado a una teoría f(R) se puede comportar como un campo tipo camaleón que explique la energía oscura.

¿imagen por resonancia magnética funcional (fMRI) con las imágenes observadas por sujetos delante de un monitor; entrenando una IA para dicha tarea, con un conjunto limitado de imágenes, se puede identificar qué imagen está observando una persona. Sin embargo, el problema inverso no es posible; hasta donde me consta, usando técnicas no invasivas como la estimulación magnética transcraneal, no se puede inducir que una persona imagine una imagen determinada (aunque se puede inducir la percepción de destellos).

¡Que disfrutes del podcast!

Hola Francis!

Esto del bronce violeta,

https://www.science.org/doi/10.1126/science.abp8948

Es otro LK99?

Parece muy prometedor.

Saludos!

Alejol9, ¿qué te hace sospechar del articulo? Te recomiendo leer a César Tomé, “Purple bronze, from insulator to superconductor and back,” Mapping Ignorance https://mappingignorance.org/2023/11/21/instant-transition-from-insulator-to-superconductor-and-back/

Me hace sospechar que 100 muestras les dieron 100 resultados distintos y que nadie replico el experimento, eso me dio un «deja vu» de LK99.

Ojala funcione, parece interesante.

Saludos!

Hola Francis

Crees que IBM lograra su hoja de ruta? 2029 /33 correcion de errores en computacion cuantica?

Mariana, no lo sé, pues es una hoja de ruta muy ambiciosa, que además oculta algunas «trampas» que pasan desapercibidas para los medios. Hasta ahora, que yo sepa, IBM no ha alcanzado la ventaja cuántica, que Google logró con Sycamore (53 cúbits). Ni Eagle (127 cúbits), ni Osprey (433 cúbits) lo han logrado. La promesa de IBM es lograrlo con el nuevo Condor (1121 cúbits) (https://newsroom.ibm.com/IBM-research?item=32425). Si lo logra, lo sabremos en 2024.

No hay estimación oficial del volumen cuántico de estos ordenadores de IBM, pero las «malas lenguas» (blogueros expertos en computación cuántica) dicen que es muy bajo, demasiado bajo para soñar con la ventaja cuántica. Además, el nuevo anuncio de IBM (https://research.ibm.com/blog/quantum-roadmap-2033) dice que «We have introduced IBM Condor, a 1,121 superconducting qubit quantum processor (…). With performance comparable to our previous 433-qubit Osprey»; esto sugiere que su volumen cuántico podría ser similar, con lo que la ventaja cuántica sería inalcanzable con dicho ordenador.

Ya veremos lo que pasa el próximo año, pero mi temor es que IBM no podrá demostrar la ventaja cuántica con sus 1121 cúbits. En su caso, IBM estaría siguiendo los pasos de D-Wave, que considera irrelevante lograr la ventaja cuántica (porque es incapaz de lograrla). La hoja de ruta de IBM oculta estas «trampas».

hola gracias

Que blog me podes pasar sobre computacion cuantica que seguis?

cirac dice que en las proxinas decadas se encontraraon otros usos donde el salto sea exponencial para la computacion cuantica con respecto a la clasica como ahora solo es en criptografia y simulacion

cuales areas crees que seran esas ? expeculando y por que crees que es imposible que la computacion cuantica alguna vez sea como la computadora clasica unviersal? cuales son las razones tecnicas de eso?

Hay muchos, como Shtetl-Optimized (Scott Aaronson) https://scottaaronson.blog/, Quantum Frontiers (John Preskill) https://quantumfrontiers.com/,