En inteligencia artificial se recuerda el año 1997 porque Deep Blue (IBM) venció a Gary Kasparov, campeón del mundo de ajedrez. El año 2016 será recordado porque AlphaGo (Google DeepMind) ha vencido a Fan Hui (dan 2), campeón europeo de Go. En marzo luchará contra Lee Sedol (dan 9), el jugador de Go más fuerte del mundo. Aunque todos los expertos esperan AlphaGo pierda, todos temen que en un futuro torneo en 2017 acabe venciendo. El algoritmo tipo caja negra que usa AlphaGo ha sido publicado en Nature.

Hoy en día los programas de ajedrez son más fuertes que los humanos, pero juegan un ajedrez diferente, menos bello, menos humano, basado en el uso de la fuerza bruta en lugar de una estrategia planificada. Con los programas de Go acabará pasando lo mismo, jugarán sin cometer errores y vencerán siempre que el jugador humano cometa un error. En pocos años los programas de Go sólo competirán contra otros programas y los humanos sólo los usarán para entrenarse.

El artículo es David Silver et al., «Mastering the game of Go with deep neural networks and tree search,» Nature 529: 484–489 (28 Jan 2016), doi: 10.1038/nature16961; más información en Elizabeth Gibney, «Google AI algorithm masters ancient game of Go,» News, Nature 529: 445–446 (28 Jan 2016), doi: 10.1038/529445a; la opinión de jugadores expertos en Elizabeth Gibney, «Go players react to computer defeat,» News, Nature (28 Jan 2016), doi: 10.1038/nature.2016.19255; no me gusta el sensacionalismo del editorial «Digital intuition,» Nature 529: 437 (28 Jan 2016), doi: 10.1038/529437a, pues el algoritmo de AlphaGo es todo lo contrario a la intuición humana.

En español puedes leer a «La inteligencia artificial de Google derrota al campeón europeo de Go», Agencia SINC, 27 Ene 2016; Javier Salas, «La inteligencia artificial conquista el último tablero de los humanos», Materia, El País, 27 Ene 2016; Teresa Guerrero, «La máquina vuelve a ganar al hombre», Ciencia, El Mundo, 27 Ene 2016; y muchos más.

Los algoritmos de optimización basados en redes de neuronas artificiales son algoritmos tipo «caja negra» (black box). Cuando funcionan bien, nadie comprende el porqué. La clave es la fase de aprendizaje, en la que se entrena la red con cierto número de ejemplos para que almacene una serie de representaciones internas (patrones) asociadas a dichos ejemplos. La red bien entrenada generaliza dichos ejemplos (reconoce patrones diferentes a los que almacenó como próximos a alguno de ellos) y gracias a ello es capaz de realizar de forma eficiente cierta tarea (como resolver un problema de optimización o evaluar un movimiento en un juego como el Go). A diferencia de los algoritmos estadísticos de optimización, hoy en día no es posible reconstruir el proceso seguido por la red (hay estudios que han intentado hacerlo mediante técnicas de análisis de sensibilidad, pero por ahora no han tenido éxito).

Se considera que el Go es un juego más difícil que el ajedrez porque su árbol de búsqueda es mayor. Siendo b el número de movimientos legales en cada posición y d el número total de movimientos, el ajedrez tiene b ≈ 35 y d ≈ 80, mientras que el Go alcanza b ≈ 250 y d ≈ 150. El resultado es que un algoritmo de búsqueda sistemática con evaluación de la posición mediante heurísticos (como se suele usar en ajedrez) no es factible. La opinión de algunos expertos en inteligencia artificial (así lo afirma el artículo en Nature) es que faltaban unos diez años para que un programa venciera a un campeón humano.

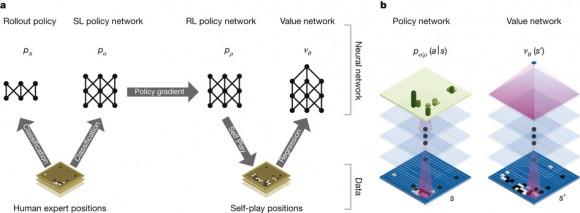

AlphaGo usa una red de neuronas artificiales con trece capas ocultas para evaluar los posibles movimientos. En el entrenamiento de la red se han usado tres fases. Una primera fase de aprendizaje supervisado (para que la red aprenda de partidas jugadas por humanos expertos). Se han usado 30 millones de posiciones del KGS Go Server, logrando que la red prediga el movimiento de los expertos un 57,0% de las veces (otros programas de Go no superan un 44,4%). Una segunda fase de aprendizaje con refuerzo (para que la red aprenda de partidas jugadas contra otros programas de Go). AlphaGo ha jugado contra el programa Pachi (el más fuerte hasta ahora, que evalúa mediante Montecarlo 100 000 posibilidades para cada movimiento) y ha vencido el 85% de las partidas (otros programas que usan aprendizaje supervisado solo logran vencer a Pachi un 12% de las partidas). Y una tercera fase, también de aprendizaje con refuerzo, en la que AlphaGo se ha enfrentado contra sí mismo (en 30 millones de movimientos).

Al final del entrenamiento la red es capaz de evaluar qué movimientos son más prometedores a la hora de ganar. Para recorrer el árbol de búsqueda se usa un algoritmo de Montecarlo (como en la mayoría de los programas que juegan al Go) que genera movimientos aleatorios siguiendo una distribución de probabilidad sesgada gracias a la evaluación que ofrece la red de neuronas artificiales (en lugar de un heurístico como otros programas que juegan al Go). La red generaliza los patrones aprendidos a la hora de evaluar nuevos movimientos. Su evaluación permite la poda del árbol de búsqueda (se descartan movimientos poco prometedores) y sesga la búsqueda en profundidad (se prefieren los movimientos mejor evaluados por la red).

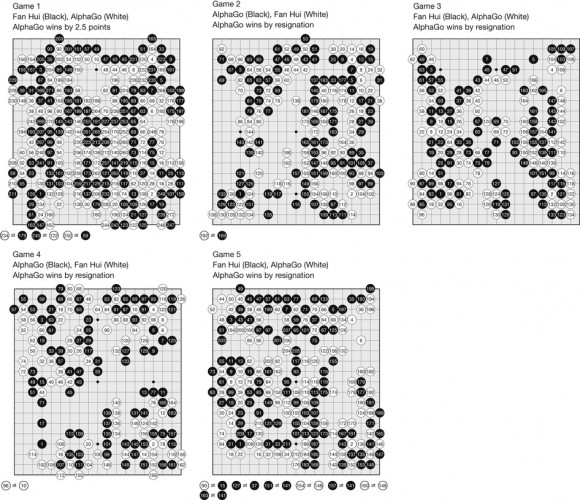

En el torneo contra Fan Hui se jugaron cinco partidas y en todas ganó AlphaGo. En la primera Hui cometió un error torpe (él afirma que de forma intencionada, para ver la fuerza del programa). Le sorprendió que AlphaGo no dudara y que le diera un palizón (le ganó por 2,5 puntos). En las siguientes partidas jugó lo mejor que pudo, tratando de no cometer ningún error. Para un humano es difícil evitar los errores. AlphaGo no comete errores (aunque juega sin estrategia, por pura fuerza bruta guiada por la red de neuronas artificiales). Las cuatro partidas siguientes se jugaron hasta que Hui sintió que había cometido un error, momento en que se rindió (abandonó porque estimó que AlphaGo acabaría ganándole). El resultado es que, por primera vez en la historia del Go, un programa ha sido capaz de vencer a todo un campeón europeo.

El editorial de Nature habla de «intuición digital» porque nadie sabe cómo funciona la «caja negra» de AlphaGo (cómo generaliza la red de neuronas artificiales). En mi opinión es excesivo clasificar de intuitivo el mecanismo de generalización de patrones de la red. El uso de redes de neuronas artificiales en algoritmos de aprendizaje con refuerzo es muy antiguo y nunca se ha hablado de que muestren ningún tipo de intuición. Afirmar que los algoritmos tipo «caja negra» funcionan pensando sin pensar («thinking without thinking» escribe el editor) me parece sensacionalista.

No podemos reconstruir los pasos seguidos por la red para generalizar los patrones que tiene almacenados porque la red busca un mínimo en un paisaje energético multidimensional muy complicado. Pero el algoritmo es perfectamente determinista y replicable. Cuando hablamos de intuición humana nunca pensamos en estos términos. En informática el concepto de intuición se describe mejor mediante el concepto de óraculo. Ni yo, ni los autores del artículo en Nature, nos atrevemos a afirmar que AlphaGo use la red de neuronas artificiales como oráculo para el algoritmo de Montecarlo (como sugiere el editor de Nature).

La versión de AlphaGo que ha vencido a Fan Hui usa 40 hebras de búsqueda, 48 CPU y 8 GPU (también se ha implementado una versión distribuida que usa 40 hebras de búsqueda, 1202 CPU y 176 GPU). El resultado es el programa de Go más fuerte en la actualidad capaz de ganar el 99,8% de las partidas que ha jugado contra otros programas de Go (en concreto, Crazy Stone, Zen, Pachi, Fuego y GnuGo, eso sí, limitando a cinco segundos el tiempo para cada movimiento). En concreto, ha ganado 494 de las 495 partidas jugadas.

El torneo contra Fan Hui, un jugador profesional de Go que ha sido campeón europeo en 2013, 2014 y 2015 se jugó entre el 5 y el 9 de octubre de 2015. AlphaGo ganó las cinco partidas a Fan Hui. La primera vez que un programa de Go logra vencer a un jugador profesional en un torneo. La prueba de fuego será en marzo de 2016, cuando AlphaGo se enfrente a Lee Sedol. Todo el mundo espera que el humano le dé un palizón, pero todo el mundo teme que se repita lo que pasó con Kasparov y que en un futuro torneo, una versión mejorada de AlphaGo, acabe venciéndole. Sólo el tiempo dirá que ocurre…

Daniel Dennett también se atreve:

https://youtu.be/beKC_7rlTuw?t=20m

En mi humilde opinión, la máquina y nosotros compartimos el uso de la fuerza bruta aunque no nos guste admitirlo; los dos visionamos jugadas futuras y descartamos o acogemos, pero la diferencia está en que nosotros tenemos más niveles de autorevisión, es decir, nosotros sabemos y podemos revisar el método que estamos usando, nosotros sabemos contra quien nos enfrentamos y qué métodos usa, y eso nos hace oráculos más perfectos, pero yo creo que la base es la misma, porque aunque diseñemos un plan, ese plan también sale a base de prueba y error mentales, también sale a fuerza bruta.

Permitidme que me explique con un ejemplo:

Estoy jugando contra la máquina y estoy perdiendo, entonces me digo, «..claro, estoy jugando a base de fuerza bruta, la máquina también, y como ve más niveles que yo, me está machacando».

Soy consciente de cómo estoy jugando y de cómo lo hace la máquina. Entonces decido cambiar de estrategia y me digo «Voy a engañarla, voy a hacer como si tuviera este plan, como el resultado más óptimo a corto plazo es éste, cuando vaya por ahí, la machaco con este conjunto de jugadas».

Independientemente de que este plan funcione o no, la pregunta es ¿cómo llego a esa estrategia? La respuesta es, nos guste o no, a base de fuerza bruta, también a base de construir modelos futuros e ir descartándolos.

En definitiva, lo que quiero decir, es que no le podemos negar a la máquina tener intuición, solo por el hecho de que no es capaz de revisar tantos niveles como nosotros. Tiene, si lo podemos decir así, mini intuición.

No todos los seres humanos juegan «a fuerza bruta» (es decir, según entiendo, sobre la base de cálculos y prospección de posiciones en el tablero). Kasparov sí lo hacía, y posiblemente mejor que nadie. Anticipaba posiciones y articulaba y desarticulaba soluciones tácticas. Karpov, en cambio, se guiaba por una percepción estética del tablero. Por eso se decía que, aunque sus enfrentamientos personales registraron un saldo favorable a Kasparov, posiblemente Karpov hubiera sido un rival más difícil de descifrar para Deep Blue.

En el caso del go (que lo he jugado un poco), la habilidad para percibir la estética y el equilibrio de las posiciones es mucho más determinante que en el ajedrez. Recuerdo haber visto una partida comentada por un gran maestro coreano. En el fuseki (la apertura), el gran maestro señaló un error. Dijo que una piedra debió ser ubicada en la intersección justo al lado de donde el jugador la puso. En efecto, más de 40 jugadas después, el jugador debió «enmendar» este error con una jugada que, de haber jugado como decía el GM, hubiera sido innecesaria. Con esto, perdió la iniciativa (jugaba con negras) y, por estrecho margen, el juego.

El GM no anticipó las siguientes más de 40 jugadas. Solo se guió por el reconocimiento de patrones en el tablero, por las posibles funciones de defensa y ataque que percibía y un sentido del equilibrio que posiblemente no hubiera podido explicar en términos racionales. Y, no obstante, su observación fue precisa y acertada.

Joaquín en el ajedrez pasa lo mismo. Hoy en día todo el mundo anota las partidas usando programas de ordenador para calificar los movimientos (!, !!, ?, ??, ?!, etc.) y hay pocas diferencias entre los analistas de partidas; sin embargo, hace años dicha calificación era mucho más subjetiva (primaba la intuición y la belleza estratégica) y había grandes diferencias entre analistas. No conozco en detalle el Go, pero supongo que pasará algo similar.

La verdad que el día que se demuestre, en el ajedrez, que las blancas, siempre ganan, se habrá perdido la magia.

La magia es desconocimiento.

Por cierto, os recomiendo el tercer tomo de «Matemática en el tablero de Ajedrez» de Ye Yá Guik

Es impresionante como muchas de las decisiones de las máquinas en determinadas jugadas de ajedrez, pareciendo auténticos disparates para la intuición humana, sorprenden enormemente por su brutal efectividad a largo plazo. No molamos tanto como nos creemos.

Esta demostrado por técnicas de RM funcional que las personas tomamos decisiones antes de hacerlas conscientes. Quizá sea sensacionalista pero yo si veo paralelismos. Lo que diferencia al hombre de la máquina es que está no necesita»hacer consciente» una jugada, simplemente la ejecuta.

Es curioso que no entendamos aún como funciona la toma de decisiones en el cerebro humano y aún habiendo diseñado nosotros los algoritmos y hardware de inteligencia artificial se nos haya escapado como funcionan estos programas.

Yo creo Oscar, que para ejecutar una jugada, es necesario tener cierta conciencia, es decir, si por ejemplo llega una jugada que la red neuronal aprendió, el hecho de que salten unos algoritmos en vez de otros, para mí, eso es ser consciente de que la jugada se conoce, otra cosa distinta es que la máquina sea consciente de lo que ello significa, que es muy distinto, lo cual, para mí, no es más que otro nivel del autorevisión del que carece. Y desde mi punto de vista, carece de importancia que sea 100% predecible o no, tal como comentas, a nosotros también nos podrían predecir lo que vamos a hacer unos segundos antes, tal como comentas.

No estoy de acuerdo con algún comentario, y me explico.

No, el cerebro humano no funciona a base de «fuerza bruta» sin que lo sepamos. El cerebro humano no aplica para la resolución de problemas la búsqueda sistemática, de hecho cualquier calculo ligeramente complejo ya se nos atraganta, y hace que tengamos de descomponerlo en pasos y resolverlo de forma pausada. El pretender que internamente sabemos resolver millones de problemas sin darnos cuenta, y que en cambio somos incapaces de hacerlo conscientemente no tiene mucho sentido.

En cambio si que vemos patrones, algo que hace hasta cierto punto esta técnica de «caja negra». En muchas ocasiones personas acostumbradas a realizar un determinado tipo de cálculos, pueden saber si un resultado «parece» correcto o no. No es que calculemos inconscientemente el resultado como un «genio tonto», sino que en base a la experiencia que tenemos sobre las entradas y salidas de un problema, reconocemos un patrón en las mismas y vemos como correcto o incorrecto, o al menos «no lo parece» dependiendo de su posición en ese patrón.

El cerebro humano no ha necesitado a lo largo de su evolución el tener que hacer frente a complejos cálculos numéricos para su supervivencia, pero si al reconocimiento de patrones, algo que además está muy extendido en la naturaleza. Cuestión diferente es que seamos conscientes de que estamos usándolos en un momento dado.

Sobre la consciencia de una máquina, esta no creo que se encuentre en su capacidad de cálculo, ni en su capacidad de reconocimiento de patrones. Lo cierto es que no sabemos exactamente que es la consciencia pero posiblemente sea una suma de muchas partes pequeñas que por si mismas no la producen, del mismo modo que una lente de cámara es mas que la suma de cada una de las lentes que la componen, influyendo además las relaciones entre ellas.

Incluso tengo dudas de que lo que llamamos «conciencia» sea aplicable a un computador tal y como lo concebimos actualmente, lo mismo que «inteligencia». Son atributos que asignamos a algunas especies relativamente cercanas entre si. Es posible que esos atributos tengan su equivalente de alguna forma en una forma suficientemente compleja de ordenador de algún tipo, pero dudo que sean iguales.

Estoy de acuerdo contigo, Orbatos, efectivamente el cerebro no se dedica exclusivamente a la búsqueda sistemática, de echo, si fuera así, no podríamos hacer nada de lo que hacemos, y de hecho es lo que se intenta evitar en AlphaGo mediante aprendizaje, técnicas de Montecarlo…etc.

Hacemos muchísimos «cálculos internos» (entiéndeme, no explícitamente numéricos; la aritmetización es un invento nuestro práctico) y tomamos muchas decisiones sin revisión alguna, gracias a años de selección natural, circuitería que se va formando con nuestra experiencia…etc

Lo que quiero expresar es que no somos muy distintos a groso modo de las máquinas que vamos haciendo; y de nuevo reitero respecto a nuestros sofisticados planes, por ejemplo, el método de resolución de divide y vencerás nace en el momento en que alguien hace internamente una modelización de la realidad, es decir, se imagina cómo podría funcionar en la realidad, lo prueba y acierta.

El «imaginar como funciona» la realidad es un reconocimiento de un patrón.

Todos los seres vivos reconocen patrones. La neotenia sin ir mas lejos es un patrón presente en muchas especies. Los patrones de «aviso» de peligro en muchas especies siguen pautas similares, incluyendo falsificaciones de las mismas. Los patrones son los que ayudan a las especies a distinguirse entre ellas para socializar, buscar pareja, etc. Cuando lanzamos una piedra no calculamos la parábola de la misma, pero observando una parte de la misma somos capaces de predecir donde caerá, pero solo cuando hemos «practicado» muchas veces. Vemos muchas parábolas y extrapolamos un resultado final. Un arquero medieval podía no saber leer ni escribir, y apenas operar mas allá de contar con los dedos, pero su reconocimiento de los patrones de esas parábolas lo convertía en un arma mortal. Ejemplos hay muchos.

Sobre consciencia o inteligencia «artificial» sigo pensando que hay muchas diferencias entre los seres que conocemos, y un programa de ordenador. No ya a niveles de que unos se basen en neuronas orgánicas y otros en redes y circuitos, sino al hecho de que unos experimentan esa realidad a través de una serie de sentidos y experiencias, mientras que lo que pretendemos crear como una «inteligencia artificial» es básicamente «una caja que habla». Hablamos de unas diferencias tan enormes que no se hasta que punto se podría dar una equivalencia entre unas y otras.

Sabemos por ejemplo que algunos cetáceos tienen un nivel de encefalizacion tan elevado o mas que el hombre, y se nos da la paradoja que mientras que con chimpancés u otros símios, que son primos nuestros y con quienes compartimos incluso ecosistema podemos «entendernos» con las obvias limitaciones de la diferencia en niveles de inteligencia. En cambio con un delfín por ejemplo, hablamos de un ser que vive en un medio diferente, con sentidos que desconocemos y que se nos antoja en general mas complicado. ¿Es mas inteligente un chimpancé que un delfín? ¿como medimos eso si nuestra propia medida de lo que conocemos como inteligencia se basa en nuestro baremo?

Juzgamos la inteligencia de otras especies comparándola con la nuestra. Eso es obvio, con algo debemos de empezar y con algo debemos de compararla. No obstante no se hasta que punto podremos reconocer como inteligencia o incluso «consciencia» algo completamente diferente a nuestra experiencia.

La comparación que haces entre el contexto del delfín y el chimpancé es muy buena; es igual cuando imaginamos como sería encontrarnos con unos extraterrestres que manejaran otros constructos de la realidad.

Imaginemos que en el futuro pudiéramos hablar con nuestro ordenador y se comportara como si tuviera conciencia, pero para ello utilizara la nube y partes de un software centralizado, si bien, gracias a la interacción contigo y el software en él, adquiriera su propia personalidad ¿donde estaría ubicada su conciencia? Ciertamente la conciencia es una idealizacion que hacemos, algo que emana de nosotros.

¿Es mi pc el mismo cuando le desinstalo e instalo otros programas? ¿soy yo el mismo cuando mueren y aparecen otras neuronas?

Sugiero que se dedique una entrada sobre el ajedrez cuantico

SeñorX, supongo que tu sugerencia viene a colación de Chris Matyszczyk, «Watch Paul Rudd beat Stephen Hawking at quantum chess,» CNET, 28 Jan 2016, y del vídeo de youtube entre Hawking y Rudd.

Lo que queda claro con este nuevo hito es que nos estamos acercando paso a paso a la creación artificial de eso que llamamos inteligencia, cuyo máximo exponente es el cerebro humano.

Y resulta muy prometedor que la simple implementación de hardware que imita la arquitectura neural devuelva progresos significativos. Tal vez estamos mucho más cerca de la inteligencia artificial de lo que imaginamos y solo sea cuestión de dar con la estructura adecuada, en lugar de comprender y reproducir, al viejo estilo, el software del pensamiento humano .

Saludos.

Estas discusiones siempre se alejan de un punto fundamental: ¿Quien ganó REALMENTE al jugador humano? ¿La maquina o las decenas de programadores, ingenieros y estudiosos del juego que sintetizaron la información de siglos de juegos, de experiencia, de creatividad humana? ¿La maquina generó su voluntad de aprender, de ganar, de competir? ¿O es la voluntad de todo ese grupo humano usando sus intelectos coordinados y herramientas de todo tipo para vencer a UN jugador de muy alto nivel, a los mejores de toda la humanidad? Por otro lado rescato esta frase de Francis:»El uso de redes de neuronas artificiales en algoritmos de aprendizaje con refuerzo es muy antiguo y nunca se ha hablado de que muestren ningún tipo de intuición. Afirmar que los algoritmos tipo “caja negra” funcionan pensando sin pensar (“thinking without thinking” escribe el editor) me parece sensacionalista.»

Jorge, actualmente cualquier PC, con el programa adecuado, gana a un campeón del mundo. Dime, ¿quien gana entonces, el que ha hecho el pc o el que ha hecho el software?

Gana el PC, gana la máquina. Y evidentemente tener voluntad de aprender o no, no implica nada. Una máquina con el objetivo de ganar no es consciente de que tiene ese objetivo, solo por eso dudaría si adjudicarle la la voluntad de ganar…pero solo por eso.

Y ahora una pregunta abierta ¿cuantas veces se equivoca la intuición?, ¿cuantas veces el experto comentarista de Go a base de bella intuición mete la gamba? Muchísimas veces más de las que acierta.

Ideaca:

Cuando queremos encestar una bola de papel en la papelera, de forma inconsciente recreamos un modelo de la realidad, el cual, nos da como resultado la fuerza aproximada que debemos utilizar en el lanzamiento (a más experiencia, mejor modelo y mejor resultado).

Así como hacemos modelos de la realidad externa de forma inconsciente, también hacemos modelos de nosotros mismos de forma inconsciente, y esto es lo que entendemos por conciencia, es decir, los diversos modelos de nosotros mismos que emergen inconscientemente es lo que nos produce lo que llamamos conciencia, pues nuestro modelo también hace modelos de la realidad externa; y esto es lo que llamamos ser conscientes de nosotros mismos y del exterior.

La ventaja evolutiva de realizar modelos de nosotros mismos es que muchas decisiones se paran, inconscientemente, al tener nuevos inputs, gracias a estos modelos, y por eso somos tan buenos prediciendo las cosas.

Gracias por los aplausos que sin duda, me estaréis profiriendo desde vuestros teclados. 😉 🙂

Pedro, en mi opinión has dado en el clavo. Existen fuertes indicios de que nuestro cerebro actúa como un «simulador». Un movimiento de evasión de un depredador, por ejemplo, requiere sincronizar hasta 600 músculos del cuerpo con una intensidad concreta y un orden concreto. Esta tarea complejísima se puede realizar con éxito si el cerebro simula la escena con todos los «inputs» que recibe de los sentidos: distancia del depredador, velocidad, posición de los objetos, etc y efectúa los «outputs» de la forma más optima con los valores obtenidos de la simulación. Es evidente que la selección natural favorecería a los individuos con un mejor simulador lo que conllevaría un aumento del cerebro y de las capacidades mentales. El simulador realiza «inferencias bayesianas»(otra vez las matemáticas) y mejora con la experiencia. En el tenis, el fútbol o los dardos ganan los que tienen el mejor simulador o el que lo tiene mejor entrenado. Nosotros utilizaríamos el simulador para tomar todas nuestras decisiones. Esta hipótesis ya se está estudiando y existen ciertos experimentos para tratar de comprobarla. Los sueños serían otra consecuencia del simulador. En mi página escribí un artículo sobre esto si te interesa. ¿Quien decía que la ciencia nunca podría explicar la mente humana?

La inteligencia se basa en dos capacidades: Simular el devenir del mundo real durante un lapso de tiempo más o menos largo e imaginar qué cambios habría que introducir en esa simulación para alcanzar ciertos objetivos predeterminados.

En el ámbito del ajedrez, por ejemplo, podríamos imaginar un simulador de ajedrez que puede «visualizar» la evolución futura d el tablero en función de las jugadas posibles. Pero además se requiere la capacidad de intervenir en el tablero, respetando las leyes vigentes, para alcanzar un objetivo predeterminado (eliminar al rey enemigo).

En una IA nosotros deberíamos reservarnos la opción de establecer los objetivos, dejando a la máquina el trabajo de idear la forma de conseguirlos. Si le transfiririeramos también la capacidad de fijar objetivos, tal vez correríamos un grave riesgo.

Saludos.

El que crea que una mente artificial es una especie de «calculadora con más potencia» no entiende nada. Las calculadoras de bolsillo hacen operaciones que no podría hacer ningún humano, y sin embargo una lombriz tiene más «consciencia» que una calculadora. La calculadora, de hecho, tiene cero consciencia. La consciencia no tiene nada que ver con movimientos de evasión, que son automáticos, ni con lanzar cosas, que también puede enseñarse a una máquina, ni con cálculos mentales, porque Einstein no tenía más ni menos consciencia que un albañil, dicho sea con todo el respeto. La consciencia tiene que ver con los órganos de los sentidos, con las emociones, con la disposición de los tres cerebros: reptiliano, mamífero y primate, con los centros del lenguaje y con los neurotransmisores, y en todo caso se podrá imitar de forma artificial con electrónica la biología molecualr y la bioquímica de la mente, lo no que creo es que funcione igual. Saldrá otra cosa, que a lo mejor podemos llamar paraconsciencia o pseudoconciencia.

Creo que la cuestión principal no es la conciencia, ya que podríamos decir que una cámara fotográfica es consciente, puesto que es el lugar en donde se forma una imagen de la realidad, siendo esta imagen independiente de si hay alguien o no que la vea. La cuestión es la auto-consciencia que es un fenómeno ligado al lenguaje. Sólo el ser humano tiene lenguaje. Pero creo que se exagera la cuestión de la importancia del cerebro, puesto que el gran secreto está en otro nivel, puesto que para que ocurriese el TOTALMENTE ANORMAL hecho de nuestra presencia en el mundo debió ocurrir algún acontecimiento no ligado al orden denominado «natural» tal como lo conocemos. Una máquina será autoconsciente y podrá hablar, es decir dialogar, cuando le falte algo, sin embargo si se logra producir tal cosa será sin duda un monstruo, un apéndice bastardo de un deseo muerto, como todo lo que produce nuestro querido sistema socio-político-científico-financiero. Estimados amigos, todo tiene un costo, y la IA no es la excepción, como tampoco lo es el progreso científico que se PAGA con MUERTE Y DESTRUCCIÓN. Mi propuesta es asumir el conocimiento como una tarea esencialmente finita y abandonar la construcción de la torre de Babel, dejándola en ruinas.

Y Marzo llegó, el Dan 9 cayó (4 a1), fin de la cita.

quimica – -matematica

«fisica»

=

» diversion»