He participado en el episodio 449 del podcast Coffee Break: Señal y Ruido [Acast A, Acast B; iVoox A, iVoox B; iTunes A y iTunes B], titulado “Ep449: Ingenuity; NASA; DOOM; Higgs; Entrelazamiento de Quarks; Agujeros Negros», 01 feb 2024. «La tertulia semanal en la que repasamos las últimas noticias de la actualidad científica. En el episodio de hoy: Cara A: Eskirmiones para modelar estrellas de neutrones (tesis doctoral de Miguel Huidobro) (5:00). Finaliza la misión de Ingenuity tras 72 vuelos en Marte (12:00). NIAC financia el startup de 13 nuevos conceptos (31:00). Una estudiante del MIT estudia una “pantalla de bacterias” para correr Doom (43:00). Cara B: ATLAS y CMS estudian la desintegración del bosón de Higgs en un bosón Z y un fotón (00:05). Cociente de masas de agujero negro central a masa total para galaxias a z>4 (24:02). Evolución dinámica de la masa relativa de agujeros negros supermasivos y la masa de la galaxia anfitriona a redshift z=2 (43:22). La evaporación de agujeros negros primordiales podría mantener las nubes de H calientes y permitir las semillas tempranas de SMBHs (48:22). Entrelazamiento cuántico entre quarks en chorros hadrónicos (58:22). Señales de los oyentes (1:22:22). Imagen de portada realizada por Héctor Socas. Todos los comentarios vertidos durante la tertulia representan únicamente la opinión de quien los hace… y a veces ni eso».

¿Quieres patrocinar nuestro podcast como mecenas? «Coffee Break: Señal y Ruido es la tertulia semanal en la que nos leemos los papers para que usted no tenga que hacerlo. Sírvete un café y acompáñanos en nuestra tertulia». Si quieres ser mecenas de nuestro podcast, puedes invitarnos a un café al mes, un desayuno con café y tostada al mes, o a un almuerzo completo, con su primer plato, segundo plato, café y postre… todo sano, eso sí. Si quieres ser mecenas de nuestro podcast visita nuestro Patreon (https://www.patreon.com/user?u=93496937); ya sois 155, muchas gracias a todas las personas que nos apoyan. Recuerda, el mecenazgo nos permitirá hacer locuras cientófilas. Si disfrutas de nuestro podcast y te apetece contribuir… ¡Muchísimas gracias!

Descargar el episodio 449 cara A en Acast.

Descargar el episodio 449 cara B en Acast.

Como muestra el vídeo participamos por videoconferencia Héctor Socas Navarro @HSocasNavarro (@pCoffeeBreak), José Edelstein @JoseEdelstein, Gastón Giribet @GastonGiribet (solo cara B) y Francis Villatoro @emulenews.

Tras la presentación de Héctor, comento en breves mi paso por Santiago de Compostela la semana pasada. Intervine como presidente del tribunal de tesis doctoral de Miguel Huidobro García (en el centro en la foto), «Skyrme Neutron Stars» (la tesis aún no está en Minerva de la USC), supervisada por Christoph Adam (a la derecha en la foto). La idea es usar los solitones topológicos (skyrmions) del modelo de Skyrme para describir la materia nuclear en las estrellas de neutrones. La carga conservada de estos solitones es el número bariónico (número de nucleones). En concreto, se usan los skyrmiones periódicos, que describen cristales de Skyrme, para determinar la ecuación de estado de la materia del núcleo de la estrella de neutrones (cuyo número bariónico B ∼ 10⁵⁷); se describen tanto el núcleo interior (∼5–10 km), como el núcleo exterior (∼2–5 km), pero no la pasta nuclear de la corteza interior (∼1 km), la corteza exterior (∼10–100 m) y la atmósfera (∼0.1–10 cm). La ecuación de estado (EOS) es la relación entre la presión p y la densidad ρ, que se obtienen a partir de la densidad de energía (ρ=E/V, p=−dE/dV). En la tesis se usa el modelo de Skyrme completo con simetría SU(2) y lagrangiano ℒ₀₂₄₆ (que incluye el término se sexto orden ℒ₆). Las novedades de la tesis son la inclusión de efectos cuánticos, la condensación de kaones y los mesones rho. Sin lugar a dudas es fascinante que un modelo tan simplificado como el de Skyrme describa bien las propiedades de estas estrellas. Las futuras observaciones multimensajero de fusiones de estrellas de neutrones (como GW170817) permitirán ajustar los parámetros efectivos del modelo (como el módulo de compresión, el módulo cuadripolar o la deformabilidad de marea).

Nos cuenta Héctor que ha finalizado la misión de Ingenuity, tras 72 vuelos en Marte. Recomiendo leer al genial Daniel Marín, «Finaliza la misión de Ingenuity tras 72 vuelos en Marte», Eureka, 27 ene 2024. «Iba a realizar cinco vuelos de demostración tecnológica. Ingenuity ha efectuado 72 vuelos, recorriendo un total de 17 kilómetros; ha permanecido en el aire un total de 128.8 minutos (más de dos horas en sus 72 vuelos), alcanzado una altura máxima de 24 metros y velocidad máxima de 36 km/h. Pero nunca se alejó más de un kilómetro de Perseverance para mantener las comunicaciones con el rover. Sobrevivir tanto tiempo en Marte es un éxito tremendo.

Gracias al éxito de Ingenuity, la NASA ha decidido incluir dos helicópteros en la próxima sonda del programa MSR (Mars Sample Return) para traer muestras de Marte a la Tierra. Estos helicópteros, los SRH (Sample Recovery Helicopter), llevarán un brazo robot y ruedas con el fin de recoger muestras dejadas por Perseverance y llevarlas hasta la sonda SRL (Sample Retrieval Lander) para luego enviarlas a la órbita marciana y, de allí, a la Tierra. Sin la experiencia de Ingenuity, nadie se habría planteado incluir helicópteros en estas misiones».

Nos cuenta Héctor que el programa NIAC de la NASA financiará el startup de 13 nuevos conceptos tecnológicos. El programa NIAC (Conceptos Avanzados Innovadores de la NASA) premia con unos 175 mil dólares (un «dinero semilla») a proyectos tecnológicos espaciales innovadores (todos ellos en fase muy primitiva). Estos proyectos serán claves para futuras misiones a Venus, Marte y mundos más allá de nuestro Sistema Solar. El helicóptero Ingenuity nació como un proyecto NIAC. Ahora se han premiado sensores cuánticos para observar la atmósfera de la Tierra, la coordinación de un enjambre de naves espaciales que se dirigirán a estrella más próxima, cómo traer muestras desde la superficie de Venus, o incluso un avión (MAGGIE, por Mars Aerial and Ground Global Intelligent Explorer) para explorar Marte. Más información en Samantha Mathewson, «NASA funds Venus sample-return, interstellar probes and other far-out space tech,» Space.com, 09 Jan 2024; el listado de proyectos premiados con enlaces a más información se puede disfrutar en Loura Hall, «NIAC 2024 Selections,» NASA, 04 Jan 2024.

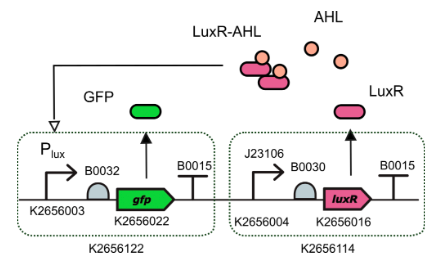

Nos cuenta Héctor una fascinante curiosidad: una estudiante del MIT, Lauren (Ren) Ramlan, está desarrollando una “pantalla de bacterias” donde se puede jugar al juego Doom (1993). La idea de las pantallas de bacterias es antigua y el marco del proyecto iGEM del MIT hay varias propuestas. Una de ellas (una bioparte formada por bioladrillos) es la que ha seleccionado Ren Ramlan para fabricar un pantalla monocroma, con un bit por píxel. El proyecto se enmarca en la asignatura de biología sintética 20.405 Principles of Synthetic Biology (por cierto, ya impartí una asignatura de libre configuración de biología sintética en la Universidad de Málaga llamada «Bioingeniería» en el curso 2010/2011 dirigida a estudiantes de Informática). El trabajo de Ramlan se enmarca en el conepto DROE (Doom ejecutándose en todo), desde cajeros automáticos, calculadoras, ladrillos lego, patatas y pruebas de embarazo. Todos deseamos que tenga éxito. Más información de su proyecto en Ren Ramlan, «1-Bit Pixels Encoded in E. Coli for the Display of Interactive Digital Media,» Google Docs, 2024.

El problema de su propuesta (que al fin y al cabo solo es un trabajo para una asignatura de un curso de doctorado) es la enorme lentitud de la respuesta de la proteína verde fosforescente (GFP) que se propone usar. Para que se encienda el píxel se necesitan unos 70 minutos y para que se apague 8 horas y 20 minutos. La tasa de fotogramas típica del juego Doom, 35 fotogramas por segundo, y la duración típica de un juego, unas 5 horas, implican que se necesitan unos 599 años para jugar una partida de Doom con la tecnología propuesta. Comento que hay proteínas GFP mucho más rápidas que la usada por Ren; creo razonable que se pueda lograr sin problemas una tasa de fotogramas de uno por minuto. Aún así, jugar al Doom con estas pantallas celulares debe ser lo más aburrido que se pueda concebir.

Me toca comentar la publicación en Physical Review Letters del resultado combinado de ATLAS y CMS del LHC sobre la desintegración del bosón de Higgs en un bosón Z y un fotón. Se han analizado los datos del LHC Run 2 en los detectores ATLAS y CMS (unos 140 fb⁻¹ de colisiones a 13 TeV en cada detector entre 2015 y 2018). Se ha observado dicha desintegración con 3.4 sigmas (desviaciones estándares); para lograr las 5 sigmas se necesitarán los datos del LHC Run 3 en curso. La señal observada es dos veces más fuerte de lo predicho por el modelo estándar, 2.2 ± 0.7 veces mayor; pero el resultado aparenta ser una fluctuación estadística pues se encuentra a 1.9 sigmas (desviaciones estándares) de la predicción teórica.

Como la desintegración en un bosón Z y un fotón requiere un lazo de partículas de gran masa (tres quarks top, tres bosones W o dos bosones W), podría estar modificado por partículas masivas de mayor masa aún no descubiertas. De ahí en el interés del estudio de precisión de este tipo de desintegraciones. Pero, cuidado, un exceso de solo 1.9 sigmas (un valor p de 0.06) no debe ser malinterpretado (Sabine Hossenfelder cayó en ello en Twitter y tuvo que borrar su tuit). La señal observada a 3.4 sigmas (en teoría debería observarse a 1.6 sigmas) es combinación de las 2.2 sigmas (en teoría 1.2 sigmas) de ATLAS y las 2.6 sigmas (en teoría 1.1 sigmas) de CMS. En mi opinión, este tipo de excesos son habituales (cuando no los hay nadie publica que «no se han observado indicios» de algo, que solo se publican cuando hay un exceso) y (casi) siempre tienden a desaparecer. Así que en este caso, los datos del LHC Run 3 no mostrarán dicho exceso (pero la esperanza de muchos físicos teóricos es que ocurra lo contrario y esta sea la primera señal de nueva física).

El artículo es ATLAS Collaboration, CMS Collaboration, «Evidence for the Higgs Boson Decay to a Z Boson and a Photon at the LHC,» Phys. Rev. Lett. 132: 021803 (11 Jan 2024), doi: https://doi.org/10.1103/PhysRevLett.132.021803; más información divulgativa en Nikhil Karthik, «Measurements of Rare Higgs Decay May Disagree with Predictions,» Physics 17: s4 (11 Jan 2024•), https://physics.aps.org/articles/v17/s4; David Appell, «Rare decay of the Higgs boson may point to physics beyond the Standard Model,» Phys.org, 25 Jan 2024.

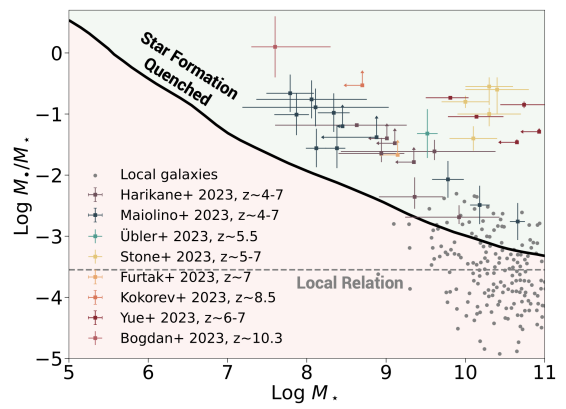

Gastón nos cuenta un artículo de Avi Loeb sobre el cociente entre las masas del agujero negro supermasivo (M) y la masa estelar (M⋆) de una galaxias en función del desplazamiento al rojo. El artículo ofrece unas cuentas de servilleta que sugieren una relación entre ambos válida para z>4, en concreto, M/M⋆ ∝ (1+z)5/2; hay que comparar este resultado con el cociente actual, la relación lineal M/M⋆ ∝ (1+z). La idea es que un agujero negro supermasivo (SMBH) activo, con un chorro, incrementa la temperatura del gas en el bulbo galáctico, lo que impide la formación de estrellas (quenching). Cuando el SMBH pasa a una fase inactiva se incrementa la actividad estelar. El artículo es Fabio Pacucci, Abraham Loeb, «The Redshift Evolution of the M∙−M⋆ Relation for JWST’s Supermassive Black Holes at z>4,» Submitted to The Astrophysical Journal Letters, arXiv:2401.04159 [astro-ph.GA] (08 Jan 2024), doi: https://doi.org/10.48550/arXiv.2401.04159.

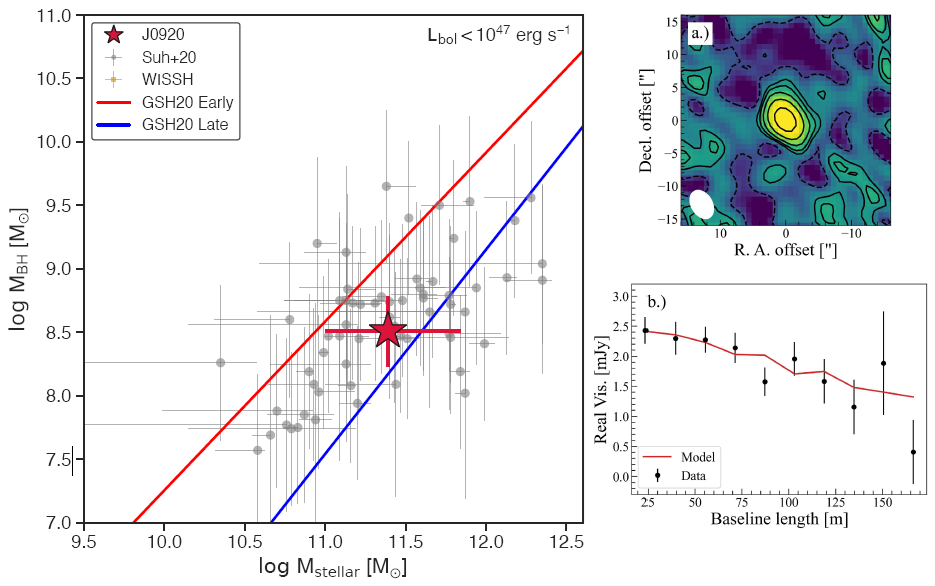

Nos comenta Gastón que se publica en Nature la relación entre la masa de un agujero negro supermasivo y la masa de su galaxia anfitriona a z=2 (lo vemos como era hace once mil millones de años). Esta información es relevante para el estudio de los mecanismos de regulación por realimentación entre la acreción de materia en un agujero negro activo en su fase de cuásar y la formación estelar en dicha galaxia. Se ha detectado un desplazamiento espacial de 40 microsegundos de arco (0.31 pc) entre los fotocentros rojo y azul de la línea Hα, lo que permite trazar el gradiente de velocidad en dicha región. Los espectros obtenidos permiten estimar que el agujero negro tiene una masa de 3.2 × 10⁸ (320 millones de) masas solares y su galaxia anfitriona de 6 × 10¹¹ masas solares. Lo más curioso es que se interpreta el resultado como un agujero negro supermasivo acretando materia a un ritmo super-Eddington (superior al límite clásico de Eddington). La relevancia de este trabajo es que se interpreta que la galaxia anfitriona creció más rápido que el agujero negro supermasivo. Si se confirma, sería la primera vez que se observa un retraso entre la formación de galaxias y agujeros negros supermasivos. El artículo es R. Abuter, F. Allouche, …, G. Zins, «A dynamical measure of the black hole mass in a quasar 11 billion years ago,» Nature (29 Jan 2024), doi: https://doi.org/10.1038/s41586-024-07053-4.

Y Gastón también nos cuenta un artículo sobre las semillas de los agujeros negros supermasivos: sobre las que pudo influir la evaporación de agujeros negros primordiales. Se intenta explicar la formación de estas semillas antes de lo esperado según los modelos de su origen por colapso estelar y de su crecimiento posterior por acreción de materia. El modelo alternativo es el colapso directo de las nubes de gas libres de metales; pero dicho proceso requiere que el gas esté caliente, para evitar que dé lugar a estrellas (que serían de población III). El nuevo artículo en arXiv estudia el rol de la evaporación de Hawking de agujeros negros primordiales de masa muy pequeña (menores que la masa de un asteroide); su evaporación mantiene caliente el gas impidiendo que se forme hidrógeno molecular. Así se evita que se fragmente la nube de gas y se enfríe para formar estrellas. Por supuesto, hasta que no se confirme de forma independiente, debemos considerar como especulativa esta propuesta sobre el efecto de la radiación de Hawking en la formación de las semillas de los SMBH.

Y Gastón también nos cuenta un artículo sobre las semillas de los agujeros negros supermasivos: sobre las que pudo influir la evaporación de agujeros negros primordiales. Se intenta explicar la formación de estas semillas antes de lo esperado según los modelos de su origen por colapso estelar y de su crecimiento posterior por acreción de materia. El modelo alternativo es el colapso directo de las nubes de gas libres de metales; pero dicho proceso requiere que el gas esté caliente, para evitar que dé lugar a estrellas (que serían de población III). El nuevo artículo en arXiv estudia el rol de la evaporación de Hawking de agujeros negros primordiales de masa muy pequeña (menores que la masa de un asteroide); su evaporación mantiene caliente el gas impidiendo que se forme hidrógeno molecular. Así se evita que se fragmente la nube de gas y se enfríe para formar estrellas. Por supuesto, hasta que no se confirme de forma independiente, debemos considerar como especulativa esta propuesta sobre el efecto de la radiación de Hawking en la formación de las semillas de los SMBH.

Lo más llamativo del artículo es su título «alimentando a las ballenas con plancton». Héctor destaca que se refiere a que los agujeros negros primordiales más pequeños permiten la formación de las semillas de los agujeros negros más supermasivos. El artículo es Yifan Lu, Zachary S. C. Picker, Alexander Kusenko, «Feeding plankton to whales: high-redshift supermassive black holes from tiny black hole explosions,» arXiv:2312.15062 [astro-ph.GA] (22 Dec 2023), doi: https://doi.org/10.48550/arXiv.2312.15062.

Me toca comentar que se han publicado simulaciones del entrelazamiento cuántico entre quarks en chorros hadrónicos. Bueno, en realidad, la noticia tiene truco, pero vayamos por partes. Los chorros hadrónicos están formados por bariones y mesones producto de la desintegración mediante hadronización de quarks, antiquarks y gluones. Estos chorros se propagan en el vacío cuántico de los campos de estas partículas, así que modifican dicho vacío. Así se producen fenómenos como el entrelazamiento chorros se propaguen a través del vacío cuántico confinado, modificarán dicho vacío produciendo pares quark-antiquark. Dichos pares estarán entrelazados, con lo que los chorros podrían usarse para observar dicho entrelazamiento. Todavía estamos muy lejos de poder observar este fenómeno en las colisiones del LHC. Tampoco podemos observar dicho fenómeno en simulaciones de la QCD en 3+1 dimensiones. Se publica en Physical Review Letters la simulación para la QED en 1+1 dimensiones (esta versión de la QED también presenta un confinamiento similar al que en la QCD da lugar a la hadronización). No es lo mismo que la simulación del entrelazamiento cuántico entre quarks en chorros hadrónicos, pero es un primer paso en un largo camino hacia dicho hito.

La simulación cuántica de la QED en 1+1 dimensiones no es trivial (los investigadores del BNL han usado GPUs de NVIDIA). Como es obvio, se trata de un modelo de juguete, pero se observan correlaciones similares a las intuidas (aunque aún no observadas) en los colisionadores de partículas. Se espera que este tipo de simulaciones ayuden a determinar con precisión las señales que podamos esperar en los colisionadores. En concreto, entre los fragmentos de los chorros hadrónicos para pseudorrapideces Δη≤2. Además, sin llegar tan lejos, aún quedan varios fenómenos interesantes por estudiar, como la termalización resultado de las correlaciones observadas. Estas simulaciones en supercomputadores son muy costosas, pero nos ayudan a entender mejor la física cuántica de estos fenómenos. Por supuesto, en un futuro lejano, gracias a los ordenadores cuánticas se podrán realizar estas simulaciones de forma eficiente. El artículo es Adrien Florio, David Frenklakh, …, Kwangmin Yu, «Real-Time Nonperturbative Dynamics of Jet Production in Schwinger Model: Quantum Entanglement and Vacuum Modification,» Phys. Rev. Lett. 131: 021902 (13 Jul 2023), doi: https://doi.org/10.1103/PhysRevLett.131.021902; he rescatado este artículo al hilo de la pieza de César Tomé, «Quantum entanglement among quarks,» Mapping Ignorance, 30 Jan 2024.

Y pasamos a Señales de los Oyentes. Cristina Hernández García comenta: «El Doom parece que tenía líneas de código para [simuular operaciones en] coma flotante, ya que antes estos coprocesadores [eran muy] caros». Contesta Héctor que en aquella época dominaba el mercado el procesador (CPU) 8086, que en algunas máquinas iba acompañado del coprocesador de coma flotante (FPU) 8087. Por ello, en muchos juegos se simulaba (de forma aproximada) la aritmética flotante usando la CPU (años más tarde se incluyó la FPU dentro de la CPU y este tipo de simulaciones quedaron en el recuerdo).

P pregunta: «¿[Para] los agujeros negros esa más sencillo acretar [durante el universo temprano] en un estado caliente y denso que [durante el universo futuro]en un estado de muerte térmica?» Contesta Gastón que, en rigor, no lo sabemos. En el plasma primordial, caliente y denso, la tasa de acreción depende del (des)equilibrio entre la evaporación de Hawking y la acreción de materia disponible.

77sharprash77 pregunta: «¿Existen «observadores» o puntos en el universo para los cuales el tiempo no transcurre? ¿Como por ejemplo un fotón? ¿El vacío físico (o absoluto si existiese)? ¿Cuales más hay?» Gastón contesta que el paso del tiempo siempre se mide gracias a un observador; el ritmo del tiempo es relativo a dicho observador. Pone el ejemplo del horizonte de sucesos, donde el tiempo parece detenerse para un observador lejano, pero no se ve afectado para un observador local. Héctor apostilla que siempre hay que hablar de tiempo entre eventos. Gastón lo reafirma y pone un sencillo ejemplo sobre simultaneidad en relatividad especial.

Yo hubiera contestado lo siguiente. (1) No existen observadores para los que el tiempo no transcurre, por definición de observador. (2) Un fotón no es un observador. (3) El vacío tampoco es un observador. (4) No hay observadores para los que el tiempo no transcurra. Todo observador, para serlo, debe disponer de una regla de medida de distancias y de un reloj para medir tiempos. Todo reloj tiene que estar formado por objetos masivos (espejos) entre los que hace tic-tac una señal luminosa (fotones). Por tanto, un objeto sin masa (un fotón o el vacío o similar) no puede ser un observador.

Ligeia pregunta: «Hace poco estuve en una charla de sistemas cuánticos abiertos en cosmología, ¿saben algo de esto?» Contesto que el universo en su conjunto tiene que ser un sistema cuántico cerrado, porque no tiene entorno (por definición de universo). Desde un punto de vista práctico, se llama entorno a la parte de un sistema cuántico que no se puede describir mediante la ecuación de Schrödinger. Todo sistema cuántico abierto se puede separar en un parte descrita por la ecuación de Schrödinger (un sistema casi-cerrado) y por una parte no descrita por ella (el entorno que influye en el sistema casi-cerrado). Para el universo en su conjunto no tiene sentido la separación. Ahora bien, algunos cosmólogos especulan con un universo cuántico abierto; pero estas especulaciones tienen poco recorrido (en mi opinión).

Antoni Lozano pregunta en un correo al programa: «Héctor dijo que el universo tuvo un tamaño de un metro cúbico, ¿se refería al universo observable?» Héctor que contesta que sí, que se refería al universo observable. Para z = 2 el universo observable tenía un volumen z+1 = 3 veces más pequeño que su tamaño actual. Dado que el radio actual del universo observable es de ~45 mil millones de años luz y un añoz luz son ~9 billones de kilómetros, el universo tiene un radio de 5 × 10²⁶ metros. Por tanto, el universo tenía un radio de un metro para z = 5 × 10²⁶ (esto es una aproximación grosera, un cálculo riguroso es imposible de realizar a día de hoy).

DDV2 Nine pregunta: «¿Extrapolamos la linealidad de la dependencia entre masas hasta que redshift? ¿Que haya agujeros negros primordiales marca que la extrapolación es poco sensible? ¿Son pastores intergalácticos?» Gastón contesta que Loeb estudia el caso z > 4. La extrapolación de linealidad es del universo local, pero Gastón ignora hasta qué redshift. Héctor destaca que no se extrapola para agujeros negros primordiales, sino para agujeros negros supermasivos. Puedo comentar ahora para z = 0.4 ya hay pequeñas desviaciones respecto a la linealidad (Xuheng Ding, John Silverman, …, Jeyhan S. Kartaltepe, «The Mass Relations between Supermassive Black Holes and Their Host Galaxies at 1 < z < 2 with HST-WFC3,» The Astrophysical Journal 888: 37 (06 Jan 2020), doi: https://doi.org/10.3847/1538-4357/ab5b90).

Gabriel Espin pregunta: «¿Por qué el centro de una galaxia no tiene que coincidir con la posición de su agujero negro supermasivo principal? ¿Atrás en el tiempo deberían coincidir sus centros?» Contesto que en el canibalismo galáctico los SMBH no están en el centro de las galaxias y que como resultado de fusiones de galaxias se han observado desviaciones. Héctor comenta que, además, el centro de una galaxia no está bien definido, pues depende del halo de materia oscura, entre otras cosas. Se puede llamar centro a la zona más luminosa, o al mínimo del pozo de potencial gravitacional (que es donde acaba situándose el SMBH). Hay muchos efectos que influyen, como la fricción gravitacional, que estratifican los objetos alrededor del pozo de potencial. Por estas y muchas otras razones los SMBH no están en el «centro» de la galaxia.

¡Que disfrutes del podcast!

«algunos cosmólogos especulan con un universo cuántico abierto; pero estas especulaciones tienen poco recorrido (en mi opinión).»

Hace unos meses te pregunté lo mismo.

https://francis.naukas.com/2023/09/22/podcast-cb-syr-430-noctalgia-contaminacion-luminica-y-consciencia-en-inteligencia-artificial/#comment-476760

Me dijiste que la función de onda de Wheeler y De Witt resolvía el asunto porque, al contrario que la de Schrödinger, no depende de la representación, ni de los observables.

De refilón, el jueves mencionaste que también hay cosmólogos, como Penrose (y Oppenheim), que especulan con un universo que no sea cuántico, no obedezca una ecuación determinista, ni su evolución sea unitaria. También en otras ocasiones has manifestado tus reservas sobre esa posibilidad.

Aunque me queme hasta el hueso, no soltaré ese clavo ardiendo.

Francis, tu comentas que cuando se intenta separar los quark dentro de un núcleo ocurre que partir de cierta distancia y debido a la energía involucrada, en dicha acción de separación, surge un par quark-antiquark : del vacío de que campo surgen? Éste par de quarks siempre se aniquila o pueden permanecer como hadrones ?

Fernan, lo primero, no se trata de separar los quarks de un núcleo, sino de un hadrón, sea mesón (pión, kaón, etc.) o barión (protón, neutrón, etc.); quizás te confundió que dijera nucleón, el nombre común a un protón y un neutrón (que para la interacción fuerte son indistinguibles).

La interacción fuerte, a diferencia de la electromagnética, crece conforme se alarga la distancia (y decrece conforme se acorta la distancia, la llamada libertad asintótica). Al intentar separar los dos quarks de un mesón (un quark y un antiquark «unidos por una cuerda de campo gluónico»), o un quark de un nucleón (formado por tres quarks de valencia cuya «analogía cuerdística» es menos clara), la energía asociada al vacío de los campos de quarks y gluones crece hasta superar la energía asociada a la masa de un par quark-antiquark; como resultado, surge un par quark-antiquark del vacío (una fluctuación de punto cero de dicho vacío se transforma en dicha pareja de quarks), con lo que el mesón se transforma en dos mesones (o en el caso del nucleón en un nucleón y un mesón).

Por tanto, dicho par quark-antiquark no se aniquila, todo lo contrario, surge como un par quark-antiquark virtual (off-shell) y se transforma en un par quark-antiquark (on-shell). Este proceso se llama hadronización (formación de mesones y bariones a partir de las fluctuaciones cuánticas del vacío del campo cuando la desndidad de energía es suficientemente alta como para superar la barrera de masa del par quark-antiquark).

(una fluctuación de punto cero de dicho vacío se transforma en dicha pareja de quarks) Francis, alguna vez escuché algo parecido a eso como explicación en la formación del universo.

Juanfran, quizás te refiere a los modelos cosmológicos CPT invariantes, en los que aparecen un universo y un «antiuniverso» a partir de una fluctuación inicial del falso vacío primordial. Se trata de una especulación con poco recorrido en el campo de la cosmología actual (además, no es falsable, pues el «antiuniverso», por definición, está desconectado causalmente del universo, luego no produce ningún efecto observable en el universo).

Francis

Que piensas de este articulo

https://www.science.org/doi/10.1126/sciadv.adk1189

Matias, lo voy a comentar en el próximo episodio de Coffee Break.