Te recomiendo disfrutar del episodio 454 del podcast Coffee Break: Señal y Ruido [Acast A, Acast B; iVoox A, iVoox B; iTunes A y iTunes B], titulado “Ep454: Cola; Exoatmósferas; Gravedad; Tecnomarcadores; eROSITA», 07 mar 2024. «La tertulia semanal en la que repasamos las últimas noticias de la actualidad científica. En el episodio de hoy: Cara A: La pérdida de cola en humanos: (5:00). Calentamiento de atmósferas en exoplanetas de corto periodo por corrientes eléctricas (37:10). Cara B: El experimento de gravitación clásica en miligramos: (19:58). Longevidad de los tecnomarcadores y la ley de Lindy (43:13). El resultado de eRosita sobre S8 (1:10:28). Señales de los oyentes (1:38:58). Imagen de portada realizada por Héctor Socas. Todos los comentarios vertidos durante la tertulia representan únicamente la opinión de quien los hace… y a veces ni eso».

¿Quieres patrocinar nuestro podcast como mecenas? «Coffee Break: Señal y Ruido es la tertulia semanal en la que nos leemos los papers para que usted no tenga que hacerlo. Sírvete un café y acompáñanos en nuestra tertulia». Si quieres ser mecenas de nuestro podcast, puedes invitarnos a un café al mes, un desayuno con café y tostada al mes, o a un almuerzo completo, con su primer plato, segundo plato, café y postre… todo sano, eso sí. Si quieres ser mecenas de nuestro podcast visita nuestro Patreon (https://www.patreon.com/user?u=93496937); ya sois 174, muchas gracias a todas las personas que nos apoyan. Recuerda, el mecenazgo nos permitirá hacer locuras cientófilas. Si disfrutas de nuestro podcast y te apetece contribuir… ¡Muchísimas gracias!

Descargar el episodio 454 cara A en Acast.

Descargar el episodio 454 cara B en Acast.

Como muestra el vídeo (y su continuación tras el inesperado corte) participamos por videoconferencia Héctor Socas Navarro @HSocasNavarro (@pCoffeeBreak), José Edelstein @JoseEdelstein, y Francis Villatoro @emulenews. Por cierto, agradezco a Manu Pombrol @Manupombrol el nuevo diseño de mi fondo para Zoom; muchas gracias, Manu.

Tras la presentación de Héctor, me toca comentar el primer tema, la pérdida de cola en humanos. Quizás no sepas que los humanos tenemos cola, que aparece al final de la cuarta semana del desarrollo embrionario, pero que desaparece al inicio de la octava semana, dejando un vestigio de cola, el coxis en el que acaba tu columna. El mecanismo genético por el que se retrae la cola es desconocido. Como todo rasgo complejo, su origen de debe ser poligénico. Se han identificado 140 genes asociados a que un ratón pierda su cola o la desarrolle con un tamaño reducido. El papel de uno de dichos genes, TBXT, que en humano está en el cromosoma 6, se ha desvelado en un artículo publicado en Nature. Los primates hominoides (sin cola) tienen insertada una secuencia Alu (llamada AluY) en el intrón 5 del gen TBXT; los primates no hominoides (la mayoría con cola) carecen de dicha secuencia Alu, que apareció hace unos 25 millones de años. La secuencia AluY se acopla a otra secuencia Alu (llamadaAluSx1) en el intrón 6; siendo una secuencia muy similar, pero invertida, AluY y AluSx1 se pueden acoplar induciendo un bucle en el ARN transcrito que acerca los exones 5 y 7, pero aleja el exón 6; como resultado se produce un ayuste (corte y empalme) alternativo de la proteína Tbxt sin el exón 6 (con los exones 1–5, 7 y 8). En modelos de ratón un cambio similar en este gen produce la pérdida de la cola. Por ello se concluye que el gen TBXT, que interviene en el desarrollo de la notocorda embrionaria, precursora de la columna vertebral, es clave en que los humanos adultos carezcamos de cola. Como efecto colateral, la isoforma Tbxt sin exón 6 induce defectos en el tubo neural de los ratones; algo que ocurre en uno de cada mil recién nacidos humanos. La pérdida de la cola pudo contribuir al bipedalismo, pero con un precio, un mayor riesgo de defectos en el tubo neural.

Las secuencias Alu son propias de los primates; los ratones carecen de estas secuencias. En los primeros experimentos se usaron ratones humanizados, en los que se modifica su genoma para que incluya el elemento AluY y el elemento AluSx1. Los resultados no fueron concluyentes, pues estos ratones humanizados mostraban todo el espectro del rasgo, desde ratones sin cola a ratones con cola completa. El experimento concluyente definitivo se logró simulando en los ratones el acoplamiento entre AluY y AluSx1; para ello se insertaron 297 pares de bases (la misma longitud que el AluY humano) del intrón 5, pero invertidos, en el intrón 6; esta emulación del mecanismo logró que todos ratones así modificados nacieran sin cola. Por supuesto, desvelar el rol del gen TBXT no resuelve el problema de la ausencia de cola en humanos. El mecanismo genético que explica la retracción embrionaria de la cola aún no ha sido explicado. Futuros estudios tendrán que desvelarlo gracias al estudio de otros genes entre los 140 genes candidatos (o incluso con otros aún por desvelar).

El artículo es Bo Xia, Weimin Zhang, …, Itai Yanai, «On the genetic basis of tail-loss evolution in humans and apes,» Nature 626: 1042-1048 (28 Feb 2024), doi: https://doi.org/10.1038/s41586-024-07095-8 («The genetic basis of tail-loss evolution in humans and apes,» BioRxiv preprint 460388, doi: https://doi.org/10.1101/2021.09.14.460388). Más información divulgativa en Miriam K. Konkel, Emily L. Casanova, «A mobile DNA sequence could explain tail loss in humans and apes,» Nature 626: 958-959 (28 Feb 2024), doi: https://doi.org/10.1038/d41586-024-00309-z; y en el curioso Ewen Callaway, «How humans lost their tails — and why the discovery took 2.5 years to publish,» News, Nature (28 Feb 2024), doi: https://doi.org/10.1038/d41586-024-00610-x. En este blog también puedes leer «El rol de una secuencia Alu del gen TBXT en que no tengas cola», LCMF, 02 mar 2024.

Nos cuenta Héctor un artículo en ApJ sobre el calentamiento de atmósferas en exoplanetas con órbita de periodo corto debido al viento estelar. Las órbitas de estos planetas con un periodo de pocos días están tan cerca de sus estrellas que sus atmósferas se ven influidas por las variaciones del campo magnético estelar en escalas de tiempo cortas. En su «ionosfera», la capa superior conductora y resistiva de su atmósfera, se generan corrientes que se disipan energía mediante el efecto de Joule, que calienta la atmósfera. Héctor nos dice que nos interesa estudiar las estrellas cercanas con exoplanetas, que son las enanas rojas, como Trappist-1. Estas estrellas son muy violentas y además sus exoplanetas suelen estar en acoplamiento de marea, luego les dan una cara a su estrella como la Luna a la Tierra. Además, están muy cerca (todos los exoplanetas de Trappist-1 están mucho más cerca su estrella que Mercurio al Sol), luego se mueven muy rápido. Así que estos exoplanetas se ven muy afectados por la actividad de su estrella.

La irradiación ultravioleta de la estrella es absorbida por la capa superior de la atmósfera (la ionosfera en la Tierra), que se calienta. La radiación UV es ionizante, luego libera cargas en la alta atmósfera, que generan corrientes eléctricas inducidas. Estas corrientes calientan la atmósfera por efecto Joule (como un cable se calienta al conducir corriente). En la Tierra (1 UA) el flujo de energía por efecto Joule produce un calentamiento atmosférico del orden de 10⁻² W/m². Para órbitas solares con radio 0.05 y 0.1 UA es de 2.74 × 10⁴ W/m² y 1.37 × 10⁴ W/m², resp., debido a la irradiancia solar en el ultravioleta extremo (EUV) de pocos 10⁻³ W/m². En el caso de Trappist-1 el flujo de energía en EUV en la órbita de Trappist-1e está entre 867 y 0.3 W/m², luego el calentamiento atmosférico es mucho más intenso. En estos exoplanetas, el flujo de calor en su ionosfera podría ser similar, o incluso mayor, que el flujo de calor irradiado en la superficie del sol gracias a la emisión infrarroja solar.

La figura muestra resultados del código AWSoM (Alfvén Wave Solar Model) comparando el efecto en Trappist-1e (0.028 UA) con dos órbitas circulares a 0.05 UA y 0.1 UA bajo el viento solar durante la llamada Rotación de Carrington de 1916, que representa las condiciones mínimas del viento solar. El campo magnético alrededor de Trappist-1e es del orden de 1000 nT, aunque cae a 600 nT (en los cruces con la «serpentina» de color rojo). En las órbitas solares a 0.05 y 0.1 UA el campo magnético está entre 700–900 nT, y 50–100 nT, resp. (los valores mínimos son en los cruces de las «serpentinas» de color azul oscuro). Para Trappist-1e, la variación máxima del campo dB/dt es de ±0.4 nT/s, para la órbita solar de 0.05 UA es ±0.1 nT/s.

En los exoplanetas de enanas rojas, como los de Trappist-1, el calentamiento atmosférico produce una pérdida de la atmósfera en poco tiempo. El artículo es Ofer Cohen, …, Cecilia Garraffo, …, Farah Fauth Puigdomenech, «Heating of the Atmospheres of Short-orbit Exoplanets by Their Rapid Orbital Motion through an Extreme Space Environment,» The Astrophysical Journal (ApJ) 962: 157 (16 Feb 2024), doi: https://doi.org/10.3847/1538-4357/ad206a, arXiv:2401.14459 [astro-ph.EP] (25 Jan 2024). Por cierto, Cecilia Garraffo realizó su tesis doctoral bajo la supervisión de Gastón Giribet («Agujeros negros y solitones gravitatorios en teorías de gravedad con términos superiores en la curvatura,» Universidad de Buenos Aires, 2009 [PDF]).

Me toca comentar un experimento de gravitación clásica en la escala de nanonewtons publicado en Science Advances. La gravitación cuántica describe la naturaleza cuántica del espaciotiempo. Los efectos cuánticos asociados solo son observables en la escala de Planck; para un «objeto material» corresponde a una masa de 22 μg y una densidad de 10⁹³ g/cm³. Si se usa un objeto material, cuya densidad será muy inferior a 10² g/cm³, solo se podrá explorar la gravitación clásica; ni siquiera si los estados de dicho objeto están en superposición cuántica. Se publica en Science Advances una medida experimental de una fuerza gravitatoria de 30 aN (attonewtons) entre una masa de 2.45 kg y una pequeña masa de 430 μg enfriada a 30 mK situada a 48 ± 4 cm de distancia. A dicha distancia la fuerza newtoniana es de 1030 aN, pero se ha medido una fuerza mucho más pequeña gracias a poner la masa de 0.43 mg a vibrar a 27 Hz mientras levita en una trampa magnética generada por un superconductor. Un experimento muy ingenioso que promete ser el primer paso para una futura medida usando una masa con unos 22 μg, la masa de Planck. Como es obvio, si se logra, solo permitirá explorar la gravitación clásica de Newton. La única que aplicable en este tipo de experimentos de laboratorio.

En diferentes medios, amparados en comentarios de los autores del artículo en Science Advances, se afirma que estamos más cerca de resolver el problema de la gravitación cuántica, incluso que se ha dado un gran paso para estudiar en laboratorio los efectos cuánticos de la gravitación. Me apena tener que repetir que no es así y que no puede ser así. Con este tipo de experimentos se podrían confirmar las predicciones de la ecuación de Schrödinger cuando se incluye el potencial gravitatorio de Newton en la superficie de la Tierra, la llamada ecuación de Schrödinger–Newton. Pero esto no ayudará a desvelar la naturaleza de la futura teoría cuántica de la gravitación. El nuevo estudio es uno de los muchos que pretenden acercarnos al régimen descrito por esta ecuación (la figura de la izquierda (arXiv:2311.09218 [quant-ph]) resume los experimentos más relevantes en esta línea, con el nuevo experimento marcado como Leiden ’23). El nuevo experimento es todo un alarde técnico, que usa las últimas técnicas metrológicas para la detección ultrasensible de sistemas mecánicos oscilantes en levitación. Sin embargo, no brilla con luz propia ni por la magnitud de la masa probada, ni por la sensibilidad a fuerzas pequeñas (normalizada por la frecuencia de oscilación).

Todo avance es relevante. Nadie puede prever las sorpresas que nos deparen los experimentos de laboratorio. Pero debemos ser cautos a la hora de exagerar las consecuencias de uno concreto, que destaca por ser el más reciente. El artículo es Tim M. Fuchs, Dennis G. Uitenbroek, …, Tjerk H. Oosterkamp, «Measuring gravity with milligram levitated masses,» Sciene Advances 10: adk2949 (23 Feb 2024), doi: https://doi.org/10.1126/sciadv.adk2949, arXiv:2303.03545 [quant-ph] (06 Mar 2023); otro estudio reciente (marcado en la figura como Vienna ’23) es J. Hofer, R. Gross, …, M. Aspelmeyer, «High-Q Magnetic Levitation and Control of Superconducting Microspheres at Millikelvin Temperatures,» Phys. Rev. Lett. 131: 043603 (25 Jul 2023), doi: https://doi.org/10.1103/PhysRevLett.131.043603.

Nos presenta Héctor un artículo sobre la longevidad de los tecnomarcadores (la duración de la actividad tecnológica de una civilización extraterrestre) que usa la ley de Lindy (que es el nombre de un restaurante, una anécdota que explica Héctor en el podcast). Esta ley afirma que, en cualquier momento, la esperanza de vida futura de algo es proporcional a la edad de dicho algo (por ejemplo, afirma que Don Quijote de la Mancha seguirá siendo un libro muy vendido cuando Harry Potter ya haya sido olvidado). Aplicando la ley de Lindy, el primer tecnomarcador detectado debería tener una vida muy larga. Se suele llamar tecnoemisión a un tecnomarcador cuya longevidad es similar a la de su civilización responsable, porque requiere una intervención y un mantenimiento continuo. Sin embargo, hay tecnomarcadores, como los restos de las megaestructuras, que pueden tener una longevidad mucho mayor que la de su civilización (incluso hasta miles de millones de años). Un buen ejemplo son las megaestructuras de astroingeniería, como las esferas Dyson o los exocinturones de Clarke (propuestos por Héctor; LCMF, 16 feb 2018).

De hecho, según simulaciones de Héctor aún no publicadas, sus exocinturones de Clarke (satélites en órbita geostacionaria) pueden tener longevidades superiores a muchos millones de años. El llamado «cementerio geostacionario», formado por basura espacial en órbita geoestacionaria. Gracias a este tipo de cálculos, el tecnomarcador de Héctor se posiciona como uno de los interesantes para detectar civilizaciones de tipo I en la escala de Kardashov (ya que las esferas de Dyson requieren una civilización de tipo II). Por pura estadística, los exocinturones de Clarke podrían ser el primer tecnomarcador detectado (si Héctor prueba con sus simulaciones que tienen una longevidad de decenas de millones de años; está trabajando en ello). Héctor aprovecha para comentarnos un artículo en arXiv de Balbi y Grimaldi sobre el impacto de la ley de Lindy en la búsqueda de tecnomarcadores en función de las distribuciones de probabilidad para su longevidad. Como bien culmina Héctor, en este tipo de cálculos se están «haciendo juegos malabares con nuestra ignorancia». El artículo es Amedeo Balbi, Claudio Grimaldi, «Technosignatures Longevity and Lindy’s Law,» The Astronomical Journal (AJ) 167: 119 (20 Feb 2024), doi: https://doi.org/10.3847/1538-3881/ad217d.

Me toca comentar el resultado de eROSITA sobre la tensión S₈ en cosmología (CB SyR 431). El telescopio espacial eROSITA (extended ROentgen Survey with an Imaging Telescope Array) está instalado junto al telescopio ART-XC (Astronomical Roentgen Telescope X-ray Concentrator) en el satélite SRG (Spektr-RG, por Spectro-Rayos-X-Gamma) que fue lanzado el 13 de julio de 2019 por Roscosmos. Estos dos telescopios de rayos X exploran el rango de energía entre 0.5 y 10 KeV (eRosita) y entre 5 y 30 keV (ART-XC). Héctor aprovecha para comentarnos varias curiosidades sobre la colaboración entre Alemania y Rusia detrás de esta misión, al hilo de un posible acto de piratería espacial. Yo me centro en que, en febrero de 2024, se han publicado los primeros resultados de eRosita (el llamado eRASS1 por SRG/eROSITA All-Sky Survey Data Release 1) en 49 artículos científicos (más otros 10 publicados en 2024). Yo solo comento el artículo con los resultados cosmológicos: V. Ghirardini, E. Bulbul, …, I. Stewart, «The SRG/eROSITA All-Sky Survey: Cosmology Constraints from Cluster Abundances in the Western Galactic Hemisphere,» A&A (2024), arXiv:2402.08458 [astro-ph.CO] (13 Feb 2024), doi: https://doi.org/10.48550/arXiv.2402.08458. El resto de artículos se pueden disfrutar en la web eROSITA.

La gravitación es atractiva, lo que hace que las galaxias de los cúmulos galácticos se acerquen y que el gas intergaláctico entre ellas se caliente emitiendo rayos X, que puede observar eROSITA. El gran resultado de eRASS1 es que los parámetros cosmológicos basados en cúmulos galácticos con 0.1 < z < 0.8 están perfecto acuerdo con las estimaciones cosmológicas del telescopio espacial Planck con z = 1100. Un resultado que reafirma el modelo cosmológico de consenso ΛCDM. En particular, la tensión para el parámetro S₈ observada por DES, KiDS y HSC, desaparece con los datos de eROSITA. El telescopio eROSITA ha explorado una región de cielo de 12791 deg² (grados cuadrados), que es un tercio del cielo (41253 deg²). Lo más relevante es que dicha región incluye las regiones más pequeñas estudiadas por DES (Dark Energy Survey), HSC Y3 (Hyper Supreme-Cam Subaru Strategic Program) y KiDS (Kilo Degree Survey). En cada una de dichas regiones pequeñas el resultado de eROSITA es compatible con los resultados de DES, HSC Y3 y KiDS, que mostraban la tensión S₈ a unas cuatro sigmas. Sin embargo, en la región completa estudiada por eROSITA la tensión desaparece y se obtiene un resultado compatible con Planck (que difiere a menos de dos sigmas). Una prueba de que la tensión S₈ era resultado de un sesgo observacional (usar una región demasiado pequeña de cielo).

Los resultados de eROSITA para los parámetros cosmológicos son los siguientes: Ωₘ = 0.29 ± 0.02, σ₈ = 0.88 ± 0.02 y S₈ = 0.86 ± 0.01, en muy buen acuerdo con los datos de Planck. Además, se estima la suma de la mas de los neutrinos ∑m(ν) < 0.22eV (95 % CL), una estimación tan buena como la de Planck. De hecho, este buen acuerdo permite combinar eROSITA con Planck para obtener como estimación ∑m(ν) < 0.11 eV (95 % CL). Este valor es muy relevante porque favorece la escala de masas normal (que predice ∑m(ν) < 0.1) en contra de la invertida (∑m(ν) > 0.1) a más de dos sigmas. eROSITA también ha estimado la ecuación de estado de la energía oscura, obteniendo w = −1.12± 0.12, en muy buen acuerdo con la predicción w = −1 del modelo ΛCDM. Sin lugar a dudas eROSITA ha hecho una contribución muy relevante en cosmología.

Y pasamos a Señales de los Oyentes. Por correo pregunta Michel desde Morelia (México): «Entiendo que los neutrinos solares [con energía en la escala de los MeV] son inofensivos por su poca interacción con materia ordinaria… ¿qué pasa con con los neutrinos de alta energía [que alcanzan los PeV]?» Comento que los neutrinos interaccionan muy poco con la materia a todas las energías exploradas (el cambio en el acoplamiento con la energía es muy pequeño, menor de un orden de magnitud). Así que tanto los neutrinos solares, como los neutrinos de energía ultraalta (UHE) son igual de inofensivos.

McSilver comenta que: «Los neutrinos son una unión entre la materia oscura y la materia bariónica». Héctor contesta que los neutrinos contribuyen a la materia oscura. Comento que, como ignoramos la masa de los neutrinos, no sabemos cuánto contribuyen, pero se suele estimar su contribución entre 0.01 % y el 0.1 % a la densidad total de energía del universo (lo que implica entre un 0.3 % y un 3 % de la densidad total de energía de la materia Ωₘ, que recuerda que es un 80 % de materia oscura, en el que entrarían los neutrinos, y un 20 % de materia bariónica).

Paco pregunta: «Dos fotones que se separen entre sí, ¿al hacen al doble de la velocidad de la luz uno respecto del otro?» Contesto que que sí, pero se trata de una velocidad relativa aparente. Héctor dice que en el chat comentan que si es lo mismo que pasa con los chorros relativistas; él contesta que así es, la proyección en el cielo del chorro aparenta moverse a una velocidad mayor que la luz en el vacío, pero solo es algo aparente. Comento que la velocidad de la luz en el vacío es la máxima para cualquier cosa que tenga energía. Pero que no hay ningún límite físico para la velocidad aparente (que en Física se llama velocidad de fase).

Antonio por correo pregunta: «Sería muy difícil taladrar la superficie helada de Encélado (varios kilómetros de hielo). Esto le recuerda el síndrome de China, la hipotética fusión del núcleo de un reactor nuclear cuyo material fundido atravesaría las barreras de hormigón o cemento y podría atravesar corteza de la Tierra hasta alcanzar las antípodas». Héctor comenta que este método no se puede usar para atravesar la superficie helada de Encélado porque el núcleo de uranio del reactor de fisión es demasiado pesado para llevarlo en un nave hasta Encélado. Héctor exagera afirmando que, para el síndrome de China, se requieren cientos de toneladas de uranio; el núcleo de los reactores de fisión suele contener unos cientos de kilogramos de uranio (como mucho). A pesar de ello tiene razón, perforar Encélado con este método es inviable.

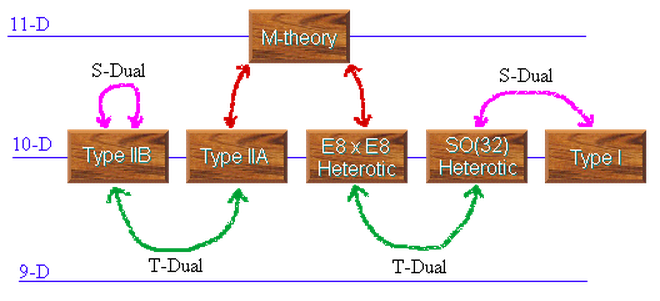

Tomás Villa pregunta: sobre la simetría (dualidad) S en teoría de cuerdas, que relaciona el régimen de acoplamiento fuerte (g >> 1) de una teoría de cuerdas con el régimen de acomplamiento débil (g << 1) de otra teoría de cuerdas (la dualidad S transforma el acoplamiento g en 1/g). Comento que la dualidad S entre dos teorías implica que coinciden el número de sus estados físicos para g = ∞ en una teoría con g = 0 en la otra teoría. Por desgracia, no sabemos usar la dualidad S para realizar cálculos prácticos en teoría de cuerdas con g finito (0 < g < ∞). Todos soñamos con que en un futuro se desarrollen herramientas matemáticas que nos permitan realizar este tipo de cálculos. Pero ahora mismo es imposible hacerlo.

comenta: «

Thomas Villa pregunta: «¿Podrían existir estrellas de neutrinos?» Héctor contesta que no parece posible. Yo contesto que sería necesaria alguna interacción fundamental nueva que pudiera ligar los neutrinos, bajo ciertas circunstancias, para dar lugar a materia estable. Quizás algún tipo de condesado bosónico formado por pares de Cooper entre neutrinos, similares a lo que pasa en los superconductores.

ontesta Héctor que estos elementos no se forman en la fusión (el funcionamiento estable del núcleo estelar) sino en otros procesos estelares. Gracias a las nucleosíntesis estelares llamadas proceso s y proceso r en fenómenos violentas como las kilonovas o las explosiones de supernovas.

¡Que disfrutes del podcast!

Dada la sensibilidad de la nueva medicion de la fuerza gravitatoria, puede mejorarse la estimacion del limite superior para teorias del tipo MOND?

Gracias Francis, siempre articulos interesantes.

Alejol9, en principio, este tipo de experimentos pueden explorar la idea MOND. De hecho, si calculas la aceleración sobre un cuerpo de 0.43 mg debida a fuerza de 30 aN obtendrás una aceleración 30e-18 / 0.43e-6 = 7.0e-11 < 1.2e-10 m/s², que es menor que la aceleración mínima de MOND. Sin embargo, como los 30 aN se calculan en régimen oscilatorio y lo relevante para MOND es la aceleración estática, en este caso sería 1030e-18 / 0.43e-6 = 2.4e-9 < 1.2e-10 m/s². Cuando se logre medir una aceleración estática inferior a 1.2e-10 m/s² se podrán usar estos experimentos para descartar la idea MOND.

Entonces si se refina el.experimento para medir aceleracion un orden de magnitud menor y el regimen oscilatorio se hace a una frecuencia mucho mas baja, digamos decimas de Hertz, podria poner un limite superior a MOND?

Alejol9, en rigor, la idea MOND de Milgrom requiere un sistema de referencia en reposo absoluto. Si aplicas MOND a un oscilador obtienes un objeto exótico (Mihail-Ioan Pop, «The Milgrom oscillator,» Bull. Transilv. Univ. Bras. III: Math. Inform. Phys. 2: 279-288 (2009), https://webbut.unitbv.ro/index.php/Series_III/article/view/2169); tan exótico que ha sido descartado por infinidad de experimentos de laboratorio. De hecho las aceleraciones más pequeñas medidas en laboratorio son de 5 × 10⁻¹⁴ m/s², unos cuatro órdenes de magnitud inferiores a la aceleración MOND (J. H. Gundlach, S. Schlamminger, …, E. Fischbach, «Laboratory Test of Newton’s Second Law for Small Accelerations,» Phys. Rev. Lett. 98: 150801 (13 Apr 2007), doi: https://doi.org/10.1103/PhysRevLett.98.150801); todos estos experimentos refutan la idea MOND. Por desgracia, ningún mondiano acepta estos experimentos, ni mucho menos el que propones, como método para probar la idea MOND en laboratorio; la razón es que en ninguno de estos experimentos se usa un sistema de referencia en reposo absoluto (en otras razones, porque dichos sistemas de referencia no existen; a pesar de que se usan en cosmología, gracias al CMB, donde se aplica la idea MOND).

Me surje una duda muy estúpida, Francis…sobre el experimento imposible hoy por hoy de medir la gravedad en escalas cuánticas; la duda es la siguiente: siendo como es posible emular procesos cuánticos en una computadora clásica, ya con matemáticas, ya incluso trabajando los procesadores en paralelo…etc…es decir, emularlo dentro del mundo abstracto ¿No se podría hacer algo similar en el mundo físico? Es decir, ¿no existirá alguna dualidad entre aquello que no puedo hacer a escalas cuánticas, al no tener la tecnología, con algo que sí puedo hacer en escalas clásica? Estoy imaginando que realizamos una serie de pasos experimentales, físicos, no en computadora, reales, con imanes, láseres, partículas…etc cuyo resultado final, cuyas medidas finales, fueran las mismas que si hubiéramos trabajado realmente con párticulas en la escala de plank…¿Tiene sentido esto que digo?

Pedro, supongo que te refieres a simular un sistema cuántico usando un ordenador (sea digital o analógico, lo que mencionas como «experimento»). Se puede hacer, sin problemas, con la única limitación de que el coste computacional es PSPACE, luego está limitado a sistemas físicos muy pequeños (con muy pocos grados de libertad). Usando usando ordenadores cuánticos se podría ir más lejos, pero solo un poco más, pues por ahora solo alcanzan un número muy bajo de cúbits. Ahora bien todas estas simulaciones están limitadas por nuestras teorías, es decir, solo puedes simular un modelo teórico (sea el que sea); no puedes simular la Naturaleza, per se. Por ello, hasta que no sepa mediante experimentos u observaciones cuál es la teoría correcta de la gravitación cuántica, no se podrán realizar simulaciones físicamente realistas en gravitación en cuántica.

«A pesar de ello tiene razón, perforar Encélado con este método es inviable.»

¿Inviable por que?

No solo con reactores, hay proyectos donde perforan el hielo simplemente con RTG.

Y de hecho en los reactores diseñados para labores en superficie en lunas heladas, no diseñados para fundir el hielo, una de las preocupaciones es que con el tiempo perforen y «contaminen» de vida terretre el oceano subterraneo.

En google schoolar aparecen proyectos con RTG etc para perforar hielo en Encelado.

En cuanto a lo de que el Uranio pesa mucho para llevarlo en una sonda parece una broma.

Bueno, precisamente en Encelado de todas formas lo mas facil es aprovechar los geiseres para tomar muestras de ello, sin necesidad perforar/fundir hielo. Lo de perforar por calor+gravedad sería mejor para otras lunas heladas donde no hay la suerte de contar con geiseres que ya hacen todo el trabajo de extraer material del oceano.

Esperemos, Fernando, que tengas razón y perforar las lunas heladas se pueda lograr en este siglo. Yo dudo mucho que se logre (así que yo no lo veré).